GPT-5.2-Codexとは、OpenAIが提供する最新のコーディングに特化したモデルです。

高い性能を誇ったGPT-5.1-Codexからさらに性能が向上し、サイバー防御にも優れたモデルとなりました。

この記事では、GPT-5.2-Codexの使い方や料金について解説します。

性能やセキュリティ面についてもご紹介するので、気になる方はぜひご覧ください。

GPT-5.2-Codexとは?概要と性能

まずはGPT-5.2-Codexの概要やその性能についてご紹介します。

GPT-5.2-Codexの概要

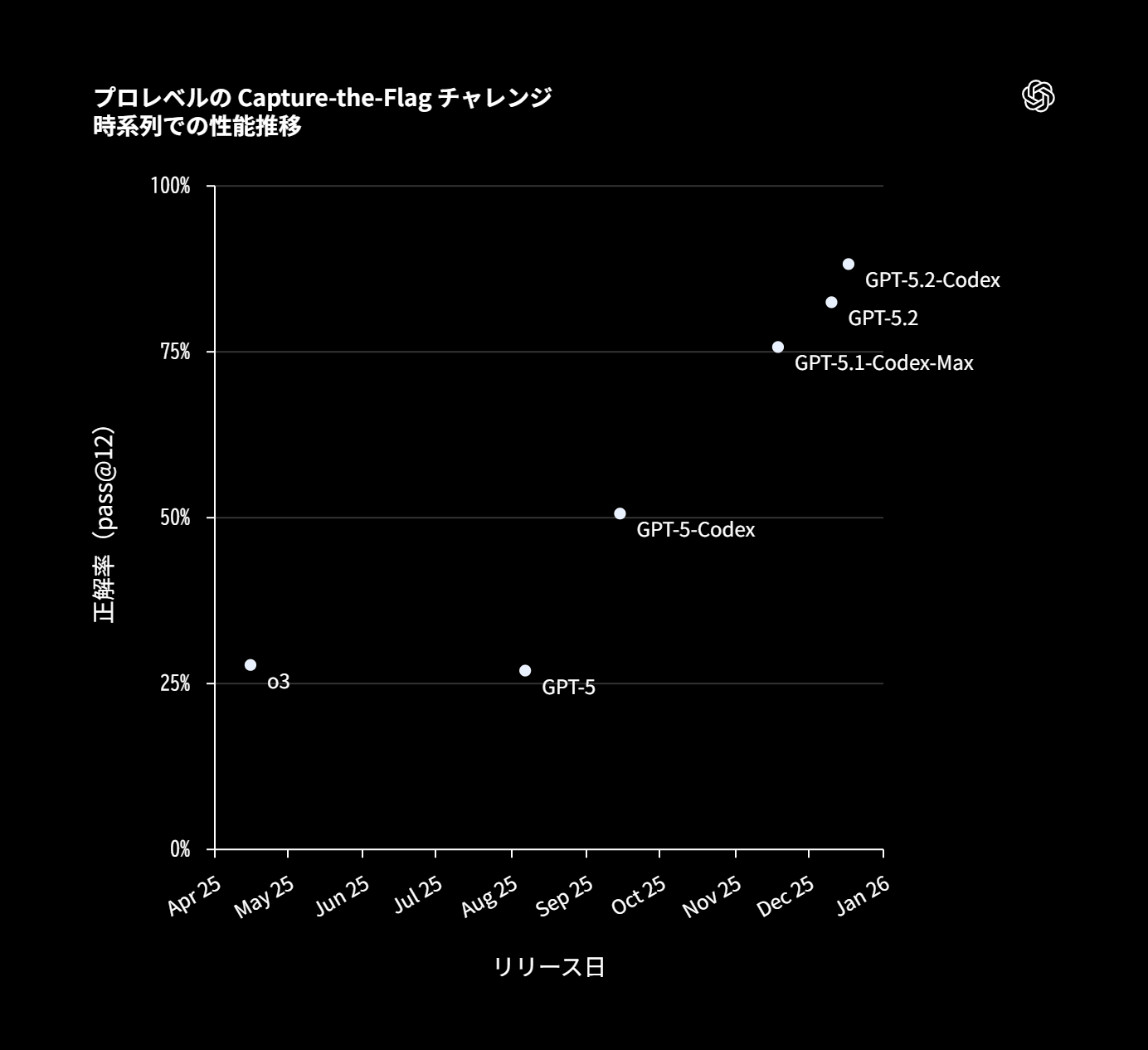

GPT-5.2-Codexは、2025年12月にOpenAIからリリースされた、実務レベルの自律型エージェント開発に特化した最新のコーディングモデルです。

汎用モデルであるGPT-5.2をベースに、大規模なコードベース操作や長期的なタスク遂行能力が強化されており、従来のチャット形式を超えた「エージェント型コーディング」を実現しています。

最大の特徴はコンテキスト圧縮と呼ばれる技術で、長時間の作業でも文脈を圧縮・保持し、記憶を損なうことなく複雑な手順を実行し続けることが可能です。

また、Windows環境への最適化や、スクリーンショットからUIコードを生成するビジョン機能の向上も図られています。

これにより、単なるコード補完にとどまらず、環境構築からテスト、デバッグまでを一貫して任せられ、サイバーセキュリティ分野での防御的利用も想定された堅牢な設計となっています。

想定ユースケース

本モデルは、ファイル単体の修正ではなく、リポジトリ全体に影響が及ぶ大規模リファクタリングやフレームワークの移行といった、広範な依存関係の理解が必要なタスクで真価を発揮します。

開発現場では、Gitの操作からテスト実行、ログ解析までを自律的に行うDevOpsエージェントとしての利用が想定されており、特に人間が介入する頻度を減らした長期的なバックグラウンド処理に適しています。

チーム利用においては、過去の膨大なプルリクエストやドキュメントを記憶としてより長く参照できるため、新メンバーのオンボーディング支援や、レガシーコードの仕様解析といったナレッジワークの自動化にも貢献します。

さらに、強化されたセキュリティ機能により、脆弱性診断やセキュアコーディングの監査役として、CI/CDパイプラインに組み込む運用も推奨されます。

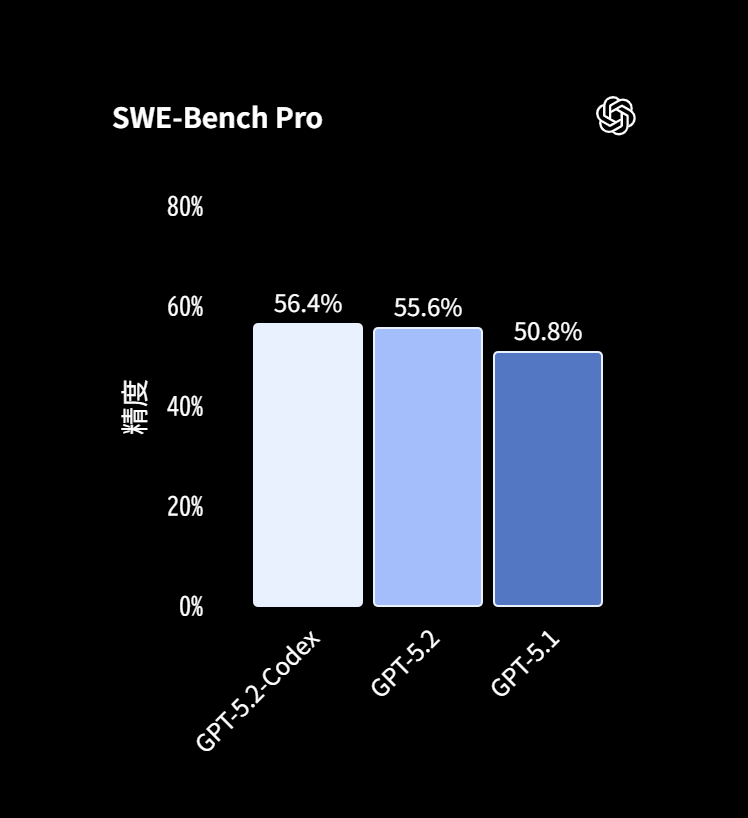

ベンチマークから見る性能と実務上のポイント

実務的なソフトウェアエンジニアリング能力を測るベンチマークのSWE-Bench Proにおいて、GPT-5.2-Codexは56.4%というスコアを記録し、汎用版のGPT-5.2や前世代のGPT-5.1を上回る、高い課題解決能力を示しました。

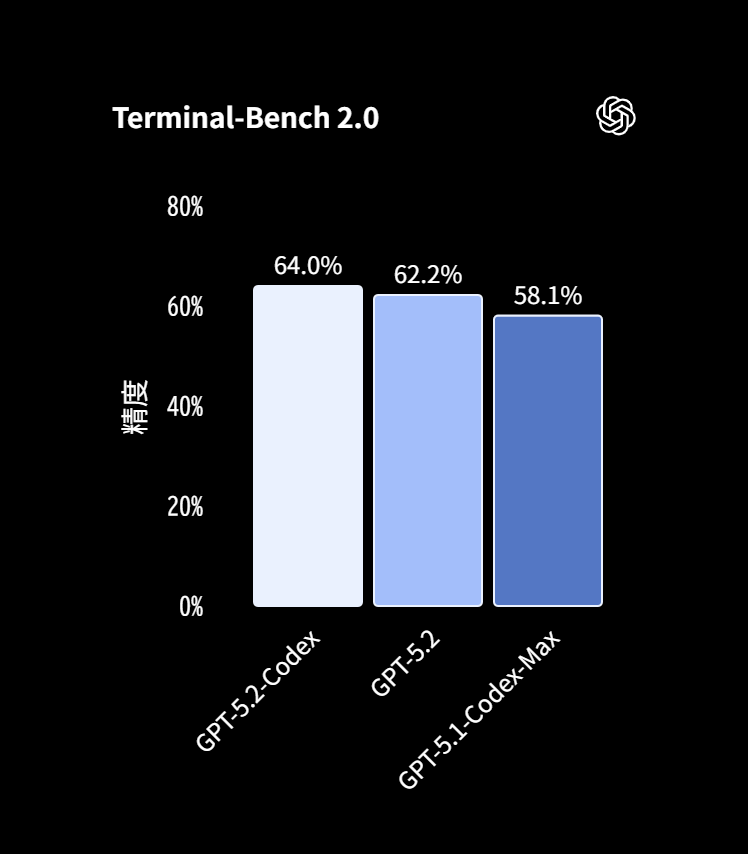

また、ターミナル操作を含むタスク評価のTerminal-Bench 2.0では64.0%を達成しています。これは環境構築やサーバー設定といったコマンド操作を伴う試行錯誤において、他モデルよりも正解に辿り着けることを意味します。

実務上の観点では、コンテキストウィンドウの処理効率が改善されたことで、数千行に及ぶ変更セットを扱う際もハルシネーションを起こしにくく、コストパフォーマンスと精度のバランスが長時間のタスク遂行に最適化されています。

競合となるGemini 3 ProやClaude Opus 4.5と比較しても、特に複雑なアルゴリズムの実装や既存プロジェクトへの整合性維持において、信頼性の高い選択肢の一つとなっています。

GPT-5.2-Codexのセキュリティ能力

Codexモデルは、サイバーセキュリティ性能においても高い性能を誇ります。

ここでは、GPT-5.2-Codexのセキュリティ能力について解説します。

サイバー防御に優れる理由

GPT-5.2-Codexは、複雑な実務コードを扱うエージェント型コーディングの強化が、そのまま防御的なセキュリティ業務にも効く設計です。長期タスクで文脈を保ちながら、調査と修正を往復する作業に強く、修正や移行のような大きい差分にも耐えるため、検知ルール整備や修正パッチの作成といった防御ワークフローを回しやすくなります。

これまで提供した中で最もサイバー能力が高いモデルとなっています。

教育目的や防御目的には最大限役立てつつも、悪用につながる運用レベルの手順は抑える方針が示されています。

GPT‑5.2-Codex は、段階的な提供と安全対策を組み合わせ、セキュリティコミュニティと連携しながら、防御面での効果を高めつつ、悪用のリスクを抑えることを目指しています。

出典:GPT-5.2-Codex が登場

防御側で価値が出やすいのは、脆弱性の再現、パッチ妥当性確認、インシデント対応の調査補助のように、似た操作を反復しつつ確実性が求められる領域です。

加えて、守る側を強化する取り組みとして、信頼できる防御用途へのアクセス設計や、エコシステム側の防御力を上げる方向性も示されています。

安全性

高いコーディング能力とサイバー領域の支援能力は、防御への貢献と同時にデュアルユースのリスクも伴うため、OpenAIは慎重な提供方針と追加の安全対策を前提にしています。

具体的には、教育・セキュリティ学習の支援にはできる限り有用に応答しつつ、マルウェア作成、資格情報の不正取得、連鎖的な侵害につながる運用的な悪用ガイダンスは拒否または抑制するよう安全性学習が施されています。

さらに、エージェント実行環境のサンドボックス化や、ネットワークアクセスをデフォルトで無効にした上での設定可能な許可制御など、製品面の緩和策も組み合わせてリスク低減を図っています。

ただし、防御と攻撃は外形上似ることも多いため、正当な防御・研究を支えつつ、実運用で悪用され得る出力や連鎖的手順の提示を抑える、というバランス設計が課題でしょう。

運用ガードレール

Codexのセキュリティ制御は、サンドボックスで技術的にできることを制限し、承認ポリシーで実行前に人の確認を挟む、という二段階となっています。

ローカル実行では既定でネットワークを無効にし、書き込み範囲も作業ディレクトリ中心に絞る設計で、必要なときだけ承認して拡張します。一方クラウド実行は隔離されたコンテナで動き、ホストや無関係データに触れない前提で、環境セットアップ段階と実行段階の扱いも分けられています。

ネットワーク許可や検索機能の有効化は便利ですが、プロンプトインジェクションや資格情報漏えいのリスクがあるため、許可するなら信頼できるドメインのみに絞り、HTTPメソッドも制限する考え方がいいでしょう。

チーム運用では、ローカルとクラウドを別権限で管理し、RBACで利用範囲をロールごとに分け、管理者がインターネットアクセス許可などのトグルを統制する形が公式に案内されています。

またCLI運用では、承認を省略する設定とフル自動の運用を組み合わせない、必要なディレクトリだけ追加する、とすることがおすすめです。

GPT-5.2-Codexの使い方

続いて、GPT-5.2-Codexの使い方をご紹介します。

GPT-5.2-Codexは、Codex Webをはじめ、CLIやIDEでも利用可能です。

クラウドでの使い方:Codex Web

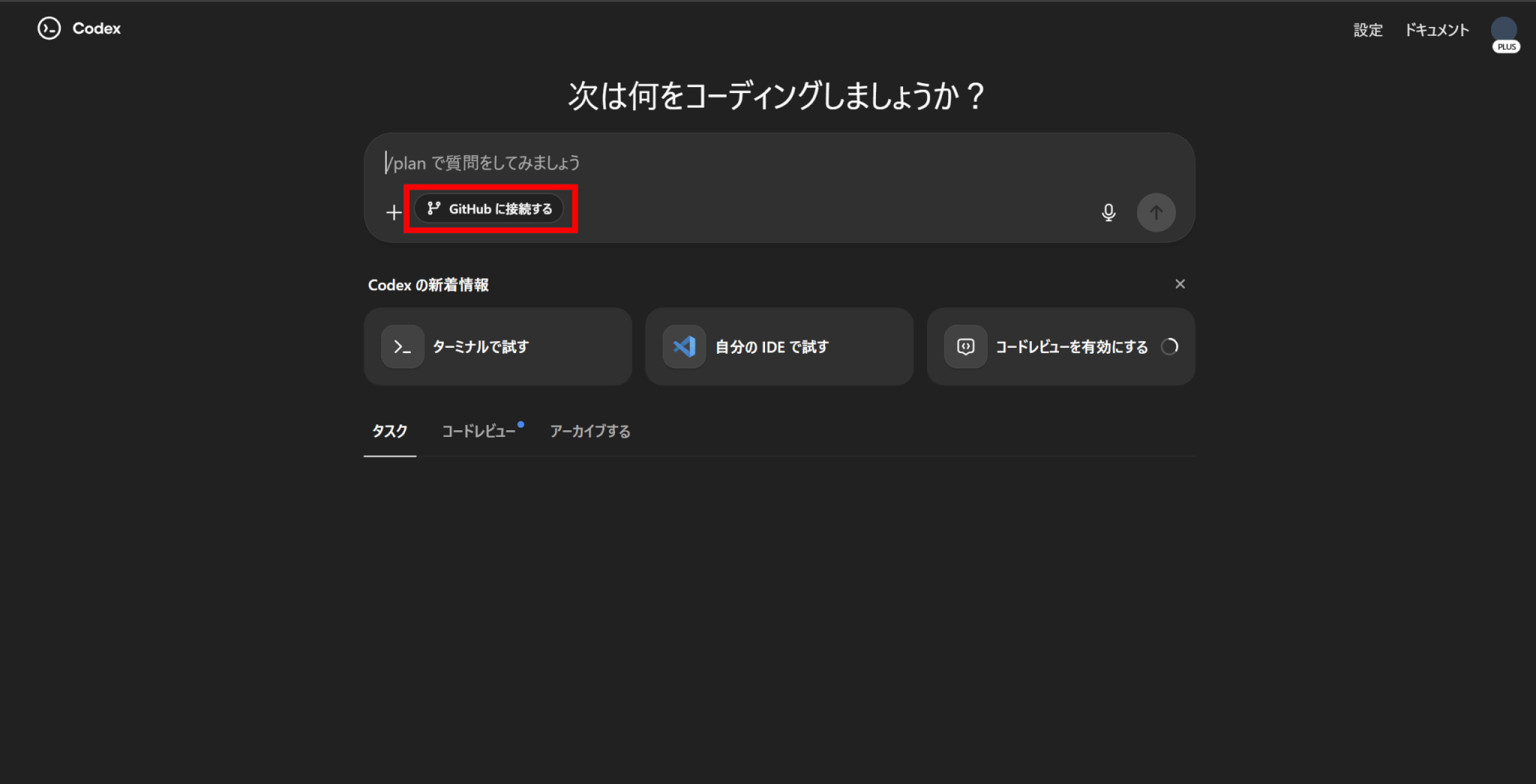

Codex Webを使用すると、クラウド上のCodexでタスクを実行することができます。

Codex Webの使い方は以下の通りです。

次に、CodexをGitHubと連携します。「GitHubに接続する」をクリックし、アカウントにログインすることで、GitHubアカウント内のリポジトリにCodexがアクセスできるようになります。

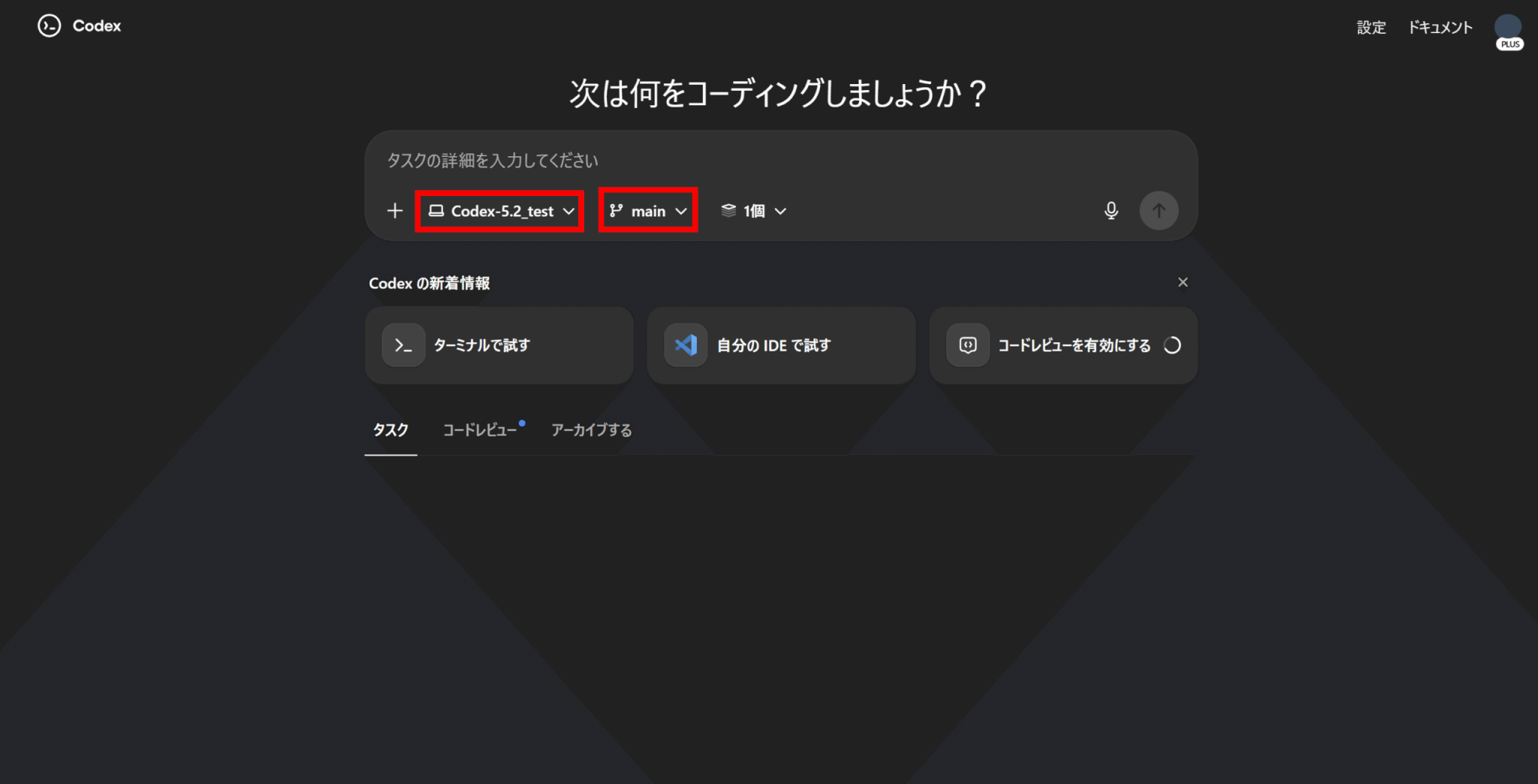

GitHubに接続できたら、メッセージウィンドウ内のプルダウンからCodexを使いたいリポジトリとブランチを選択します。

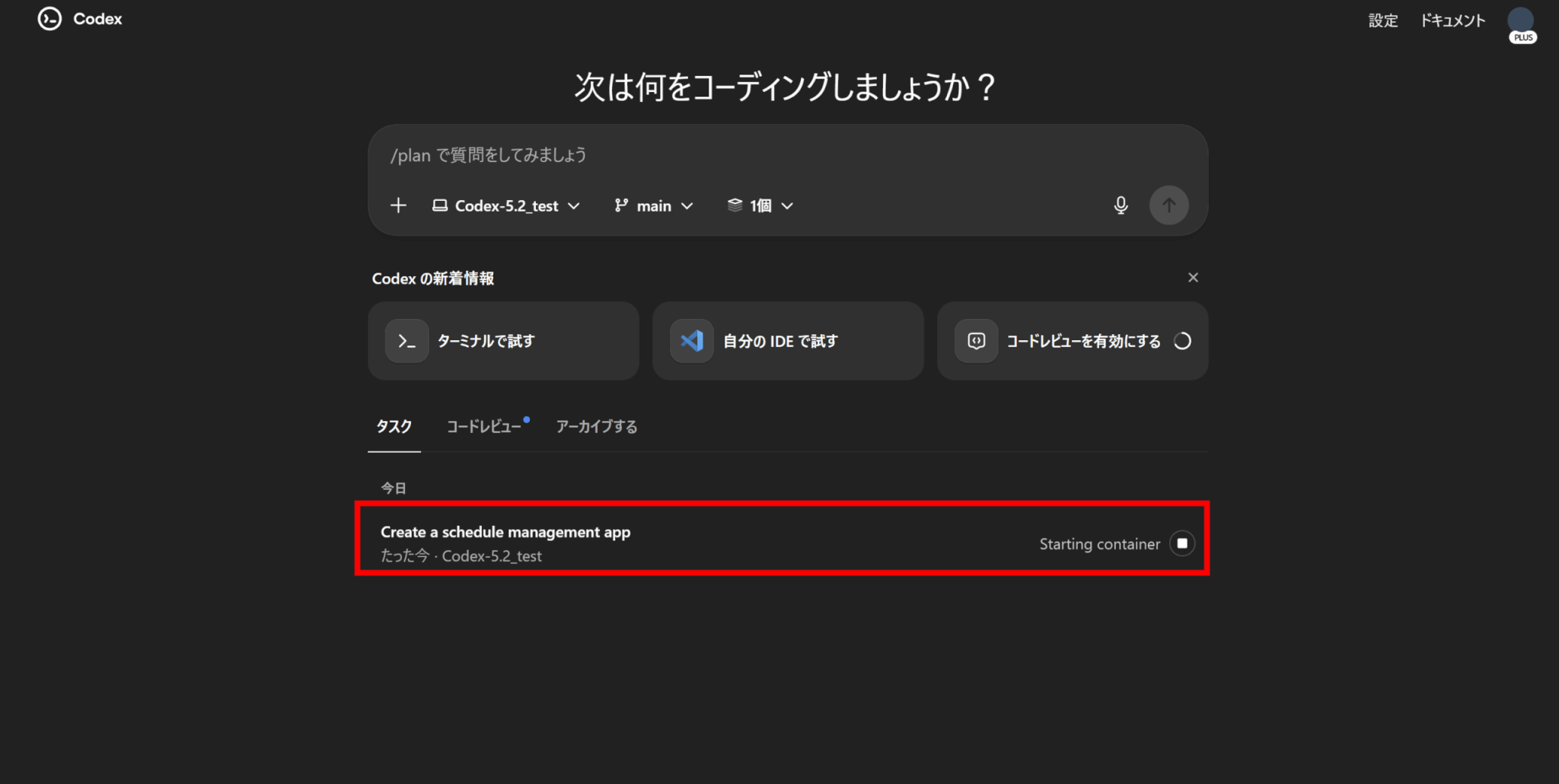

Codexに依頼したいタスクをプロンプトとして入力し、送信します。Codexでは複数のタスクを並列実行することが可能です。

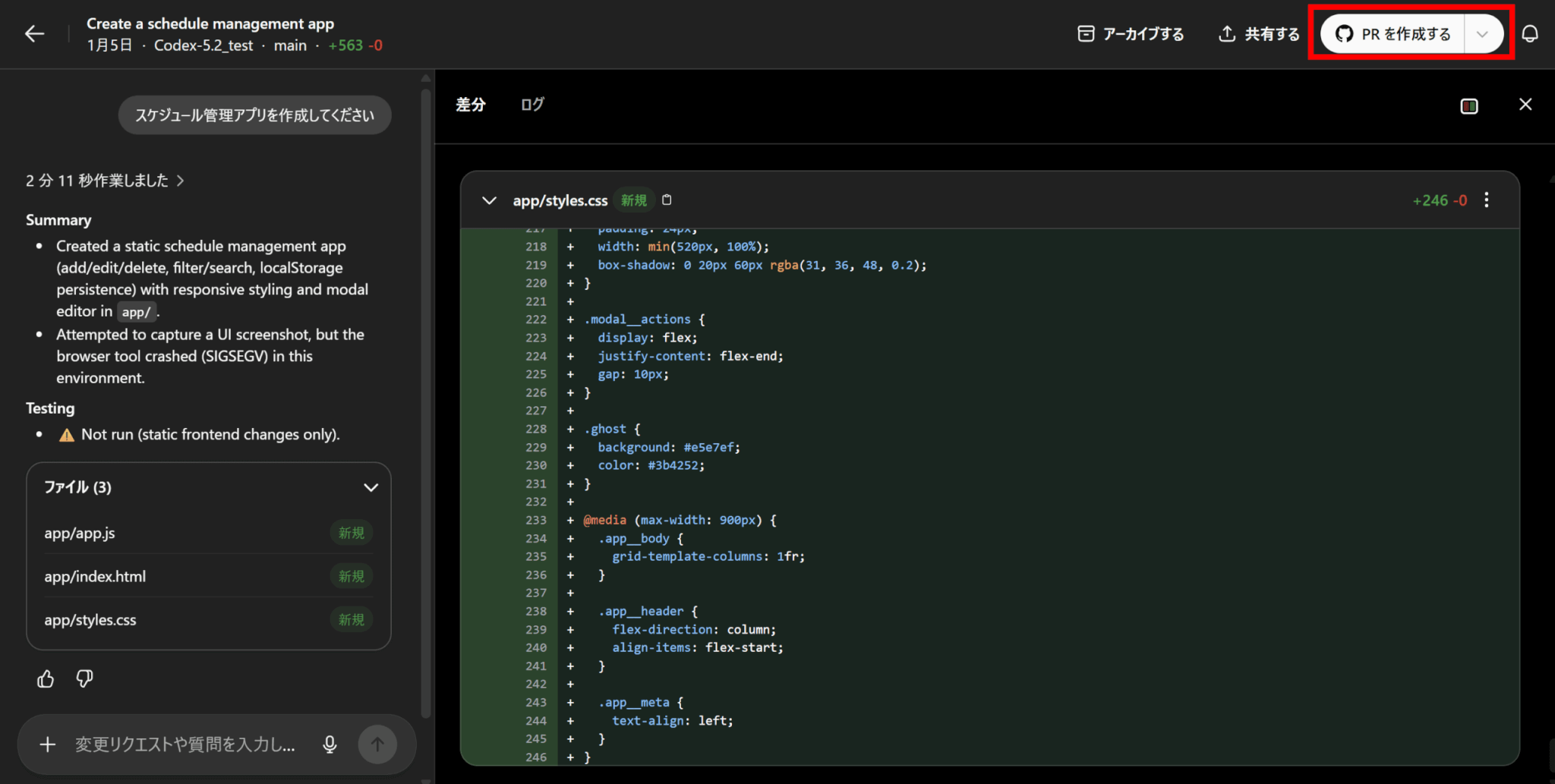

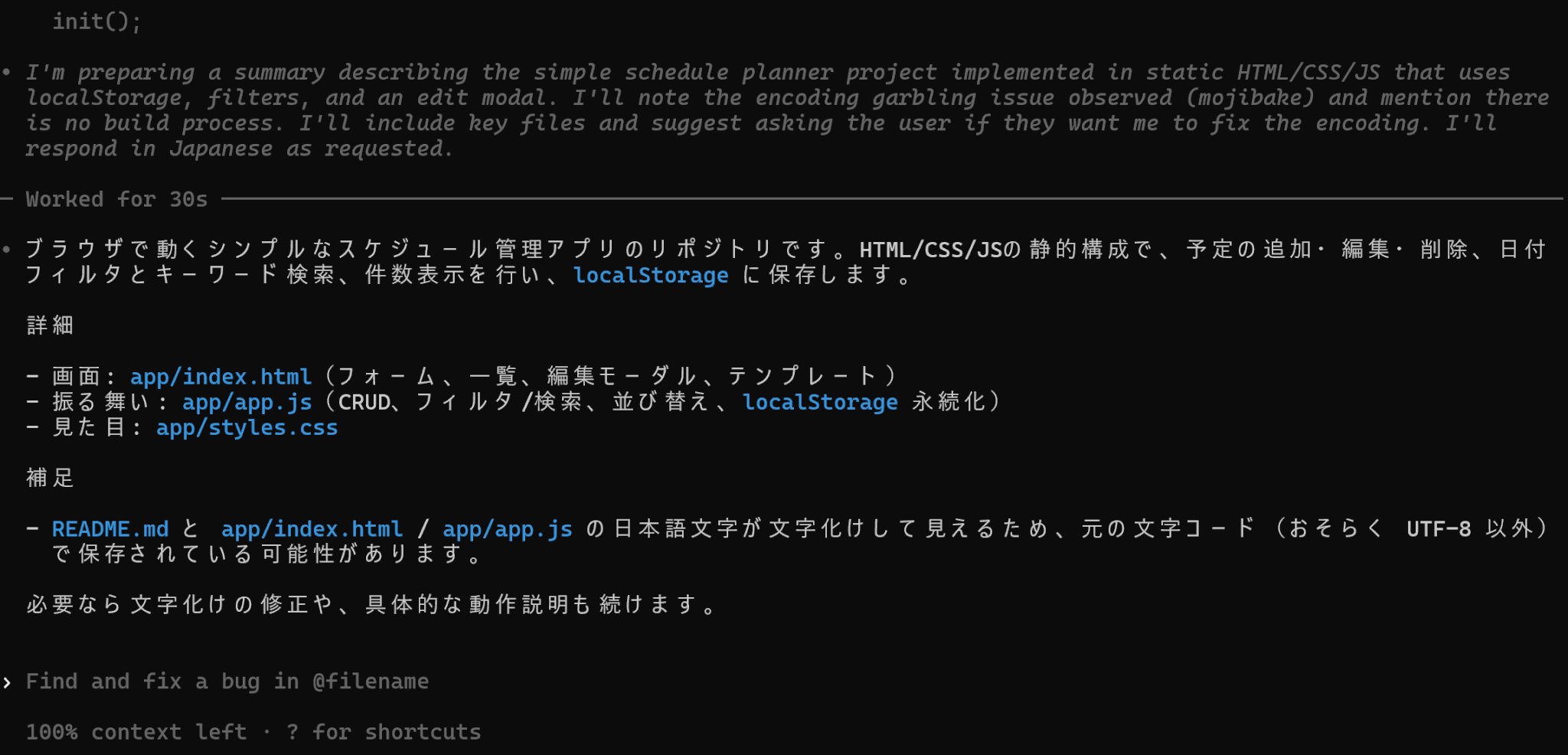

タスクを実行し始めると、画面下のタスク一覧に表示されます。今回はスケジュール管理アプリを作成するように依頼しました。

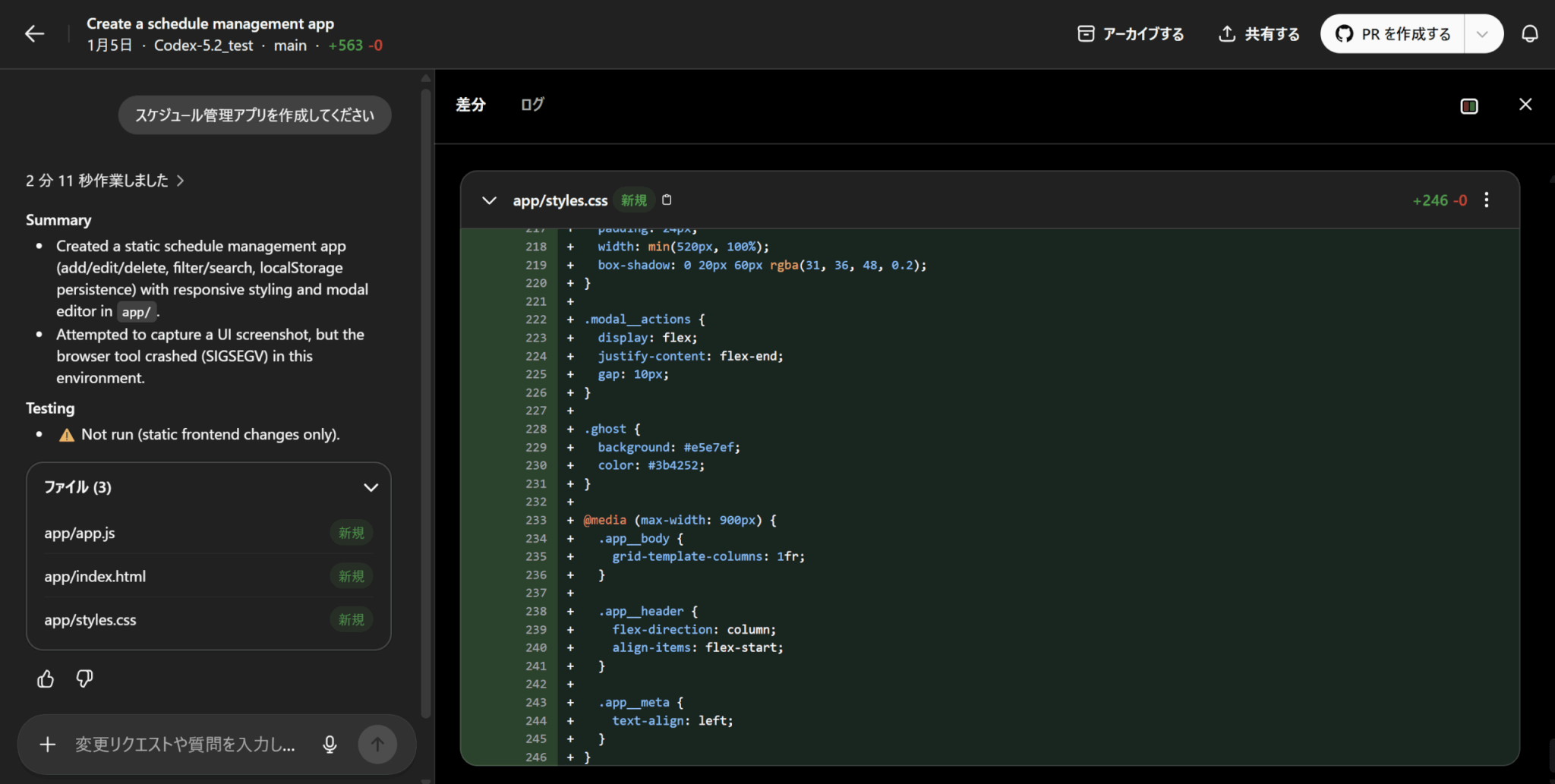

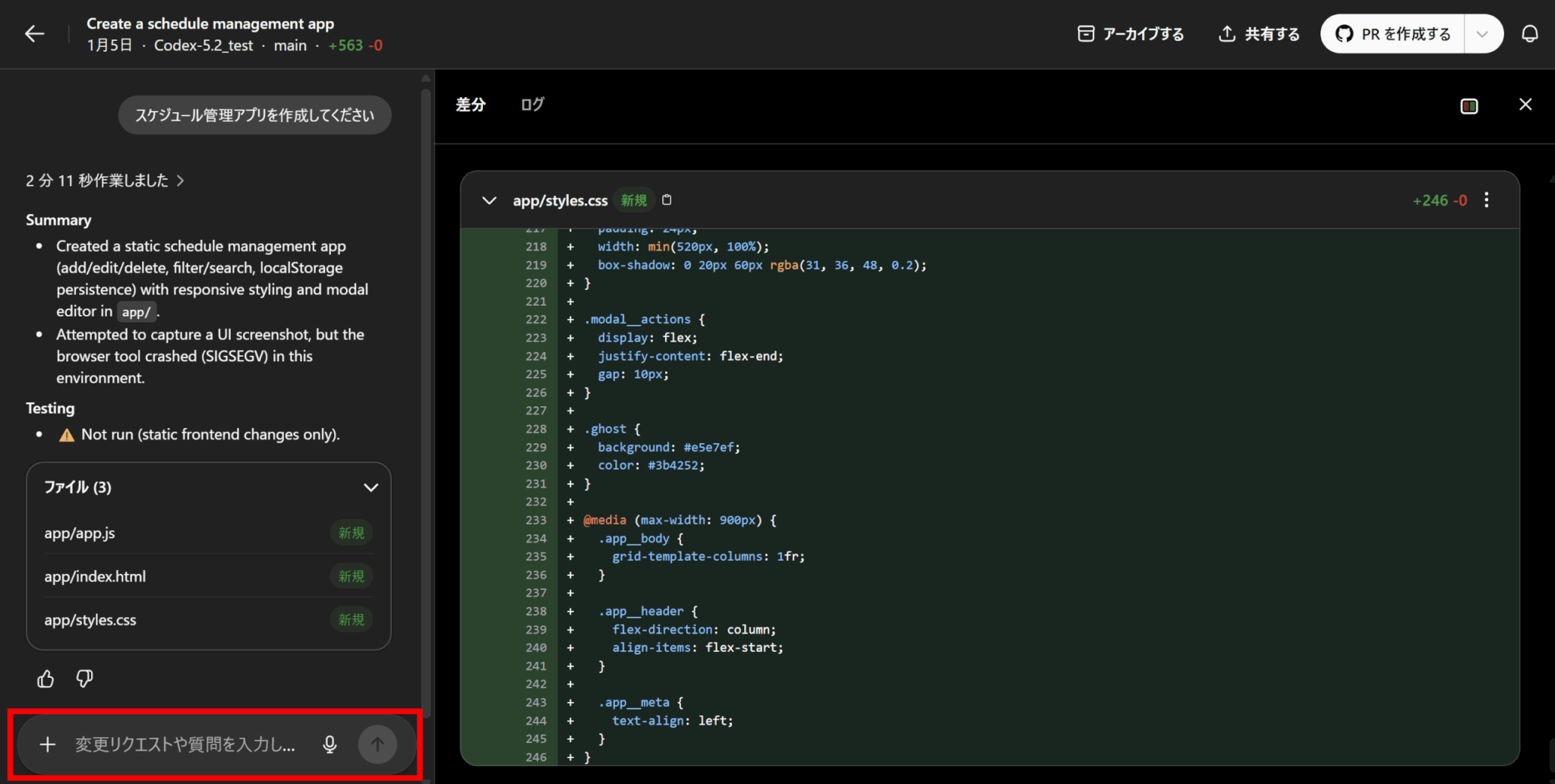

タスクをクリックすると、そのタスクの実行履歴と結果を見ることができます。

タスクの実行結果を確認しましょう。もし問題点があれば、メッセージウィンドウから変更リクエストを送ることもできます。また、出力内容に対する質問も可能です。

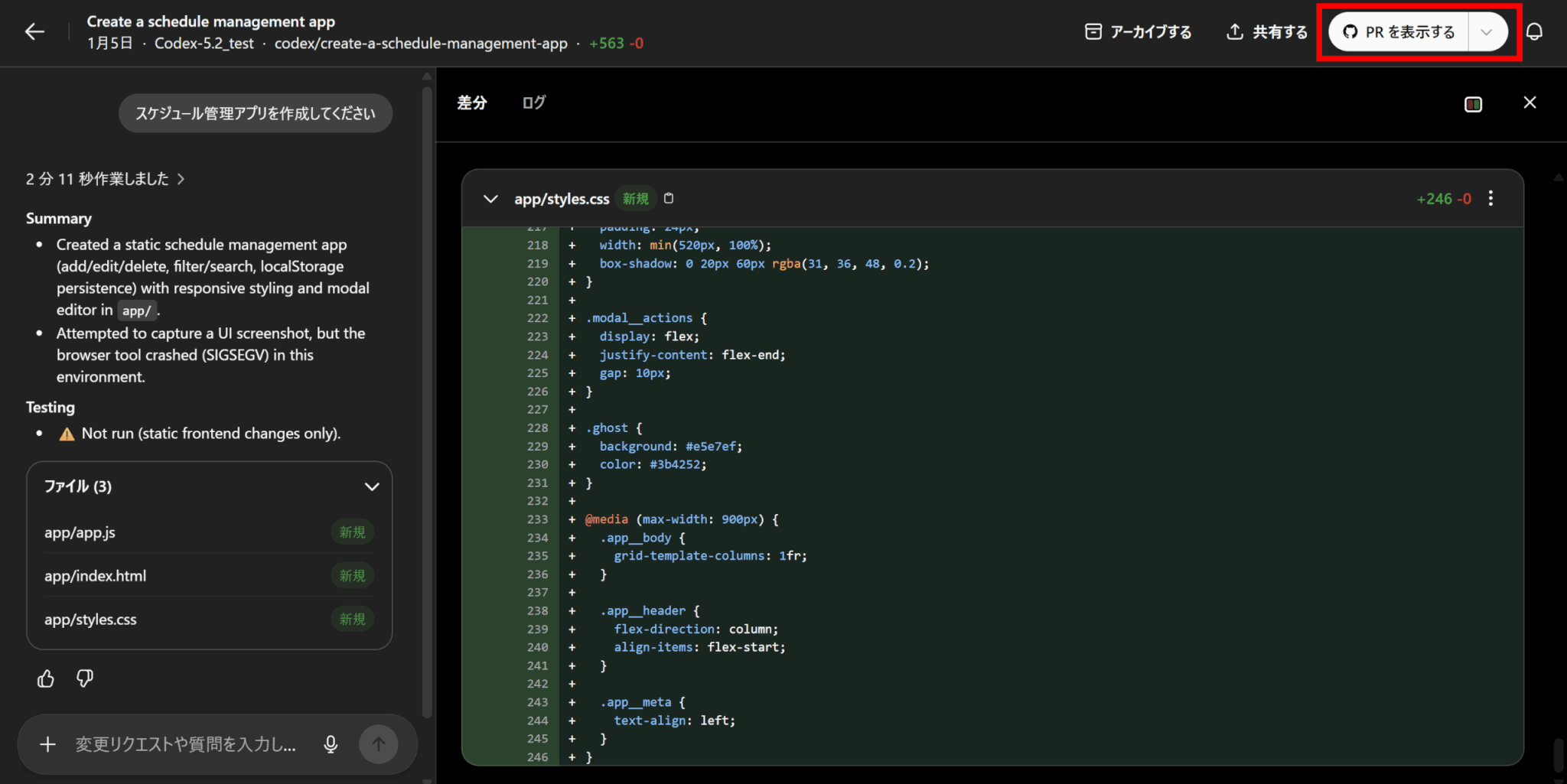

結果に問題がなければ画面右上の「PRを作成する」をクリックすることで、プルリクエストが自動で作成されます。

作成後は「PRを表示する」に表記が変わるので、クリックすることでGitHub上のプルリクエストに移動します。

あとは通常の流れと同様に、コードレビューをしてマージしましょう。

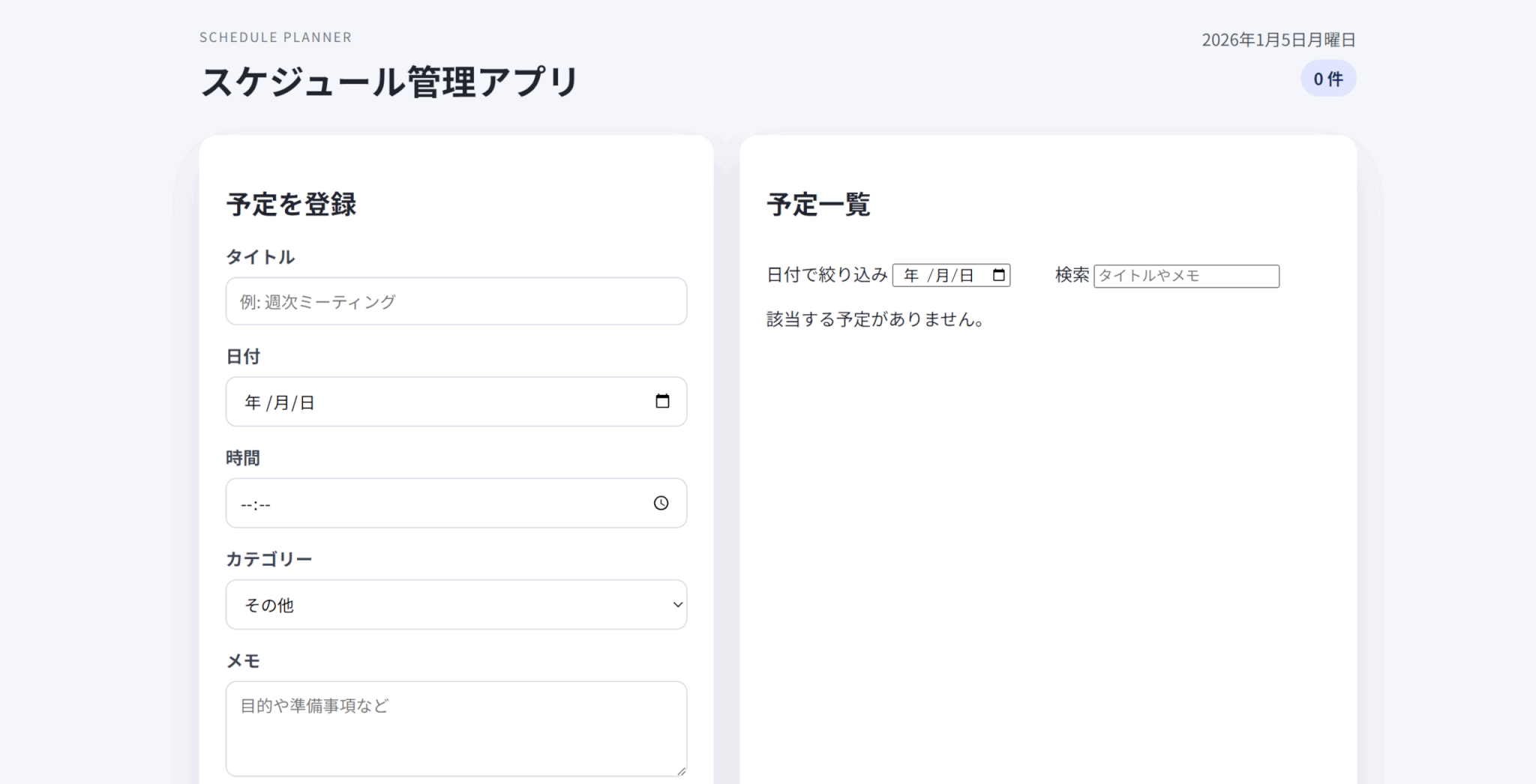

なお、今回作成されたスケジュール管理アプリがこちらです。

Codex CLIでの使い方

Codexはローカルのターミナル上でもCodex CLIとして利用可能です。

Codex CLIの使い方は以下の通りです。

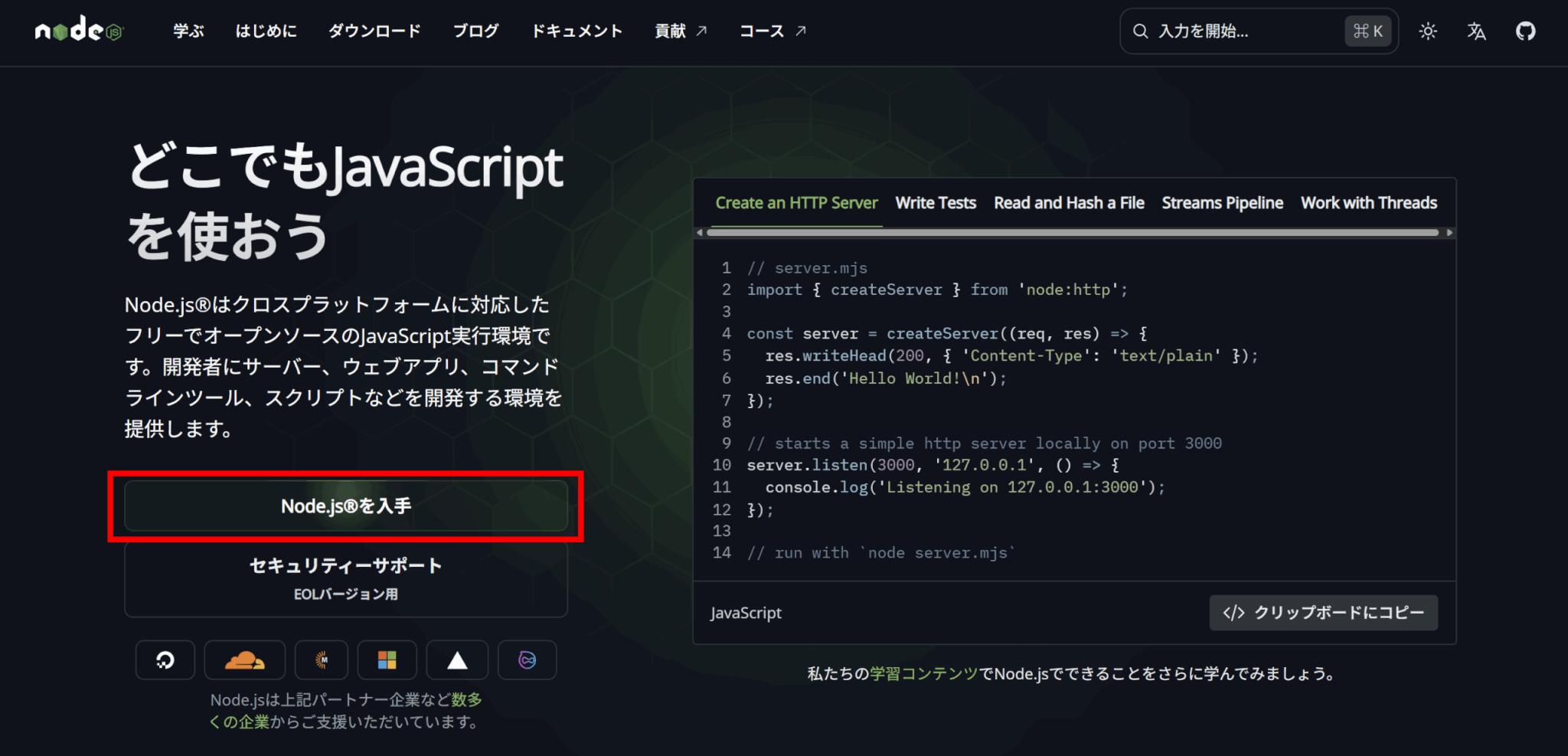

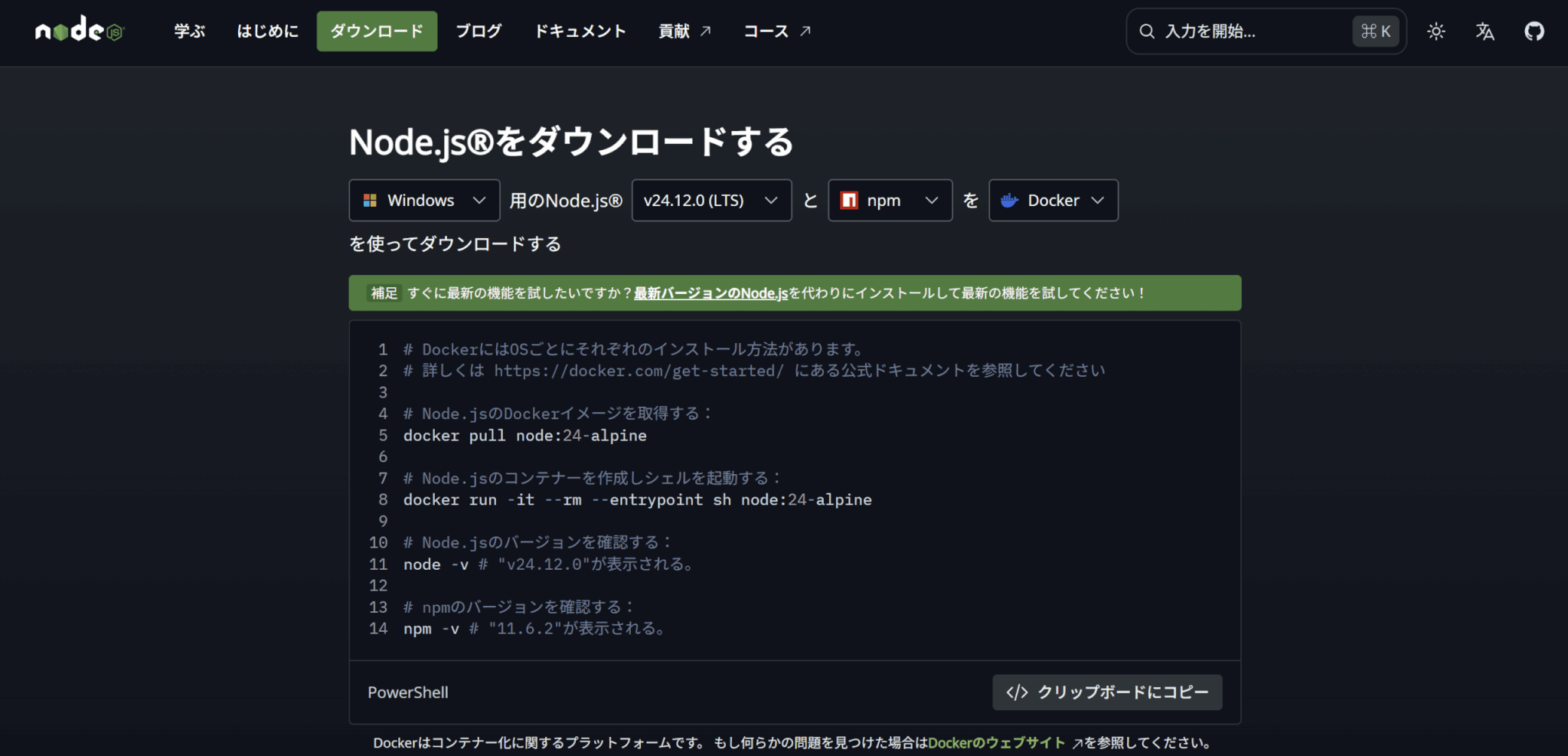

Codex CLIのインストールに必要なnpmを使えるようにするため、Node.jsをインストールします。

「Node.jsを入手」をクリックし、使用環境に合ったインストーラーをダウンロードしましょう。

インストーラーを起動し、指示に従ってNode.jsをインストールしましょう。

以下のコマンドを実行し、バージョン情報が出力されれば大丈夫です。

npm -v以下のコマンドをターミナルで実行してCodex CLIをインストールしましょう。

npm i -g @openai/codexターミナル上で対象のリポジトリに移動し、以下のコマンドを実行することでCodexを実行できます。

codex初めて実行したときはサインインが求められるので、ChatGPTのアカウントでサインインするか、OpenAIのAPIキーを登録しましょう。

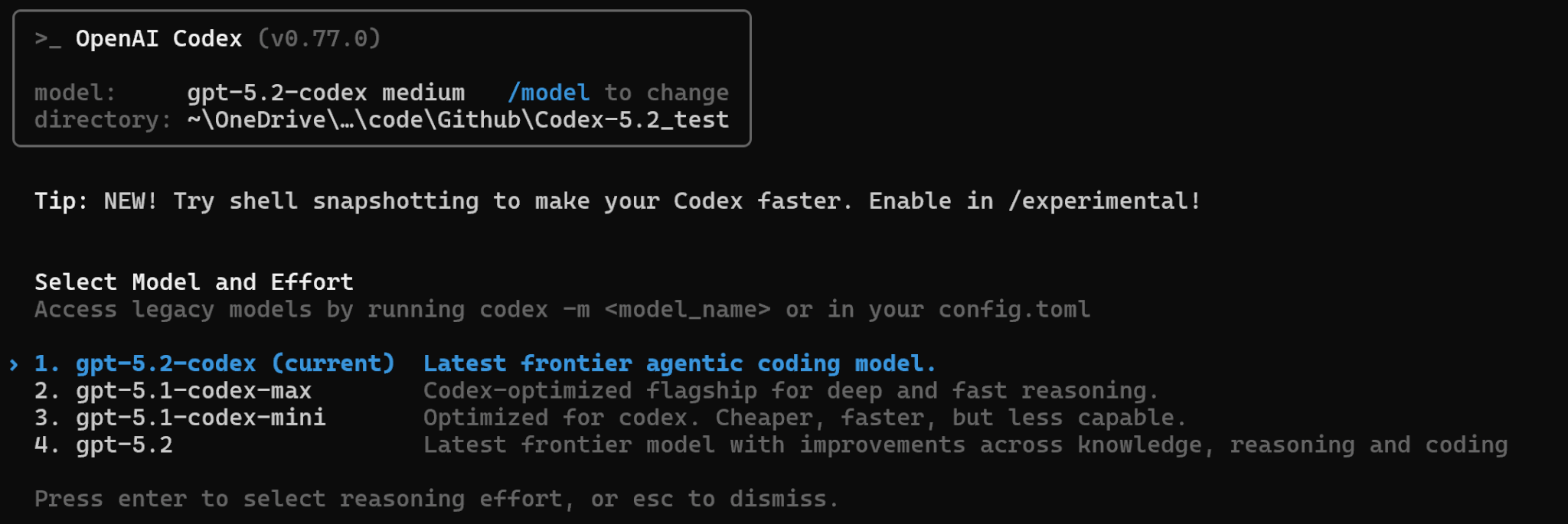

Codexを実行後、/modelと入力することでモデルを選択できます。

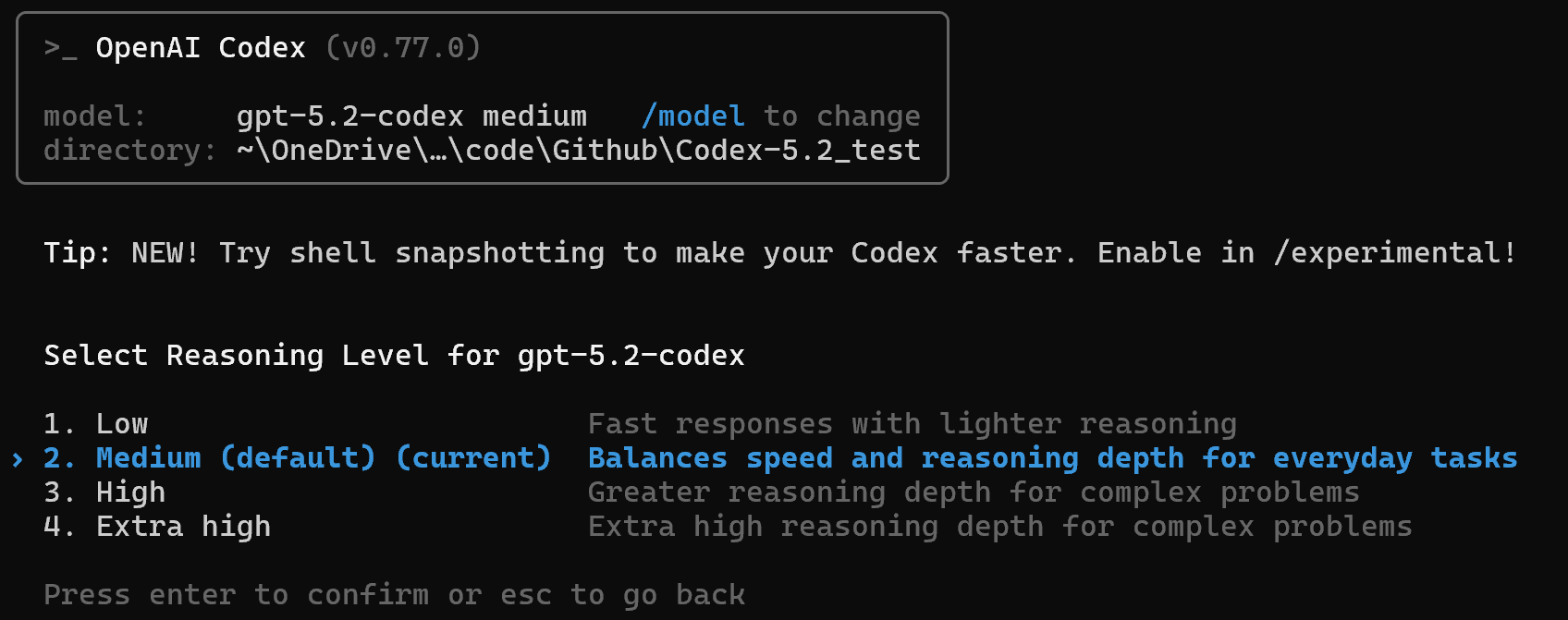

ここでGPT-5.2-Codexを選び、リーズニングのレベルを設定します。

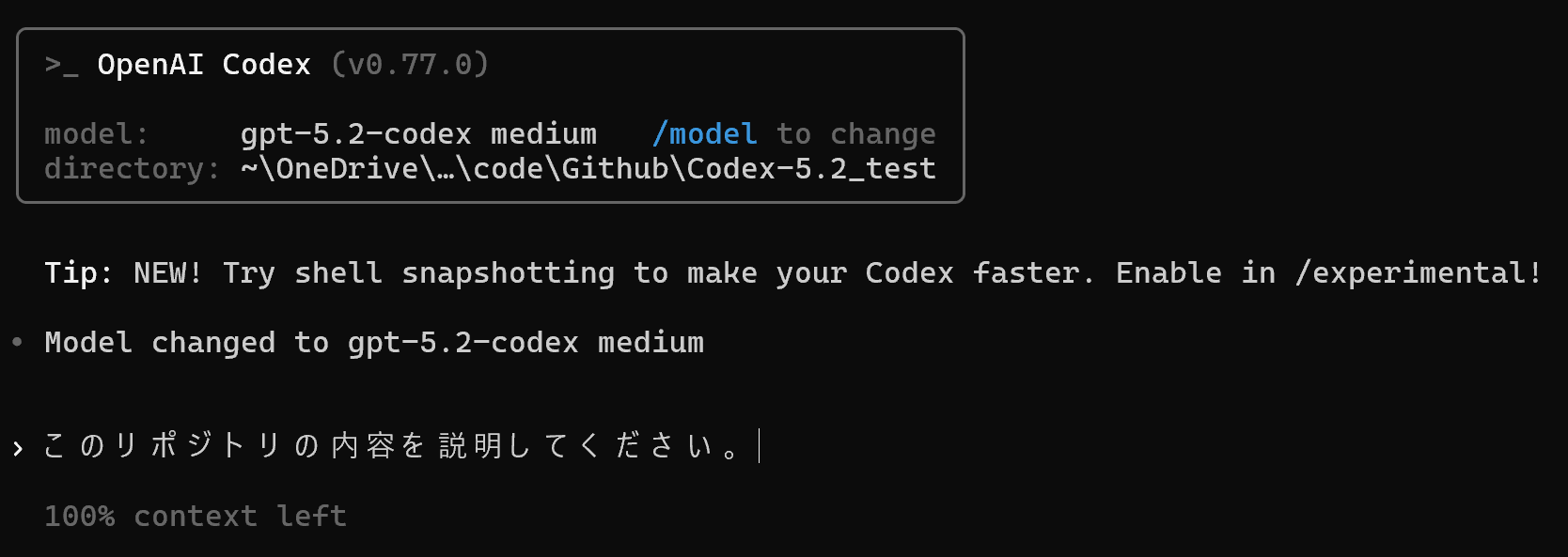

ターミナル上でプロンプトを入力して送信することで、対象リポジトリに関する質問やタスクを依頼することができます。

リポジトリの内容の解説や、バグやリファクタリングに役立ちます。

Codex CLIは定期的に新しいバージョンがリリースされるため、以下のコマンドを実行してアップデートするようにしましょう。

npm i -g @openai/codex@latest

IDEでの使い方

Codexは、VS CodeやCursor、Windsurfなど、IDEの拡張機能として使用することもできます。

ここでは、VS Codeでの使用方法を解説します。

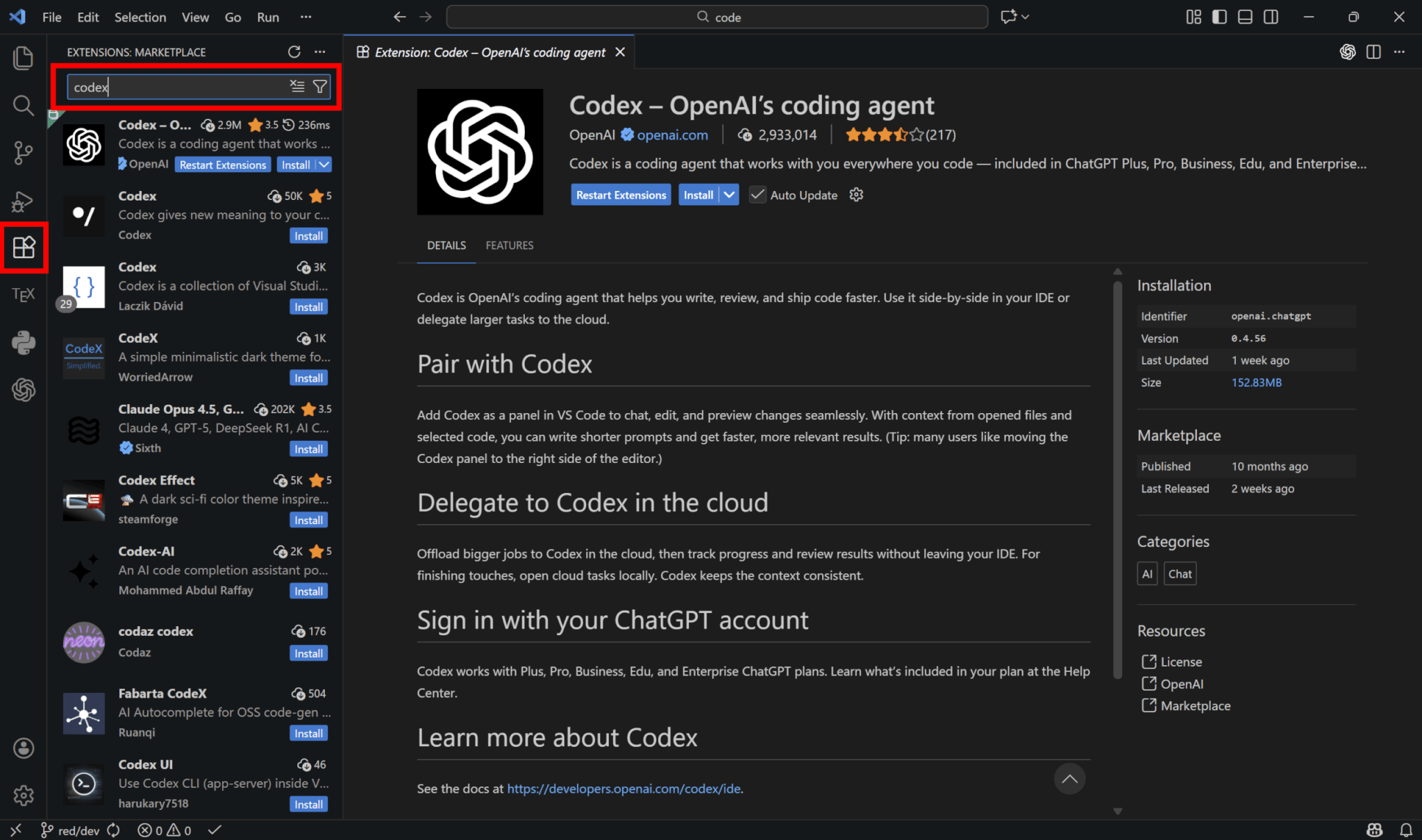

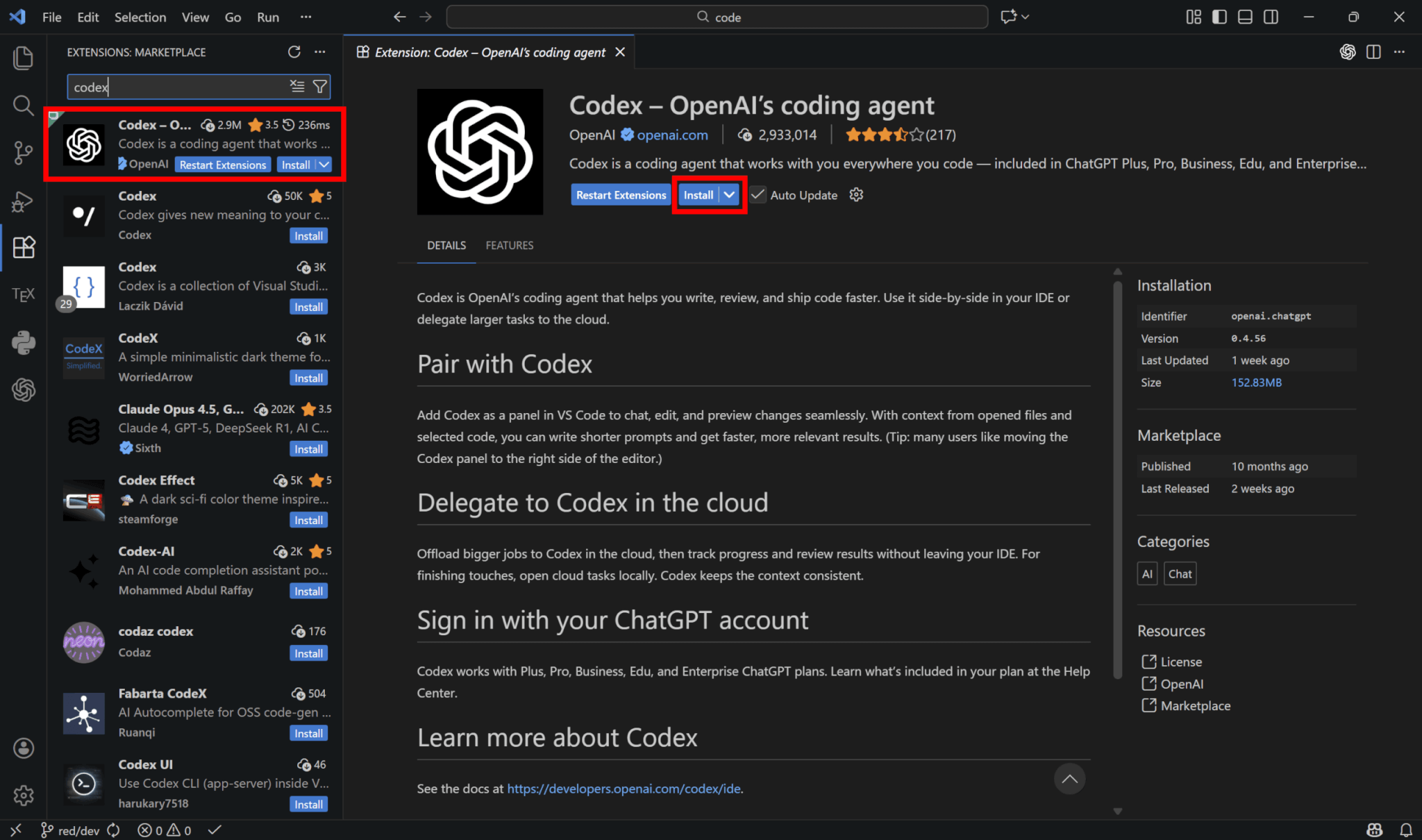

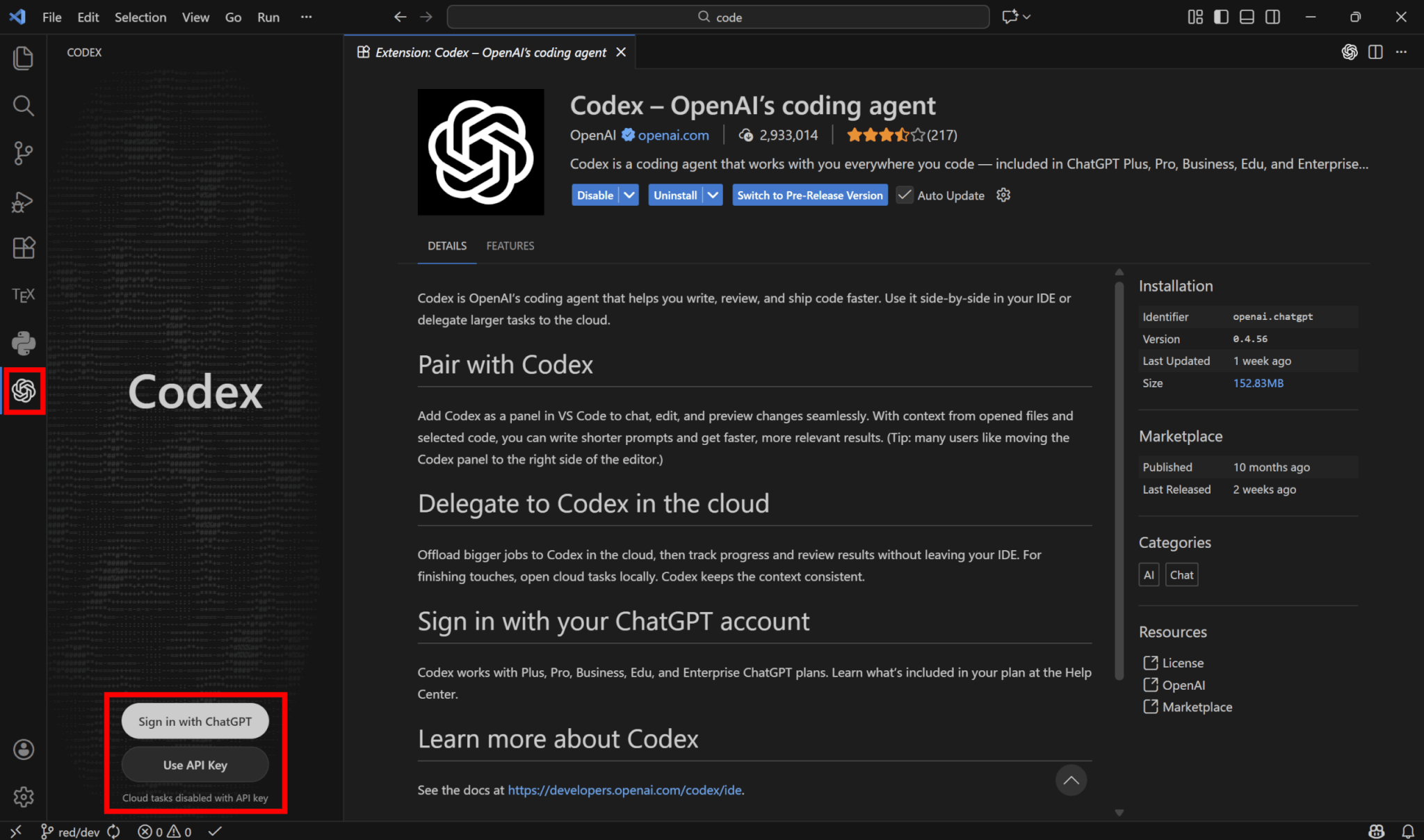

拡張機能のタブに移動し、「codex」と検索します。

公式のCodexを選択し、「Install」をクリックします。

拡張機能をインストール後、サイドバーにあるCodexのタブを選択し、ChatGPTのアカウントでサインインするか、APIキーを使って認証しましょう。

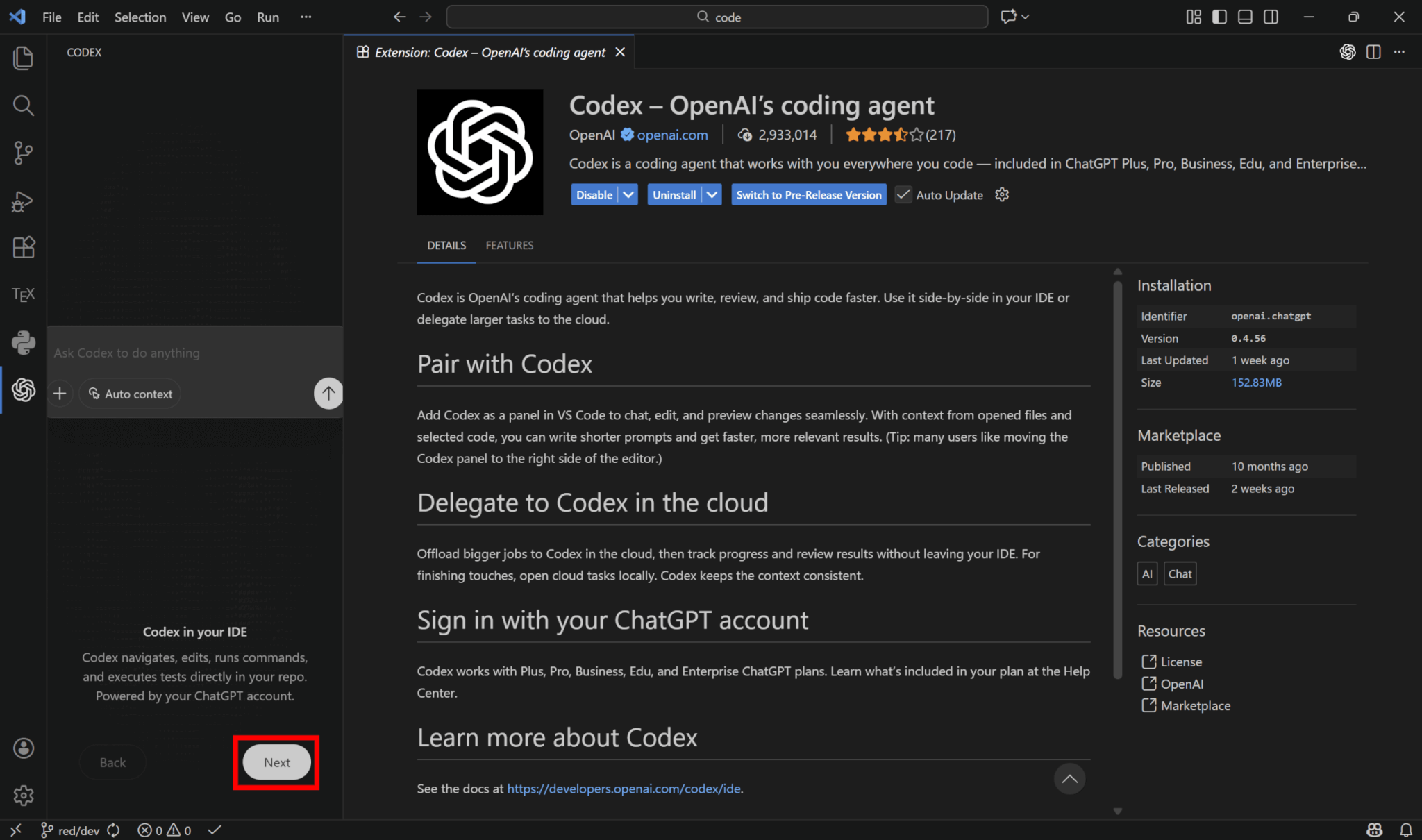

認証後は説明が表示されるので、「Next」をクリックして進めましょう。

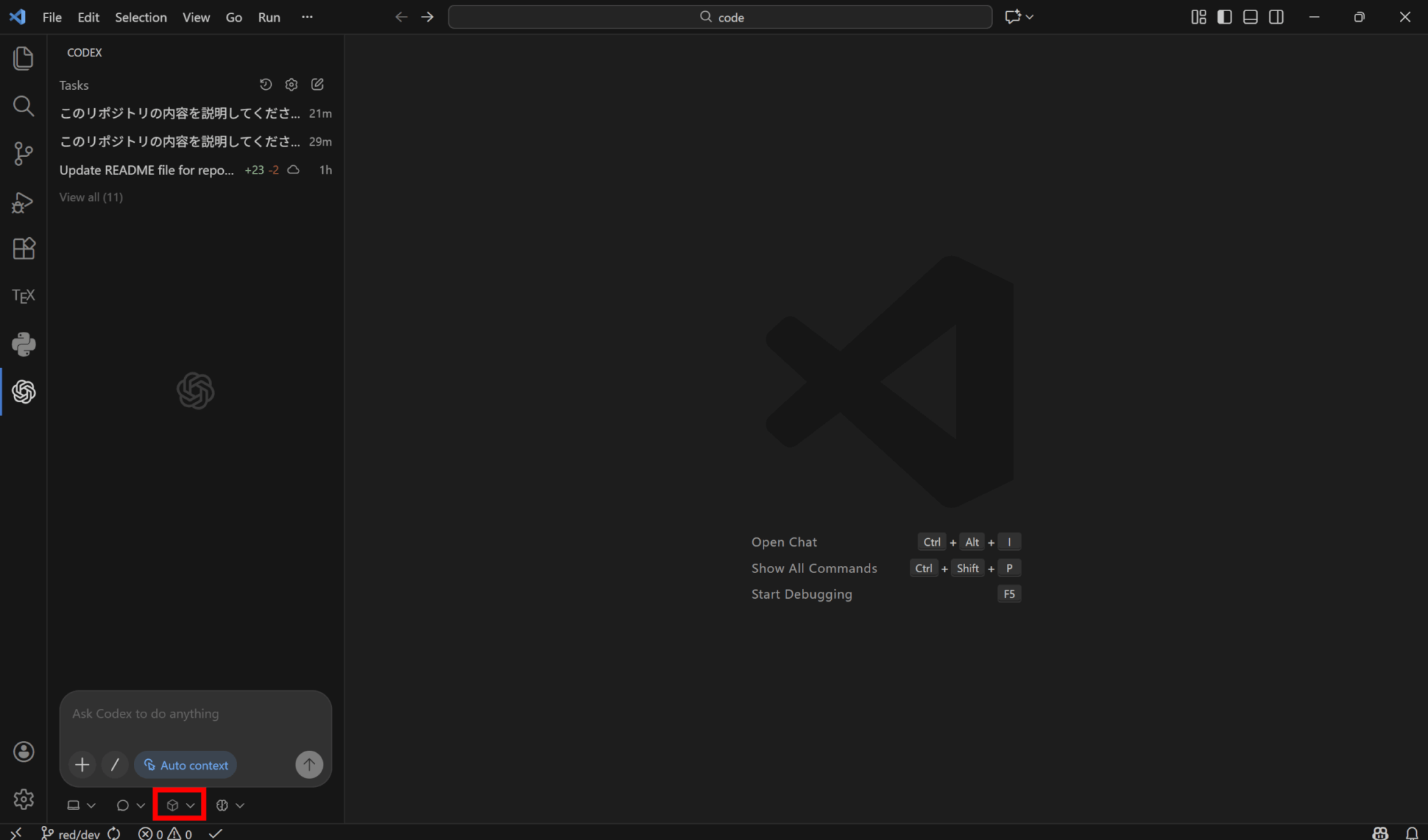

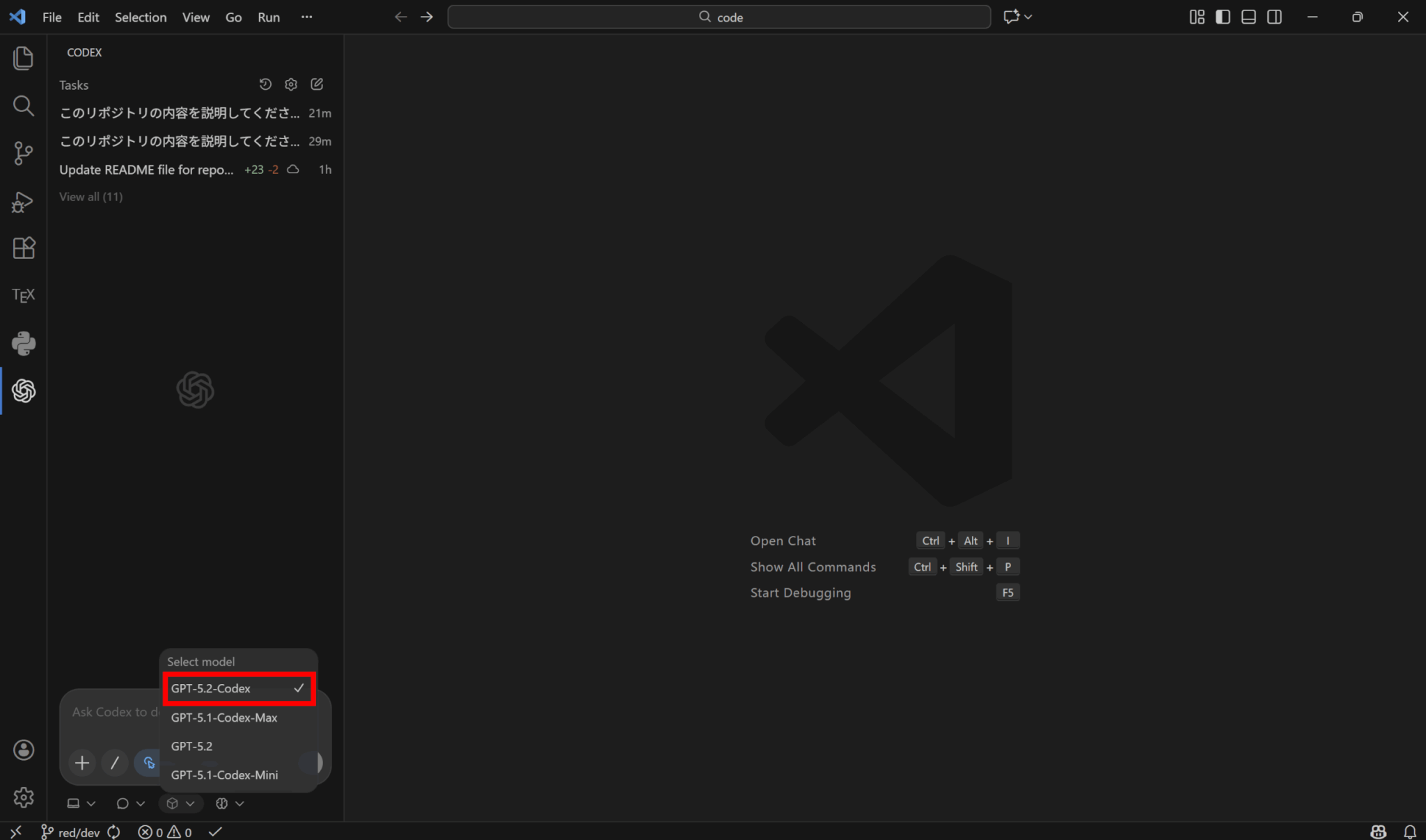

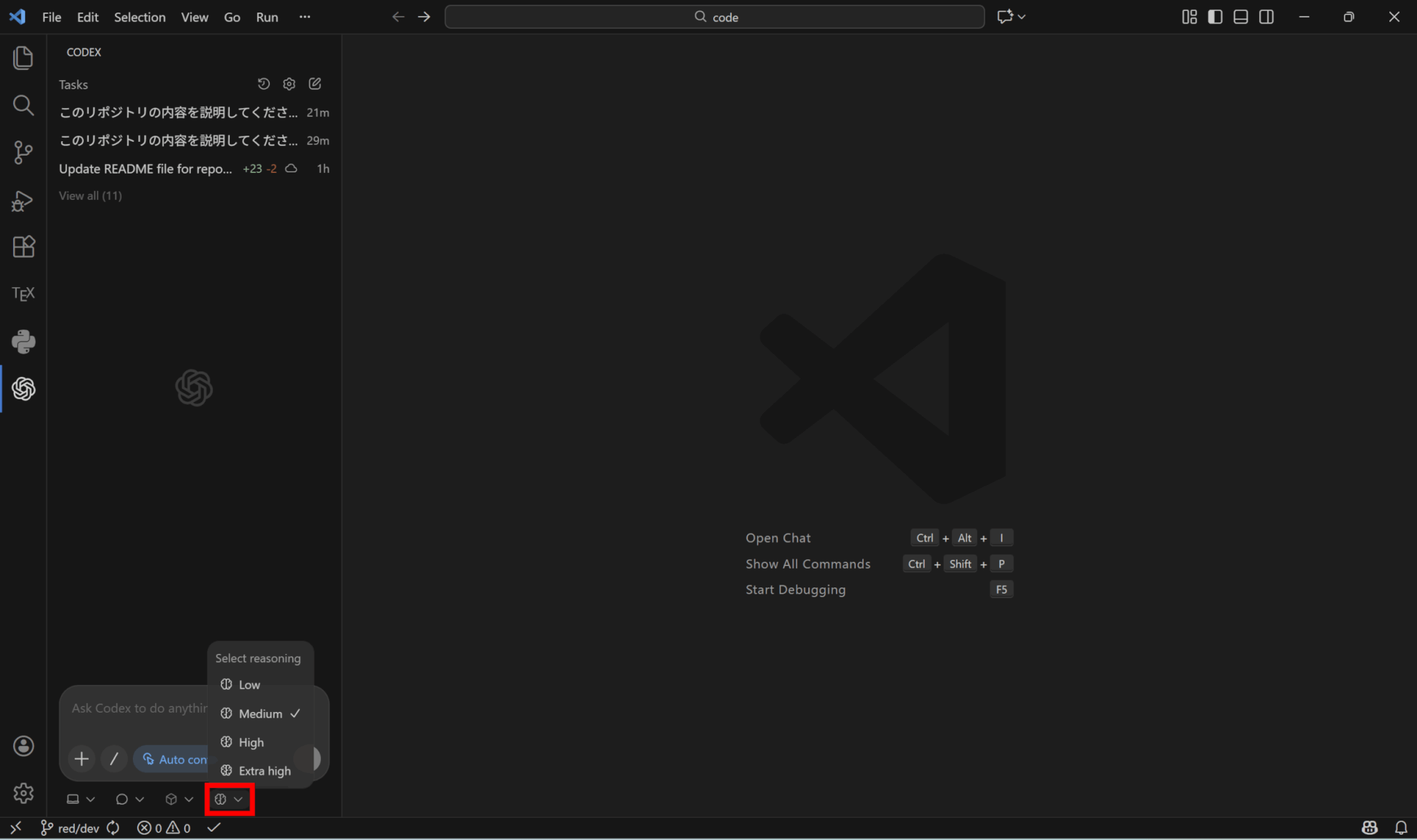

メッセージウィンドウの下にあるプルダウンから、モデルを選択できます。

ここでGPT-5.2-Codexを選択しましょう。

また、リーズニングレベルも選択可能です。

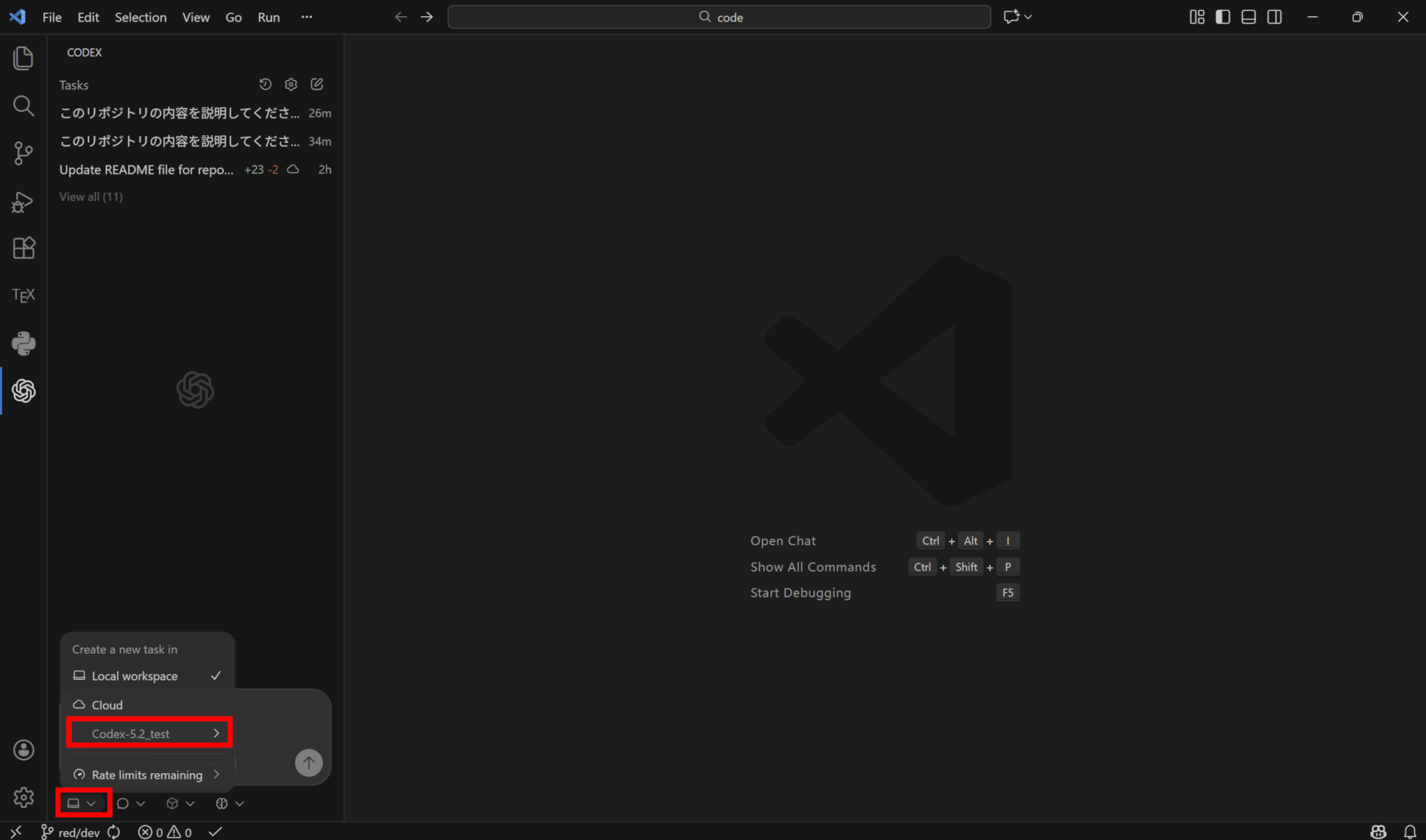

対象となるリポジトリをプルダウンから選びましょう。

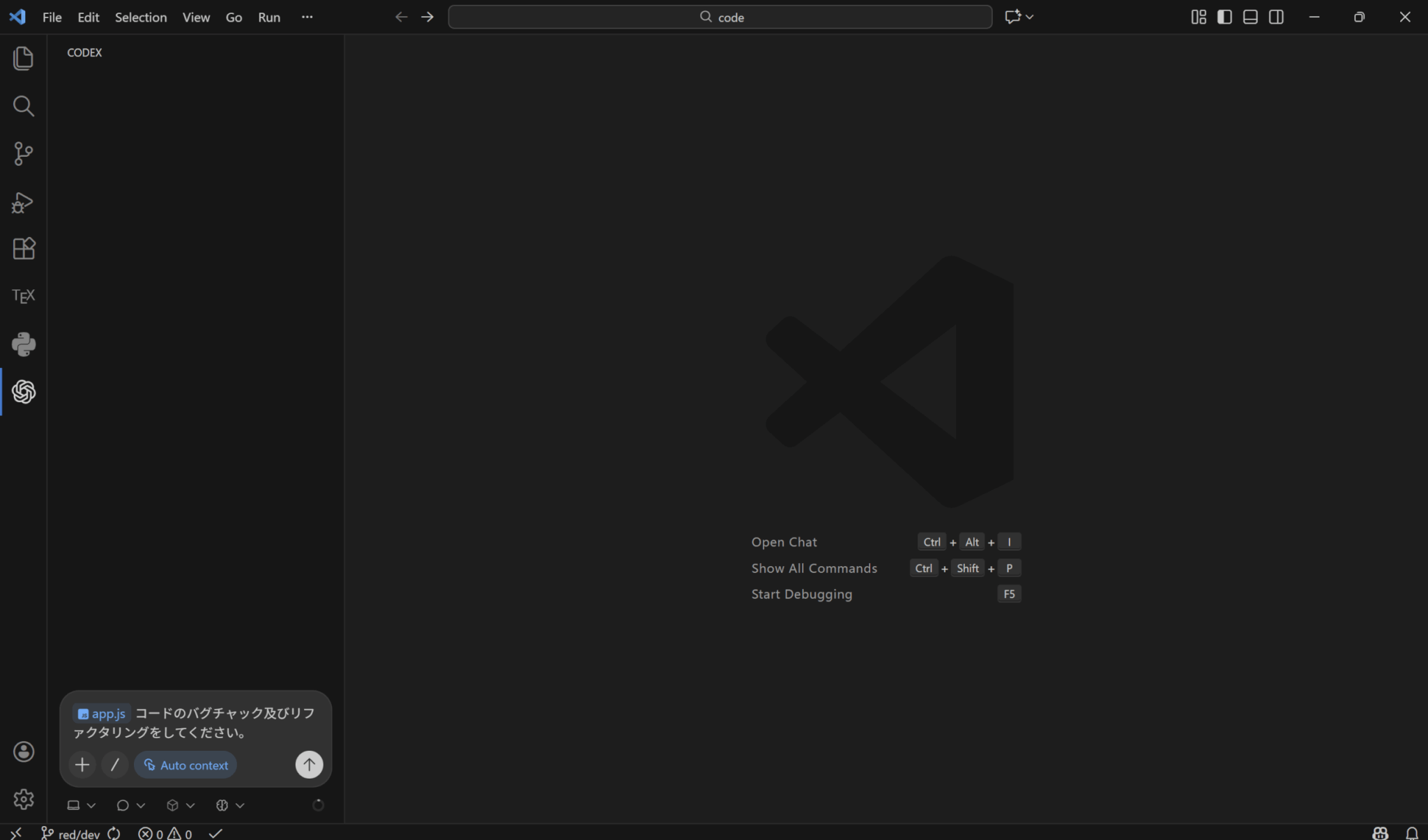

他の方法と同様にメッセージウィンドウにプロンプトを入力して送信します。なお、@を付けてファイル名を指定することで、そのファイルに対してタスクを実行できます。

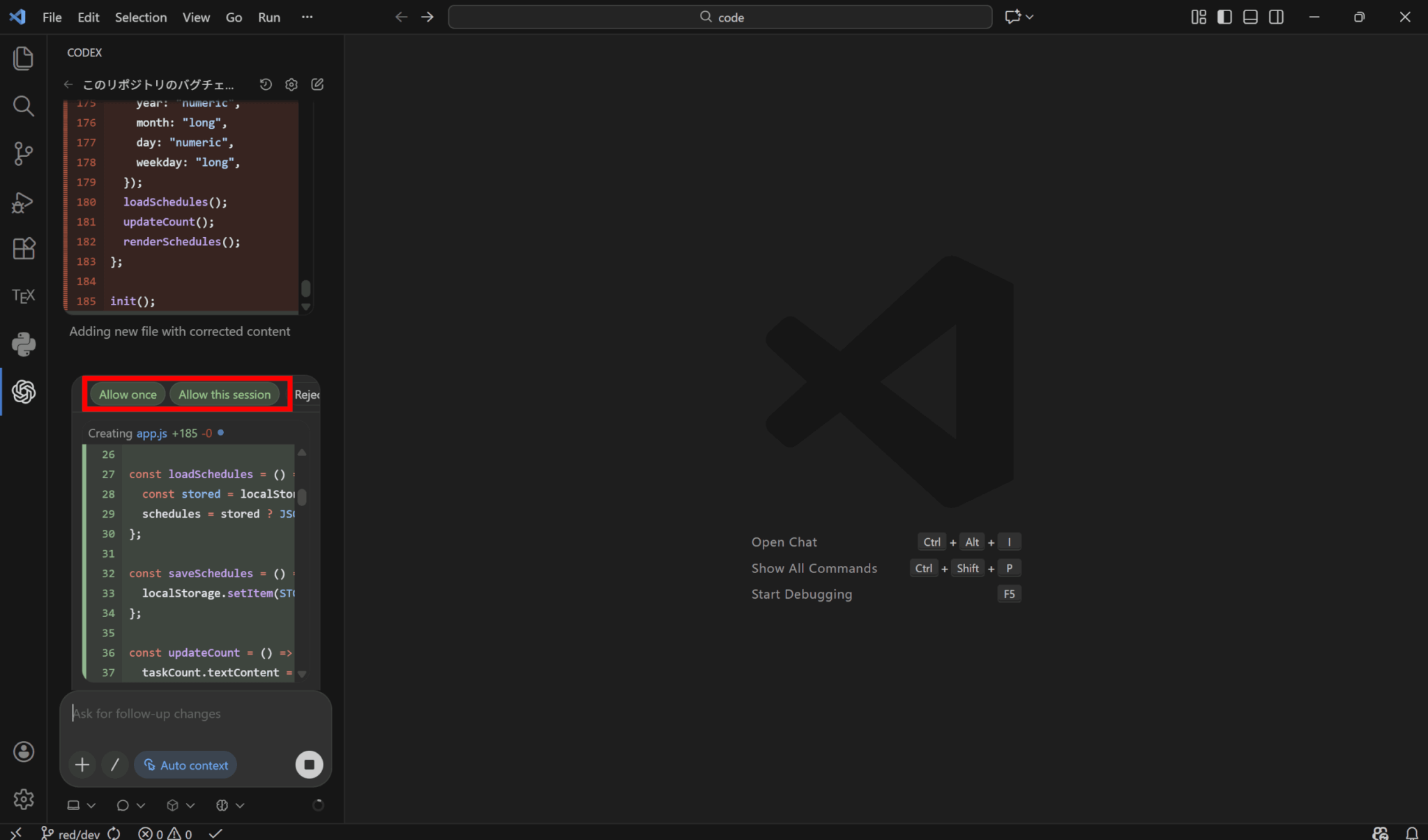

実行途中で承認を求められる場合があるため、「Allow once」か「Allow this session」をクリックして実行を続けましょう。

使う際のセキュリティ上の注意点

Codexを組織で導入する際は、まず認証の強化が不可欠です。SSO運用の場合はIdP側で全ユーザーにMFA(多要素認証)を強制し、メール・パスワード運用の場合はCodex Cloudの利用開始前にアカウント側でのMFA設定を必須化します。

次に権限管理についてですが、管理者と開発者、環境作成と実行、ネットワーク許可と通常運用といった役割を明確に分離します。その上で、RBAC(ロールベースアクセス制御)やグループ単位の割り当てを活用し、最小権限の原則に基づいた運用を徹底します。

エージェントの実行権限は、サンドボックスと承認ポリシーを用いて段階的に付与します。また、組織全体のデフォルト設定は管理者が安全な状態に固定し、設定の意図しない変更を抑制します。

ログと監査の観点では、まず開発者が日々のレビューを行えるよう、実行内容のトランスクリプトや差分を記録します。これらは通常のGitワークフロー内で確認やロールバックが可能な状態にしておくことが重要です。

クラウドでの長期タスクやインターネットアクセスを許可する場合は、進捗や作業ログの確認を徹底します。同時に、許可するドメインやHTTPメソッドを必要最小限に絞り込むことで、プロンプトインジェクションや情報漏洩のリスクを低減させます。

さらに厳密な監査が求められる場合、EnterpriseプランではCompliance APIを通じた監査ログの取得と利用監視を行います。ローカル実行においては、OpenTelemetryを任意で有効化して承認判断やツール実行結果などの構造化ログを収集しますが、その際、プロンプト本文は原則としてマスクした状態で扱うようにします。

GPT-5.2-Codexの使用にかかる料金

最後に、GPT-5.2-Codexを使う際にかかる料金について解説します。

ChatGPT料金プランの全体像

GPT-5.2-Codexは、ChatGPTの有料プランで使用可能です。Codexが利用できるそれぞれのプランと使用制限は以下の通りです。

| プラン | 月額料金 | ローカルメッセージ/5時間 | クラウドタスク/5時間 | コードレビュー/1週間 |

|---|---|---|---|---|

| Plus | $20 | 45~225 | 10~60 | 10~25 |

| Pro | $200 | 300~1500 | 50~400 | 100~250 |

| Business | $30/ユーザー | 45~225 | 10~60 | 10~25 |

| Enterprise/Edu | 要問い合わせ | クレジットによる | クレジットによる | クレジットによる |

利用上限はプランごとに設定され、ローカルのメッセージ数とクラウドタスク数は5時間あたりの制限を共有しており、コードレビューは1週間当たりの制限です。

また、EnterpriseとEduは固定上限ではなく、クレジットに応じて利用量が調整されます。

もし上限に到達した場合は、プランを上げるか、追加クレジットを購入して延長することが可能です。

個人利用であればまずPlusで試し、使用制限に引っかかるような場合はProへのアップグレードを検討するのがおすすめです。

料金を左右する要素

料金を決定づける最大の要因は、各プランに設定されている「ローカルメッセージ数」「クラウドタスク数」「GitHub コードレビュー回数」の上限です。

ただし、送信できるメッセージ数は一律ではなく、コーディングタスクの規模や複雑さ、ローカル実行かクラウド実行かによって異なります。

そのため、上限に近づいた場合は、ローカル作業をより軽量なGPT-5.1-Codex-Miniに切り替えることで最大4倍の使用が可能となります。

なお、追加クレジットの購入方法はプランによって異なります。PlusやProプランでは個人単位での購入、Business・Enterprise・Eduプランではワークスペース単位でのクレジット追加という仕組みになっています。

API利用時の料金

2026年1月現在、まだGPT-5.2-CodexはAPIでの利用ができず、準備が進められている段階です。

参考として、GPT-5.2のAPI料金は以下のようになっています。

| モデル | 入力 | キャッシュされた入力 | 出力 |

|---|---|---|---|

| gpt-5.2 | $1.75 | $0.175 | $14.00 |

| gpt-5.2-chat-latest | $1.75 | $0.175 | $14.00 |

GPT-5.1-CodexはGPT-5.1とAPI料金が同じだったため、GPT-5.2-CodexもGPT-5.2と同じ料金体系になる可能性が高いと考えられます。

料金の見積もり方

見積もりは、席数課金の固定費と、上限超過時に必要になるクレジット追加分の変動費を分けて考えるのがコツです。

まずチームの作業をローカル作業、クラウドタスク、コードレビューに分解し、1日あたりの回数見込みを置いて、平均クレジット目安に当てて超過可能性を見ます。

ピークがあるチームは、通常時はローカル中心で上限内に収め、繁忙期だけクレジット追加や上位プランを使う、という調整がしやすい設計です。

また、CIなどの非対話自動化は、CodexのAPI枠でトークン従量課金に寄せると、席数の増加と切り離してコスト管理しやすくなります。

まとめ

GPT-5.2-Codexは、最新のコーディング特化モデルであり、ローカルやクラウドで利用することができます。

これまでのモデルと比べてサイバー防御にも優れ、セキュリティを重視したい場合にも向いています。

ChatGPTの有料プランを契約していれば誰でも使用できるため、気になる方はぜひ試してみてください。