OpenAIは、最新の研究で「証明者-検証者ゲーム」という手法を使い、AIの文章力を向上させたと発表しました。

この手法によって、AIが生成する文章は、性能の低いAIや人間にとっても理解しやすくなりました。

OpenAIの研究チームは、AIが複雑な課題をこなすとき、ただ正解を導き出すだけでなく、その過程が明確で検証可能であることの重要性を強調しています。

従来の方法では、AIの性能が向上するにつれて、解答までのプロセスが複雑化し、人間がその正しさを判断するのが難しく、誤りが起きやすいという問題がありました。

この問題を解決するために、OpenAIは「証明者-検証者ゲーム」という新しい訓練方法を導入しました。

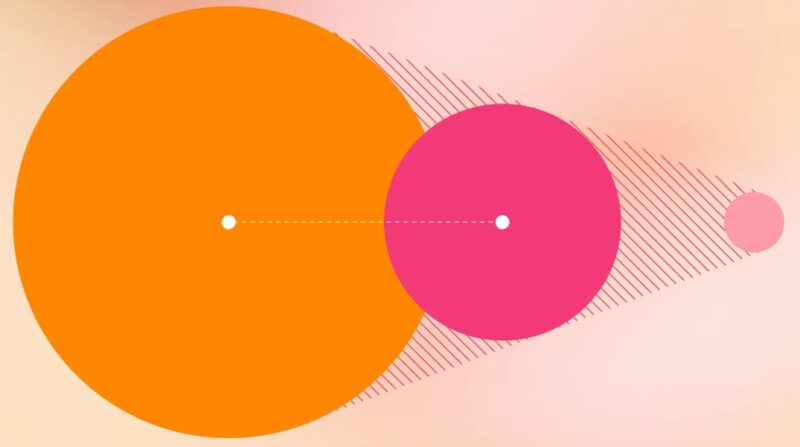

これは、高性能なAI(証明者)が生成した解答を、性能の低いAI(検証者)がチェックするというものです。

具体的には、証明者が複数の解答を生成し、検証者がその中から正しいものを選ぶというプロセスを繰り返します。

この過程で、証明者はただ正しい解答を生成するだけでなく、分かりやすく提示する能力も求められます。

研究チームは、小学生向けの算数の問題を例に、この手法の有効性を示しました。

問題を解く過程で、証明者であるAIが解答を生成し、検証者であるAIがその正確性を評価するという手順を繰り返しました。

その結果、人間の評価者が誤りを犯す割合が減り、解答の分かりやすさが向上しました。

この研究では、以下の重要な発見がありました。

- 人間が書いた解答を参考に学習させたAIは、分かりやすい解答を生成するものの、正確性に欠ける。

- 正確性だけを重視して学習させたAIは、正確な解答を生成するものの、分かりやすさに欠ける。

- 「証明者-検証者ゲーム」で学習させたAIは、分かりやすさと正確性のバランスが取れている。

また、この研究では、効果的なAIの種類も明らかになりました。

- 正確な検証者AI:間違った解答を的確に見抜く。

- 優秀な証明者AI:人間にとって分かりやすい解答を生成し、人間の評価ミスを減らす。

- ずる賢い証明者AI:最初のうちは人間を混乱させるような間違った解答を生成するが、その後のAIの改善を促進する役割を果たす。

AIが様々な分野で重要性を増す中で、そのアウトプットが信頼できるものであるかどうかを知ることは重要です。

AIに対して明確で検証可能な解答を生成するように求めることで、その出力に対する信頼性を高めることができます。

この方法は、将来の超高性能なAIシステムの開発にも役立ち、人間の価値観や期待に沿った信頼性の高いAIシステムの開発に貢献します。

今回の研究はまだ一つのデータセットを用いた実験段階であり、真の正解データが必要となります。

しかし、このような手法は、正確でありながらも透明性が高く、検証可能な出力を持つAIシステムの開発において、信頼性と安全性を高める重要な手段となることが期待されます。

出典:Prover-Verifier Games improve legibility of language model outputs | OpenAI