OpenAIは、新たな小型推論モデル「o3-mini」の正式提供を開始しました。

2024年12月に発表されていたこのモデルは、本日よりChatGPTとAPIの両方で利用可能となります。

科学・数学・コーディング分野に特化し、高速かつ低コストでの推論を実現するのが特徴です。

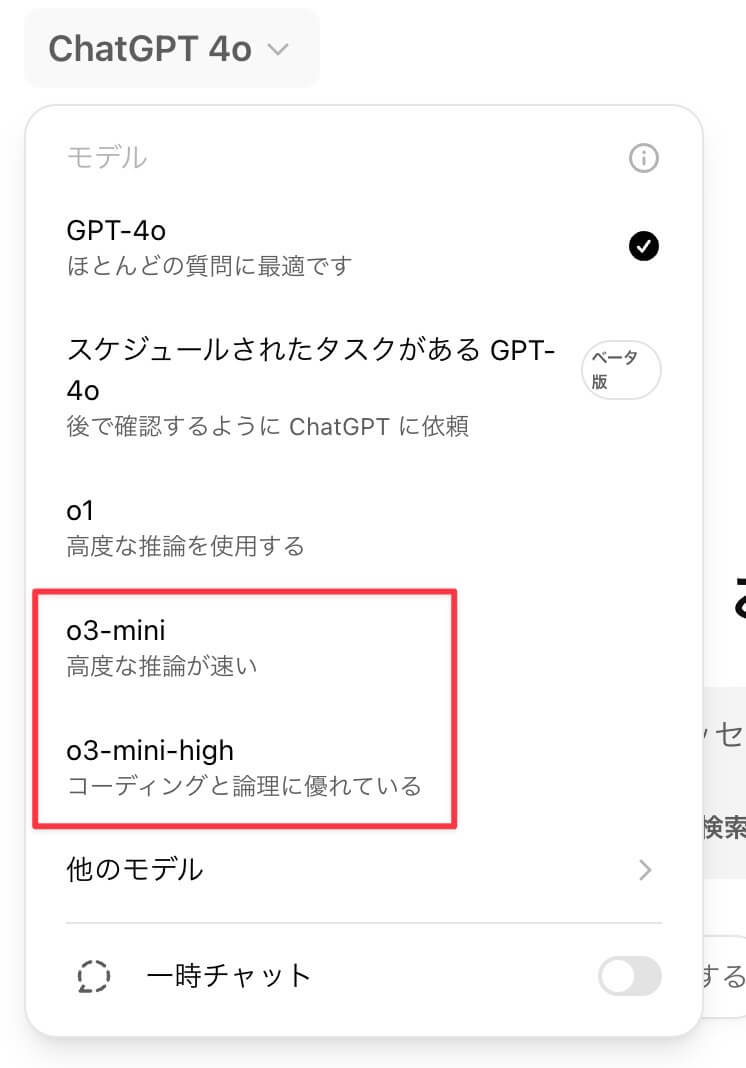

ChatGPTでは、有料プランのPlus、Team、Proユーザーが「o3-mini」にアクセスできるようになりました。

これまで利用されていた「o1-mini」に代わり、新たな標準モデルとして実装されます。

また、メッセージの送信上限が拡大され、PlusおよびTeamユーザーは1日50回から150回に増加しました。

さらに、すべての有料ユーザー(Plus、Team、Pro)が「o3-mini-high」を利用可能 です。

「o3-mini-high」は、より高度な推論を行うオプションで、難易度の高い数学問題や競技プログラミングなど、正確な推論が求められる場面で使用されます。

Proユーザーは「o3-mini」および「o3-mini-high」を無制限に利用できるのに対し、PlusおよびTeamユーザーは通常のメッセージ制限内で「o3-mini-high」を選択できます。

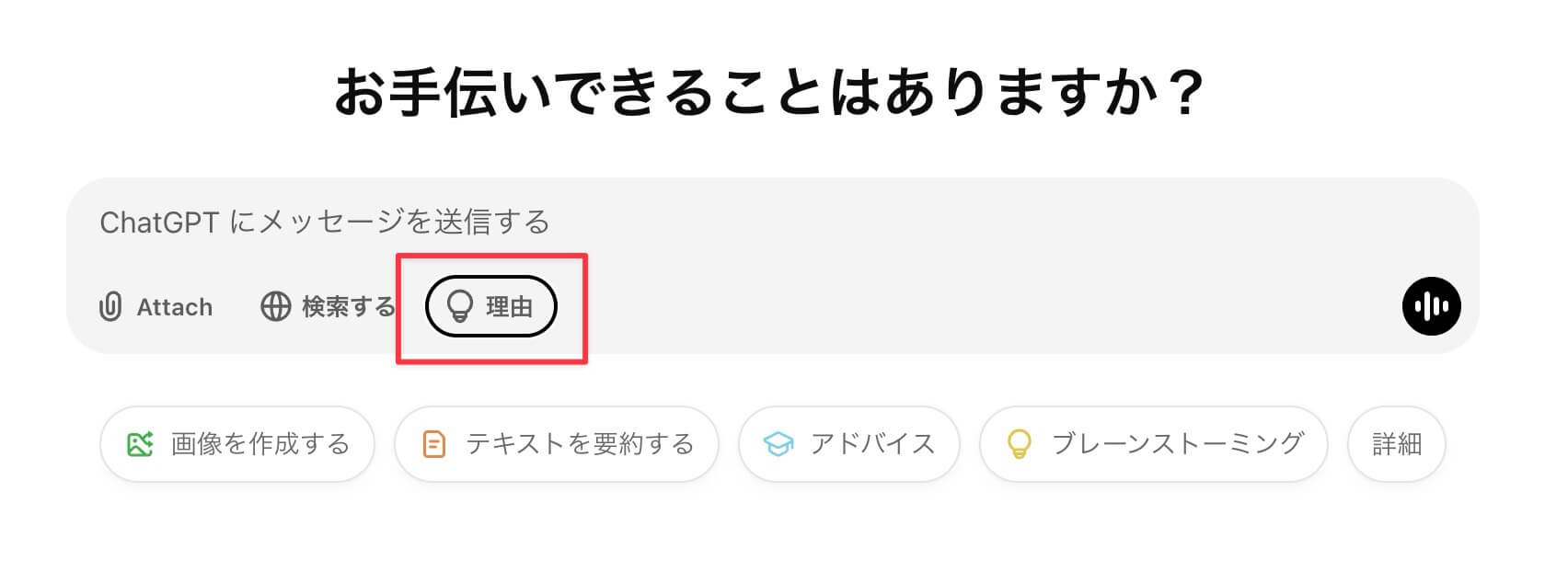

一方、無料プランのユーザーも「Reason(理由)」ボタンを選択することで「o3-mini」を試すことができますが、「o3-mini-high」は利用できません。

APIでは、Chat Completions API、Assistants API、Batch APIを通じて提供され、本日よりAPI使用レベル3〜5の開発者が利用可能となりました。

開発者向けには、推論の負荷を「低(Low)」「中(Medium)」「高(High)」の3段階から選択でき、タスクの複雑さに応じて調整が可能です。

「低」は高速応答を優先し、「中」は精度と速度のバランスを取り、「高」は難易度の高い問題に対してより正確な回答を生成します。

「o3-mini-high」はこの「高(High)」設定に該当し、より高度な推論を必要とする開発環境向けに提供されます。

また、ストリーミング出力や構造化データのサポート、関数呼び出し機能も実装され、プロダクション環境での活用に適した仕様となっています。

ただし、視覚情報の処理には対応しておらず、画像認識などのタスクには引き続き「o1」を使用する必要があります。

「o3-mini」は、STEM(科学・技術・工学・数学)分野の推論に特化し、数学・コーディング・科学分野で優れた性能を発揮します。

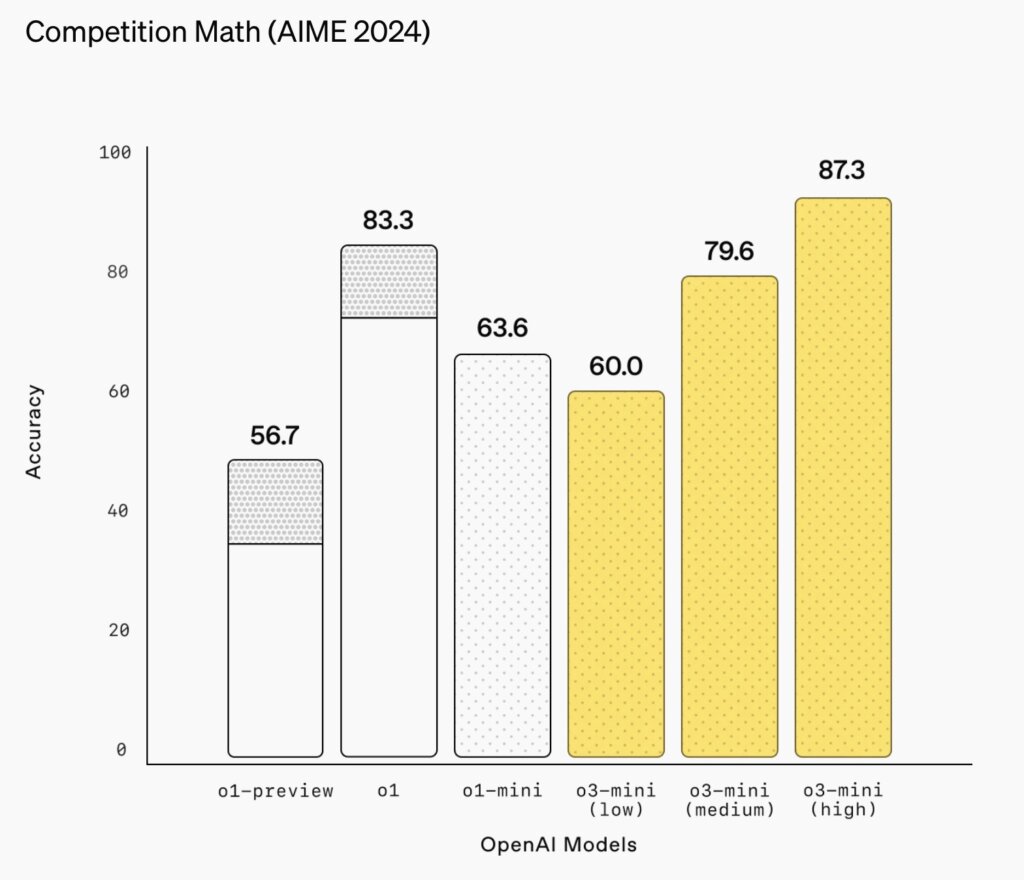

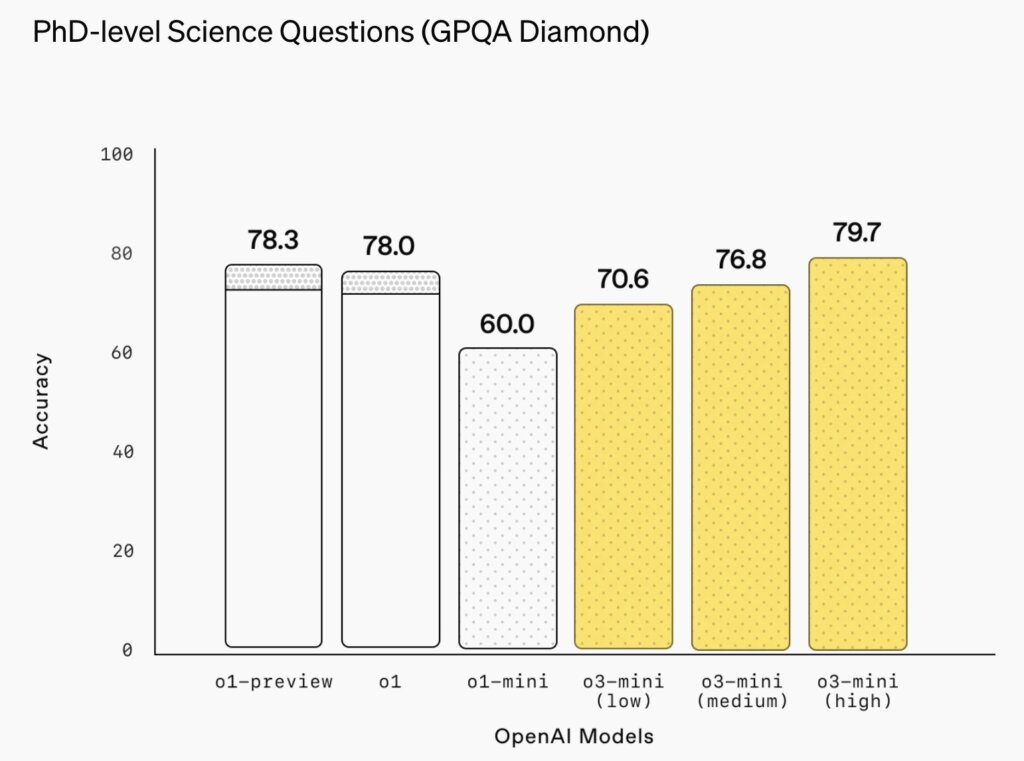

競技数学のAIME 2024では、「o3-mini-high」設定で87.3%の正答率を記録し、博士レベルの科学問題(GPQA Diamond)では79.7%の正答率を達成しました。

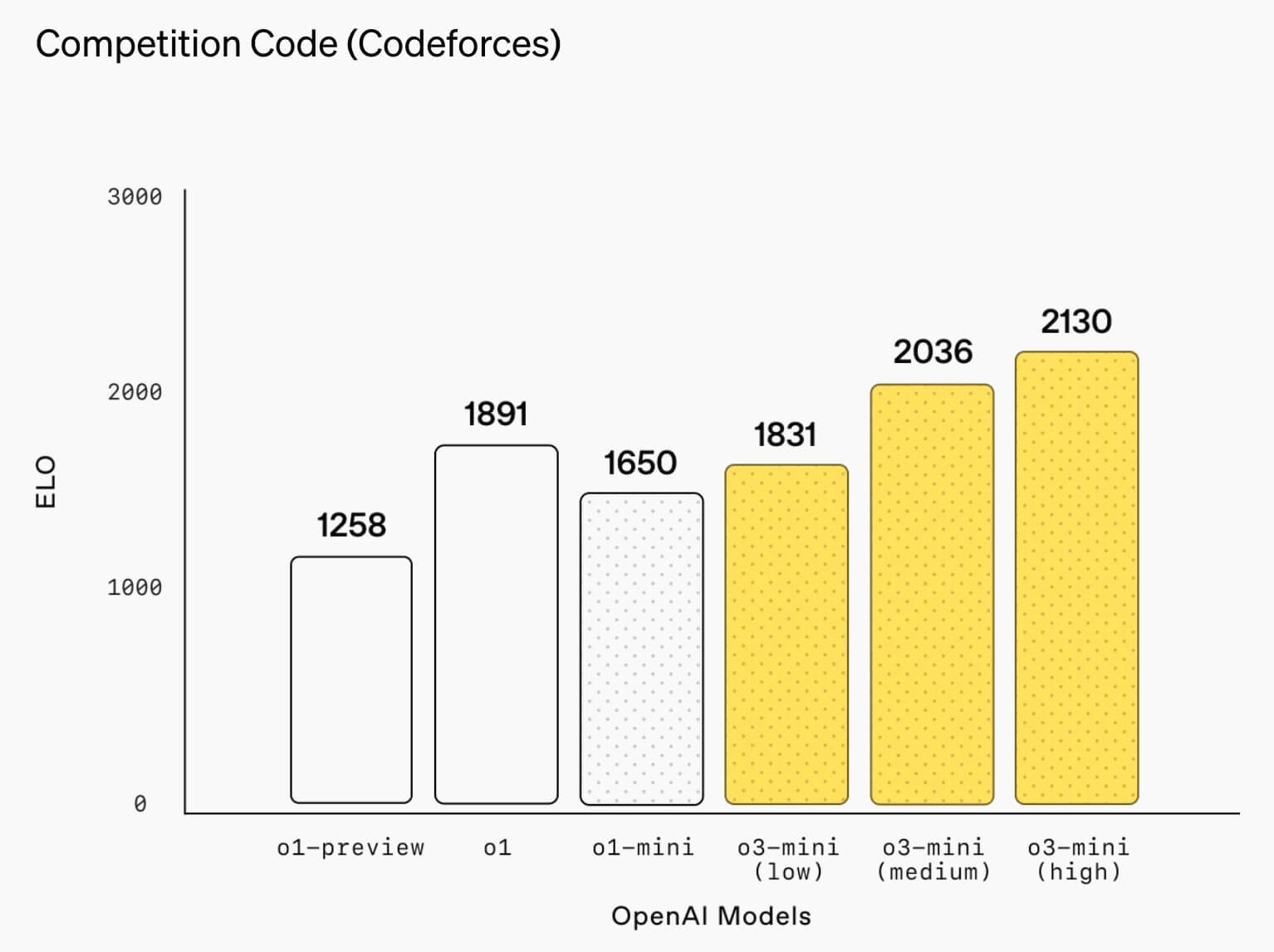

競技プログラミングのCodeforcesでは、「o3-mini-high」設定でEloスコア2130を記録し、ソフトウェアエンジニアリングのSWE-benchでは49.3%の正確性を実現しました。

また、一般知識分野においても「o1-mini」を上回る結果を示し、テストユーザーの56%が「o1-mini」よりも「o3-mini」の回答を好評価しました。

さらに、複雑な問題における誤答率を39%削減することにも成功しています。

パフォーマンス面では、「o1」と同等の知能を維持しつつ、24%高速なレスポンスを実現しました。

平均レスポンスタイムは「o1-mini」の10.16秒に対し、「o3-mini」は7.7秒となり、最初のトークンの出力時間も平均2500ミリ秒短縮されています。

安全性については、OpenAIの従来のモデルと同様に厳格な評価プロセスを経ており、特に「熟考型アライメント」手法を採用し、リスクの軽減に努めています。

GPT-4oを上回る安全性を確保し、より安心して利用できる環境が整えられました。

今回の「o3-mini」の正式提供により、OpenAIはコスト効率の高いAI推論のさらなる発展を目指しています。

AIの普及が進む中で、知能・効率・安全性を兼ね備えたモデル開発を続けていく方針です。