この記事は、Podcast「AI未来話」のエピソード「OpenAI DevDay 2025まとめ!これからのOSは会話?」を再構成した内容をお届けします。

2025年10月に開催されたOpenAI DevDay 2025。年に一度の開発者向けイベントとして注目を集めた今回の発表では、Sora 2 / Sora 2 Pro のAPI公開や Agent Kit / Agent Builder の登場、Codex の正式リリース、そして Apps inside ChatGPT まで、AIの利用環境を根本から変えるニュースが並びました。

番組では、これらを単なる機能発表としてではなく、「会話そのものが次世代OSになる」という視点から考察しています。

DevDay 2025を見て「会話=OS」の未来を感じた

―― DevDay、すごかったですね。

「そうですね。年に一度の開発者向けの発表イベントですけど、今年は特に“次の時代の入り口”を感じました。」

―― どのあたりにそれを感じましたか?

「見ていて思ったんですよ。もう“ホーム画面”っていらないのかもしれない、と。会話そのものが、今後のOSの姿になるのではないかと思ってしまったんです。」

―― なるほど。つまり、UIがなくなるというより、“操作そのものが会話になる”という発想ですね。

「そうそう。今までのOSって、アプリを立ち上げるための土台でしたけど、今後はAIとの会話を通じて、アプリやタスクそのものが生成・実行される。その世界の入口に立っている気がしました。」

―― 確かに、GPTやSora 2を使っていると“画面の外で何かが動く”感覚が出てきましたよね。

「まさに。だから今回は、DevDayで発表された内容を振り返りながら、その先にOpenAIが見据える“新しいOSの形”を考察していきたいと思います。」

―― 今日扱うテーマは、具体的にどんなものですか?

「大きく分けて4つあります。Sora 2 / Sora 2 Pro を含む新APIの公開、Agent Kit / Agent Builder の登場、Codex の正式公開、そして Apps inside ChatGPT。この4つを軸に、技術的進化と“会話OS化”の文脈をつないで話していきます。」

発表①:新API群とSora 2 / Sora 2 Proの透かし無しについて

まず最初のトピックは、新しく公開されたAPI群の中でも注目を集めた Sora 2 / Sora 2 Pro。映像生成AIのAPI解放によって、何が可能になり、どんなリスクが生まれるのかを番組では掘り下げています。

―― ではまず、新しいAPIの発表内容から整理していきましょう。

「今回のDevDayでは、いくつかのモデルがAPI経由で新たに利用可能になりました。たとえば GPT-5 Pro、Sora 2 / Sora 2 Pro、gpt-realtime-miniなどですね。」

- gpt-5-pro

- gpt-realtime-mini

- gpt-audio-mini

- gpt-image-1-mini

- sora-2

- sora-2-pro

―― APIというのは、外部サービスからChatGPTなどを利用するための仕組み、という理解で合っていますか。

「はい、そうです。つまり開発者が自分たちのアプリやサービスの内部に、これらのモデルを直接組み込めるようになったということです。」

―― なるほど。では、今回の目玉はやはりSora 2でしょうか。

「そうですね。Sora 2 / Sora 2 Pro がAPI経由で利用できるようになったのは非常に大きなニュースでした。これまではChatGPTアプリ内部でしか触れなかったモデルが、ついに外部から操作できるようになったわけです。」

―― それは確かにインパクトがありますね。しかも“透かし無し”で生成できるという話もありました。

「そうなんです。API経由で動画を生成すると、従来のようなウォーターマーク(透かし)が入らないんですよ。つまり商用利用も可能になる。これがいま開発者コミュニティではかなり話題になっています。」

―― ただ、料金が結構高いとも聞きました。

「そうですね。Sora 2 の場合、1秒あたり0.1ドル。つまり10秒で1ドル。日本円にするとおよそ150円です。さらに上位モデルの Sora 2 Pro は 1秒あたり0.3ドル、高解像度版だと 1秒あたり0.5ドル まで上がります。」

―― 10秒の映像生成で約700円…。それはなかなか高額ですね。

「そうなんです。だから試しに生成するだけでもけっこうコストがかかる。もし本格的にサービスに組み込もうとすると、相当な費用感になりますね。」

―― 一方で、透かし無しで商用利用できるなら、企業には魅力的かもしれません。

「はい。例えばECサイトなら、商品LPの制作と同時に広告動画を自動生成するような仕組みが作れますし、採用動画や教育動画を量産するSaaSも出てくるでしょう。ただ、逆にSNSなどでは“本物かフェイクか分からない動画”が急増するリスクもあります。」

―― 確かに、透かし無しでAI動画が出回るのは少し怖いですね。

「そうですね。倫理的にもガイドライン整備が追いついていない印象です。ただ、価格が高いため、現時点では“フェイク動画を量産するコスパ”はまだ悪いとも言えます。」

―― つまり、現状では一部の企業や開発者が中心に使うフェーズ、という感じですか。

「そうですね。10秒生成で5ドル、つまり700円以上かかりますから、まだ気軽に誰でも使う段階ではない。むしろ、先進的なプロジェクトで検証を進めるような層にとって、やっと実戦投入できる環境が整ったという印象です。」

―― OpenAIとしては、Sora 2をまずAPIとして開放し、そこで商用利用のエコシステムを形成していく狙いがありそうですね。

「その通りです。実際、Sora自体はSNSアプリとして一般向けにも展開しています。そこで“遊び場”として使ってもらい、収益はAPIから取るという構造です。無料のフロントと有料のバックエンドを完全に分離する設計なんですね。」

発表②:Agent Kit(Agent Builder)

次に取り上げるのは、DevDayで発表された Agent Kit (Agent Builder)。名前からは「誰でも使えるノーコードツール」を連想しますが、実際にはエンジニアの働き方を根本から変える可能性を秘めた“開発者向け基盤”でした。

―― 次のトピックはAgent Kitですね。これはどういったものなんでしょうか。

「一言で言うと、“エージェントを構築・展開・最適化するための包括的ツールセット”です。OpenAIが今回発表したAgent Kitは、その中にAgent BuilderというGUIベースのビルダー機能を含んでいます。」

―― つまり、エージェント開発を効率化するためのパッケージのようなもの。

「そうです。たとえるなら、ワークフロー構築ツールのような存在です。Dify や n8n に近いUIで、ノーコード感覚でフローを組み立てることができます。ただし、あくまで“開発支援ツール”であって、完全なノーコードではありません。」

―― なるほど。非エンジニアでも触れるけれど、中心はエンジニア層なんですね。

「まさにそこが重要です。Agent Builderは、“コードを書かない開発”というより、“コードを速く正確に試すための設計環境”に近いです。最終的にはTypeScriptでコード出力もできる仕様なので、プロトタイピングを簡略化するためのものなんですよ。」

―― それはむしろ、ノーコードというより“プロトタイピングツール”に近い。

「そうです。実際、今回の発表後、Difyの導入支援をしている会社の代表がXで『これは非エンジニア向けというより、エンジニアのためのツールだ』と指摘していました。僕もその見方に完全に同意しますね。」

これ、Agent Builderは非エンジニアのためのものではないね。

— 岸田崇史 | Omluc (@omluc_ai) October 7, 2025

OpenAI Dev DayでAgent Builderが発表されて、ノーコードでワークフローを簡単に作れるって話で、Difyやn8nオワコンという話があるけど、動画見ればわかるけど、非エンジニアに使いこなせるものではない。… https://t.co/EDgivBmaXV

―― なるほど。Agent Builderと他社サービスは何が違うんですか。

「まず、Agent KitではOpenAIのモデルしか選べません。他社のモデルや外部APIとの自由な接続はまだ限定的です。だから汎用ワークフローのような柔軟性は Dify や n8n のほうが高い。でも逆に、OpenAIエコシステムで完結するなら非常にスムーズなんです。」

―― なるほど。“OpenAI完結型”の強みがあるわけですね。

「そうです。ChatGPTやApps inside ChatGPTとの連携も想定されていて、将来的には『ChatGPT上でAgentを呼び出して操作する』という世界が現実になりそうです。つまり、ユーザーは“会話の中でAgentを動かす”という体験を得ることになります。」

―― それこそ、先ほどの『会話がOSになる』世界に直結しますね。

「はい。今まではワークフローを“作る”こと自体が目的でしたが、今後はそれを“会話で呼び出す”方向に変わっていくと思います。Agent Builderで設計して、ChatGPTで操作する。そんな構造が見えてきます。」

―― その場合、エンジニアのスキルセットも変わりそうです。

「確実に変わります。これまでのように“どの言語が書けるか”ではなく、“データをどう持たせ、どう繋ぐか”というロジック設計力が重要になります。Agent Builderが象徴するのは、この“設計を可視化する”方向へのシフトです。」

―― なるほど。コーディングスキルよりも、構造を理解して設計できる人が強くなると。

「そうですね。たとえばチームで開発を進めるときも、エンジニアはAgent Builderでロジックを共有し、そこからTypeScriptコードを出力して本実装につなげる。だから“設計を共有するレイヤー”としての役割が大きくなります。」

―― それは開発プロセスの透明化にもつながりますね。

「ええ。特にLLMやマルチエージェントを扱う開発では、設計段階の可視化がすごく重要です。だからこのAgent Kitの登場は、いわば“AI開発のFigma”に近い存在になるかもしれません。」

―― “AI開発のFigma”とは面白い表現ですね。

「設計を図式化し、共有し、実装に落とし込む。その一連の流れを支援するツールです。OpenAIがそこを押さえに来た、というのが今回の本質的な意味だと思います。」

―― なるほど。ノーコードという言葉に惑わされがちですが、実態はエンジニアリングの再定義なんですね。

「まさにその通りです。Agent Builderは“エンジニアを不要にするツール”ではなく、“エンジニアの思考を加速させるツール”。その文脈で理解すると、一気に見え方が変わると思います。」

発表③:Codex正式公開とSlack統合

続いて取り上げるのは、OpenAIが誇る開発支援モデルCodexの正式リリースです。

DevDay 2025では、すでに実用段階にあったベータ版を経て正式公開となり、Slack連携やSDK発表など、開発現場の“作り方”そのものを変える発表が続きました。

―― 続いては「Codexの正式リリース」ですね。

「そうです。GPT-5 Codex がついに正式にリリースされました。」

―― あれ、もう出てたような気がしてましたけど、まだベータだったんですね。

「そうなんです。僕ももう正式版だと思ってました(笑)。でも今回ようやく正式化されて、Slackとの統合が発表されました。」

―― Slackと?それはどういうことなんですか。

「Slackの中でAIに直接話しかけて、コードを書いてもらったり、レビューしてもらったりできるんです。“この関数を修正して”とか“この部分最適化して”みたいな指示を出すと、AIがコードを書いて提案してくれる。」

―― なるほど。まさにAIがチームメンバーみたいな感じですね。

「そう。しかも、そのままPull Requestを作ってくれるんです。実際にSlack上で作業して、コード修正まで完結できるようになってます。」

―― へえ、それは便利ですね。いちいちIDEを開かなくてもいいと。

「そう。Slackがそのまま開発環境になるイメージです。あと今回、Codex SDK も公開されていて、自分のアプリケーションやツールにも組み込めるようになりました。」

―― なるほど。SDKが出たことで、一気に広がりそうですね。

「そうですね。あと面白かったのは、OpenAIが言ってたんですけど、Codexがこれまでに処理したトークン数が40兆トークンを超えたらしいんです。」

―― 40兆!? それはとんでもないですね(笑)。

「そう(笑)。つまりもう、AIが人間より多くコードを書いてるんですよ。最近では“AIがAIのコードを書く時代”って言われてます。」

―― なるほど。確かに、すでにCopilotとかもそういう流れですもんね。

「そう。だけどCodexは、Copilotよりもさらに“チーム単位”の動きを意識してるんです。だから、Slack統合=チームでAIと一緒に開発するっていう位置づけ。」

―― なるほど。個人の補助じゃなくて、チーム全体に入ってくると。

「そうです。OpenAIが言ってたのは、“AIがチームの一員になる”という表現でした。つまり、AIがチームメンバーの一人として、Slackのスレッドやタスクに参加する。」

―― それはすごい。もうAIがプロジェクトにアサインされてるみたいな感じですね。

「そうそう(笑)。“AIを新しく採用しました”みたいなノリです。AIがコードを書いて、AIがレビューして、最終判断を人間がする。」

―― なるほど。じゃあエンジニアの役割も変わりますね。

「そうなんです。最近はもう、“コードを書く”よりも“コードを読む”方が大事になってきてます。AIが生成したコードを理解して、最適化する。つまり“読む力”が求められる。」

―― ああ、リーディングの方ですね。

「そう。AIがいくら賢くても、間違った仕様で書いてしまったら意味がないですから。だから、人間は“文脈を理解して判断する役割”になっていくんだと思います。」

―― たしかに。AIが全部書くようになると、最終的に何を正解とするかの判断力が大事になりますもんね。

「そう。OpenAIの中でも“AIがコードを書き、AIがレビューし、最後に人間が承認する”という流れになってるそうです。」

―― なるほど。完全に作業構造が変わってきてますね。

「そう。だから“どの言語が書けるか”じゃなくて、“どう設計して、どうつなげるか”が重要になる。要は、設計の力が問われる時代に入った。」

―― なるほど。もう“手で書くスキル”より“頭で組むスキル”なんですね。

「そうですね。で、今回のCodex正式化は、まさにその象徴です。Slackとつながることで、開発の現場が会話ベースになっていく。」

―― “コードを書く”というより“会話で開発する”感じ。

「そうです。まさにそう。今回のDev Dayのテーマでもある『会話がOSになる』という流れの中で、Codexは“開発現場のOS化”を担っていると思います。」

―― なるほど。裏テーマがそこにつながるわけですね。

「はい。Sora 2やAgent Kitが表の派手な発表だったとすれば、Codexは裏の革命。開発プロセスを根本から変える、地味だけど一番大きな発表だったと思います。」

発表④:Apps inside ChatGPT:8億人が使う会話ベースのOSへ

最後に取り上げるのは Apps inside ChatGPT。ChatGPTの会話中から外部アプリを呼び出せるようになったこの機能は、OpenAIが“会話そのものをOS化”しようとしている象徴的な一歩だと感じます。

―― 次は「Apps inside ChatGPT」ですね。これはどんな機能なんでしょうか。

「ChatGPTとの会話の中で、アプリを呼び出して使えるようになる機能です。提案されたり、自分で指定したりして起動できるんですよ。」

―― たとえばどんなアプリが呼び出せるんですか?

「現時点では英語圏ではBooking.com・Canva・Coursera・Figma・Expedia・Spotify・Zillowの7つのアプリがが登録されていて、ChatGPT上から直接使えるようになっています。」

―― へえ、我々の配信プラットフォームの Spotify も入っていますね。

「そうなんですよ。たとえば『Spotifyでプレイリストを作って』って指示すると、実際にChatGPT上からSpotifyが操作できるようになるわけです。」

―― Zillowとか馴染みがないですけど、日本でも使えるってことですか?

「僕が試したところ、今は Booking.com、Canva、Coursera、Figma くらいしか動かないですね。特にCanvaは“日本語は対応していません”と返されてしまうので、僕が試してまともに活用できたのは今のところFigmaくらいでした。」

―― なるほど。今のところは有名サービスが中心なんですね。

「はい。で、今回の発表で大きかったのが、『Apps SDK』 という仕組みです。」

―― Apps SDKって何ですか?

「これは開発者向けのツールキットで、ChatGPTの中で動くアプリ(Apps inside ChatGPT)を作るための仕組みなんです。自分のサービスをChatGPT内に組み込み、ユーザーが会話から直接呼び出せるようになる。つまり、アプリを“ChatGPT上で動作させる”ことが正式にできるようになったという発表でした。」

―― なるほど。それはアプリ開発者にとっては大きい変化ですね。

「そうですね。今回の発表のポイントは、ChatGPTの週間アクティブユーザー数が8億人を超えたというところにあります。このApps SDKを使ってアプリを開発すれば、その8億人にリーチできる。つまり、ChatGPTがひとつの“アプリプラットフォーム”になったということなんです。」

―― なるほど、アプリを配信する新しい経路ができたわけですね。

「はい。しかも今回の仕組みは、GPTs機能の強化版のような位置づけです。以前のGPTsはそこまで普及しませんでしたが、今回の“Apps inside ChatGPT”は、SpotifyやCanvaのような著名サービスと連携している点が大きい。」

―― そうか。過去のGPTsよりも、実用サービスが並んでいるんですね。

「そうなんです。ChatGPT上でアプリを操作できる=会話の中がOSになるという考え方。これがまさに“AIネイティブOS”の概念です。アプリを起動して操作するんじゃなくて、AIとの会話の流れでアプリが動くんですよ。」

―― 会話そのものがOSの操作になる、ということですね。

「はい。これが実現すると、スマホのホーム画面がいらなくなる可能性がある。今後は“アプリを開く”ではなく、“AIに話す”ことで全てが動く時代になると思います。」

―― なるほど。たしかに、ここまで来ると“会話OS化”が現実的に感じますね。

「そうなんです。OpenAIがこの方向に進んでいるのは間違いないですし、今回のApps inside ChatGPTは、その未来への最初のステップだと思います。」

AIネイティブOSとは何か?会話がアプリを動かす時代へ

スマホやPCのOSがアプリを起動する時代から、会話そのものがアプリを動かす時代へ。OpenAIが見据える未来像が、今回のDev Dayに現れていました。

―― 田附さんが言っていた「AIネイティブOS化」って何なんですか?

「はい。簡単に言うと、AIがOSそのものになるっていうことです。たとえば、スマホOSだとホーム画面からアプリを起動して操作しますよね。でもAIネイティブOSでは、AIとの会話そのものが“アプリ操作”になるんです。」

―― たとえばスマホのホーム画面を経由せずに、AIとの会話中で『Canva開いて画像作って』みたいにやる感じですね。

「まさにそれです。今までは“アプリの中にAIがいる構造”だったんですが、これからは逆。AIが中核にあって、その中にアプリが入っていく構図になると思うんです。」

―― なるほど。今後のOSは、ホーム画面やアイコンではなく、会話そのものが操作になるということですね。

「そうです。ChatGPTとの会話の流れをAIが理解して、『じゃあこのアプリ使いましょう』と判断して開く。だから、会話=OSという考え方になるわけです。」

―― つまり、テキストや音声のやりとり自体がOSのUI(ユーザーインターフェース)になる、と。

「そう。これからのアプリは“会話を前提にした設計”を意識しないといけなくなると思います。ユーザーが何を話しているのか、その文脈を理解して動くアプリ。」

―― 会話がコンテキストとして溜まっていくイメージですね。

「まさに。AIはそのコンテキストを基に、最適なアプリを選んだり、情報を整理して動かす。だから会話がOSになるというわけです。」

―― なるほど。OpenAI以外の企業も同じ方向に進んでいるんですか?

「はい。たとえばNothingというスマホメーカーがあるんですけど、そこが最近『Essential』という新しいAIプラットフォームを発表したんです。これも完全に会話ベースなんですよ。」

Nothingは、新しいAIプラットフォーム「Essential」を発表した。また、コアコンポーネントとなるアプリケーションのEssential Appsと新しいプラットフォームのPlaygroundもリリースされた。

出典:Nothing、新AIプラットフォーム「Essential」を発表 – ケータイ Watch

―― どういう仕組みなんですか?

「“レシートを毎週金曜にPDF化して提出用にまとめて”とか、そういう指示を話すと、その内容に合わせた小さなアプリが自動で生成されてホーム画面に追加される。まさに“会話からアプリが生まれる”仕組みです。」

―― へえ、それはすごいですね。

「しかもそのアプリを他の人と共有・編集できるようにしていく予定だそうで、“ユーザーの個性に合わせて変化するOS”を目指しているらしいです。」

―― 会話からアプリを作るという点では、ChatGPTのApps inside ChatGPTと似てますね。

「そう。発想はかなり近いと思います。OpenAIが以前失敗したGPTsの延長線にあるような構想ですけど、Nothingの場合は自動生成がより強い。ただ、こういう“自作アプリ型”の流れは流行らずに終わる可能性もありますね。」

―― なるほど。じゃあ、やっぱりApps inside ChatGPTの強みは、既に使われているサービスがそのまま連携できる点にある。

「そうですね。SpotifyやCanvaのような著名アプリが会話の中で動くというのは、ユーザーの導入ハードルを大きく下げる。だから今回は同じ流れでも、“使われる可能性”が高いと思います。」

―― つまり、会話が起点となってアプリが呼び出されるという構造が、いよいよ現実になってきているわけですね。

「そう。これがまさにAIネイティブOSの始まりだと思います。」

Google・Apple・MicrosoftのAIネイティブOS戦略

AIネイティブOSの流れは、OpenAIだけでなく他の大手テック企業にも広がっています。

Google、Apple、Microsoft——それぞれが自社の既存OSを“AI中心”に再構築しようと動き出しています。

―― OpenAI以外でも、AIネイティブOSに向けた動きはあるんですか?

「あります。たとえばGoogleですね。彼らは『Project Astra』や『Gemini Live』など、会話アシスタントを前面に出した構想を発表しています。」

―― ああ、最近よく聞くGeminiシリーズですね。

「そうです。で、実はGoogleは2026年に新しいOSを出すと発表しているんですよ。」

―― 新しいOS?それはAndroidとかChrome OSとは別なんですか?

「正確に言うと、Chrome OSとAndroidを統合する方向らしいです。その目的が“AIサービスのGeminiを中核に置くこと”。」

ChromeOSとAndroidを統合する主な目的はAIサービス「Gemini」にある。Geminiによって、ユーザーはあらゆることをAIエージェントであるGeminiに語りかけるようになる。

将来的にはひとつひとつのアプリを起動するなんてことはせず、やりたいことはすべてGeminiにお願いすれば良くなる。実際に背後でアプリを起動し、サービスにつなぎ、作業をするのはGaminiであり、ユーザーはGeminiがやった結果を待てばいい。

出典:Googleが2026年に”PC向けOS”をリリースへ、ChromeOSとAndroidを統合し「Gemini」が中心に – ケータイ Watch

―― なるほど、AIを中心に再設計するということですね。

「はい。今までは“アプリが主役”のOSだったのが、今後は“Geminiを中心に、アプリが動く”構造に変わる。つまり、まずユーザーがGeminiに話しかけて、Geminiが必要なアプリやエージェントを動かす形。」

―― まさに“AIネイティブOS”の構想そのものですね。

「そうです。Googleはそれを明確に狙っていて、会話を起点にOS全体を動かすように作ろうとしています。」

―― なるほど。Geminiが中心にあって、会話から操作が生まれるわけですね。

「そう。AIとの“コミュニケーションのキャッチボール”から、アプリやタスクが動いていく。まさにOpenAIと同じ方向性です。」

―― 他の会社も同じような動きをしていますか?

「ええ。Appleもそうですね。『Apple Intelligence』という新しい機能群を発表していますし、Microsoftも『Copilot+ PC』を出しています。」

―― なるほど。既存のOSにAIを組み込むアプローチなんですね。

「そうです。OpenAIやNothingが“AIそのものをOS化”していく流れに対して、AppleやMicrosoftは“既存OSの中にAIを溶け込ませる”流れです。両方の方向が今、並行して進んでいます。」

―― つまり、OpenAIは“AIをOS化”していて、AppleやMicrosoftは“AIをOSに組み込む”。方向は違ってもゴールは同じという感じですね。

「まさにそうです。みんな“会話を中心にしたインターフェース”を目指しているんです。」

―― たしかに、音声やテキストで自然に話しかける操作って、もう現実的になってきましたもんね。

「はい。僕たちも実際、ChatGPTを音声入力で使うことが増えてますよね。だから“AIと話す”ことが日常になりつつある。」

―― そう考えると、1年前の予想が当たってたってことですね。

「そうそう。僕たちが『【年始特別回】2025年AIはOSになる!?未来予想と新年の抱負』で話した内容、覚えてます?あの時、僕は“2025年はAIがOSそのものになる”って予測したんですよ。」

―― ああ、言ってましたね。まさにその通りの流れになってる。

「ちょっと時期は早かったけど(笑)、方向性としては完全に合ってました。」

―― 平岡さんも“AIに話しかけるのが当たり前になる”って言ってましたよね。

「そう。で、実際もうそうなってきてる。僕も最近は音声入力ばかりでChatGPTを使ってるし、会話が主軸になる流れは確実に来てる。」

―― なるほど。二人の予測が合流して、現実になったわけですね。

「そう。まさに“会話=OS”の時代に、今我々は足を踏み入れてると思います。」

デバイスの未来は?会話ベースのハードウェアへ

会話がOSになるなら、当然その“入り口”となるデバイスも変わっていく。スマホ中心の時代は終わり、AIが常に耳と目を持つような新しいハードウェアが登場し始めています。

―― で、最後はやっぱり「デバイス」の話になりますよね。

「そうなんですよ。結局この流れの先には、どんなデバイスが出てくるかって話になる。」

―― 今回のDev Dayでも、ジョニー・アイブとの対談がありましたよね。あれ、新しいデバイスの話とかは出たんですか?

「そこはね、まったく触れられなかったんです(笑)。対談では“デザインの信念”とか、“AIがもたらす時代の変化”についての話が中心で、“新しいハードウェア”の具体的な発表はなかったです。」

―― ああ、なるほど。ちょっと残念ですね。

「そうですね。ただ、報道によるとOpenAIとアイブが複数のAI搭載デバイスを構想中で、15〜20種類のプロトタイプがあるとかないとか言われています。」

―― そんなに!? それはすごい。

「そう。だから、まだ何かしらの形で発表される可能性は高いと思います。個人的には、会話ベースのデバイスになるのはほぼ確実かなと思ってます。」

―― たしかに。最近の流れを見ても、会話型デバイスが主流になってきてますよね。

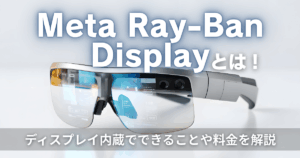

「そうなんです。たとえばRay-Ban Meta。カメラとマイクが常時オンで、見て・聞いて・答える仕組み。まさに“会話で完結する設計”ですよね。」

―― あれは確かにAIネイティブOS的ですよね。音声で全部完結する。

「そう。あと、最近ニュースになってたんですけど、Google HomeスピーカーのGemini対応モデルが来年発売されるらしくて。」

Gemini を中心に設計したスマートホーム デバイスの新製品、Google Nest Cam Indoor(電源アダプター式 / 第 3 世代)、Google Nest Cam Outdoor(電源アダプター式 / 第 2 世代)、Google Home スピーカーの 3 製品をご紹介します。

2 つの新しい Google Nest Cam 製品は本日 10 月 1 日より発売します。なお、両製品の日本での Gemini への対応は 2026 年初頭を予定しています。また、今回初公開となる Google Home スピーカーは、Gemini のために初めて開発されたオーディオ デバイスです。日本と米国を含む対象地域で、2026 年春の発売を予定しています。これらの新製品はすべて、Gemini の機能を最大限に引き出すために最適化されています。

出典:Gemini 搭載予定の最新の Google Nest Cam 製品と、2026年 春に発売予定の Google Home スピーカー登場

―― あ、そうなんだ。

「はい。だから、家の中で“ねぇGemini”って話しかけると、会話の中でアプリが動くような感じになるかもしれません。」

―― なるほど。そうなると、スマホ中心のUIはもう古くなりそうですね。

「そうなんです。会話を前提にした設計が主流になると、スマホの“画面を触る”操作は減っていくと思います。」

―― とはいえ、みんながRay-Banみたいな眼鏡型デバイスをつけてたら、ちょっと異様な光景になりません?

「そうそう(笑)。最近みんな目が悪くなったのかなって感じになりますよね。」

―― コロナの時のマスクみたいに、“全員が眼鏡”の時代。

「そう。だから眼鏡型を嫌がる人も絶対出てくると思う。僕はずっと眼鏡だからいいんですけど、世界中が眼鏡になるのはちょっと怖い(笑)。」

―― わかります。その“見た目問題”は大きいかもしれませんね。

「そう。だから、スマホでもなく、眼鏡でもない、“バッジ型”とか“ネックレス型”みたいなデバイスが出てくると思う。」

―― なるほど。常時装着できて、音声とセンサーで動くタイプですね。

「そう。腕につけるだけで自分の行動やコンテキストを自動で収集して、ChatGPTに投げて、必要なアプリを呼び出して、まるで完全な秘書みたいに動く。そういう未来を考えてると思います。」

―― 確かに、それが理想ですね。

「僕はそういうデバイスが出てくるのをすごく期待してます。AIと自然に会話しながら、生活や仕事が動く。そういう設計がどんどん進んでいくと思う。」

―― その時、アプリやサービスの側も“会話前提”で設計されていないと、シームレスにつながらないですよね。

「そうなんですよ。だから、エンジニアもビジネス側も、会話を想定した設計に変えていく必要があると思います。」

―― なるほど。デバイスもOSも、そしてアプリも“会話”でつながる時代になっていくわけですね。

「はい。OpenAIの方向性を見ても、そこを見据えて動いてる感じがしますね。」

まとめ

Dev Day 2025で発表された4つのトピック「新規API公開・Agent Kit(Agent Builder)・Codex正式版・Apps inside ChatGPT)。これらはいずれも単発の新機能ではなく、「会話がOSになる」未来への布石でした。

AIがOSの中心に座り、アプリやデバイスがその文脈に従って動く時代。エンジニアは構造を設計し、ビジネス側は“会話を前提にした体験”を作る必要があります。

AIと人間が自然に協働する未来の始まりを、OpenAIはこのDev Dayで明確に示したように感じます。