GPT-5.1-Codex-Maxとは、OpenAIが発表した最新の自律エージェントコーディングモデルです。

従来のコーディングモデルと異なり、長時間にわたる自律的なタスク遂行が可能となりました。

また、コンパクションと呼ばれる要約の仕組みにより、文脈を保持しながらタスクを実行することができます。

この記事では、GPT-5.1-Codex-Maxの概要や使い方、料金プランについて解説します。

GPT-5.1-Codex-Maxとは?エージェント型コーディングモデルの概要

GPT-5.1-Codex-Maxは、2025年11月にOpenAIから発表された、自律的なタスク遂行能力に特化したコーディングモデルです。

従来の対話型支援を超え、長時間にわたり複雑なエンジニアリング課題を解決し続ける「エージェント型」として再設計されました。

ここでは、その概要と特徴について解説します。

GPT-5.1・GPT-5.1-Codexの違いと位置づけ

GPT-5.1-Codex-Maxは、汎用モデルであるGPT-5.1や、従来のコーディング特化型であるGPT-5.1-Codexとは一線を画すエージェント型コーディングモデルとして位置づけられています。

従来のCodexが単一のコンテキストウィンドウ内での対話的なコード生成や修正を得意としていたのに対し、Maxは自律的に長時間のタスクを遂行するエンジニアリングパートナーとして設計されました。

最大の違いは、複数のウィンドウをまたいで文脈を維持できる点にあり、これにより単発の支援ではなく、プロジェクト全体を見渡した継続的な作業が可能になっています。

OpenAIは本モデルをCodex環境における新たなデフォルトとしており、より複雑で自律性が求められる開発タスクへのシフトを明確にしています。

また、推論能力とトークン効率のバランスが最適化されており、同じ推論深度でも従来モデルより少ない思考トークンで高品質なコードを生成できる点が特徴です。

コンパクションと長時間タスク対応の仕組み

本モデルの核心となる技術が、数百万トークン規模の文脈維持を可能にするコンパクションと呼ばれるプロセスです。これは、コンテキストウィンドウの上限に達した際に、過去の履歴を単に切り捨てるのではなく、タスク遂行に必要な重要情報を保持したまま自動的に要約・圧縮する仕組みです。

モデルはこの圧縮された記憶を引き継いで新たなウィンドウで作業を継続するため、長時間にわたり思考を連続させることができます。

例えるなら、膨大な議事録を要約しながら作業を続けるイメージです。

このプロセスはモデルのトレーニング段階からネイティブに組み込まれており、外部ツールに頼ることなく自律的に記憶の整理を行います。

結果として、文脈の喪失による品質低下を防ぎながら、24時間を超えるような長時間のデバッグや実装作業を一貫性を保って実行することが可能になりました。

GPT‑5.1-Codex-Max can work independently for hours at a time. In our internal evaluations, we’ve observed GPT‑5.1-Codex-Max work on tasks for more than 24 hours.

訳)GPT‑5.1-Codex-Maxは、1 回の作業で数時間にわたり単独で動作できます。社内評価では、GPT‑5.1-Codex-Max が24時間以上タスクに取り組むことも確認しています。

出典:Building more with GPT-5.1-Codex-Max

GPT-5.1-Codex-Maxで解決しやすい開発タスクの例

GPT-5.1-Codex-Maxは、従来モデルではコンテキスト不足で失敗しやすかった大規模なリファクタリングや、ファイル数が膨大なプロジェクト全体の修正タスクで真価を発揮します。

依存関係が複雑な複数ファイルにまたがる機能追加や、再現が困難なバグの調査から修正までを自律的に行う長時間のエージェントループなどが挙げられます。

また、本モデルは初めてWindows環境での動作を含めてトレーニングされているため、OS固有の環境構築やPowerShellを用いた操作が必要なタスクにも柔軟に対応できます。

GPT‑5.1-Codex-Max is the first model we have trained to operate in Windows environments

訳)GPT‑5.1-Codex-Max は、Windows 環境で動作するよう学習した当社初のモデルです。

出典:Building more with GPT-5.1-Codex-Max

SWE-bench Verifiedなどのベンチマークでも高い精度を記録しており、プルリクエストの作成からコードレビュー、テストの実装まで、一連のエンジニアリングワークフローを丸ごと任せるような使い方が現実的になっています。

GPT-5.1-Codex-Maxの性能

続いて、GPT-5.1-Codex-Maxの性能を、ベンチマークなどから見ていきます。

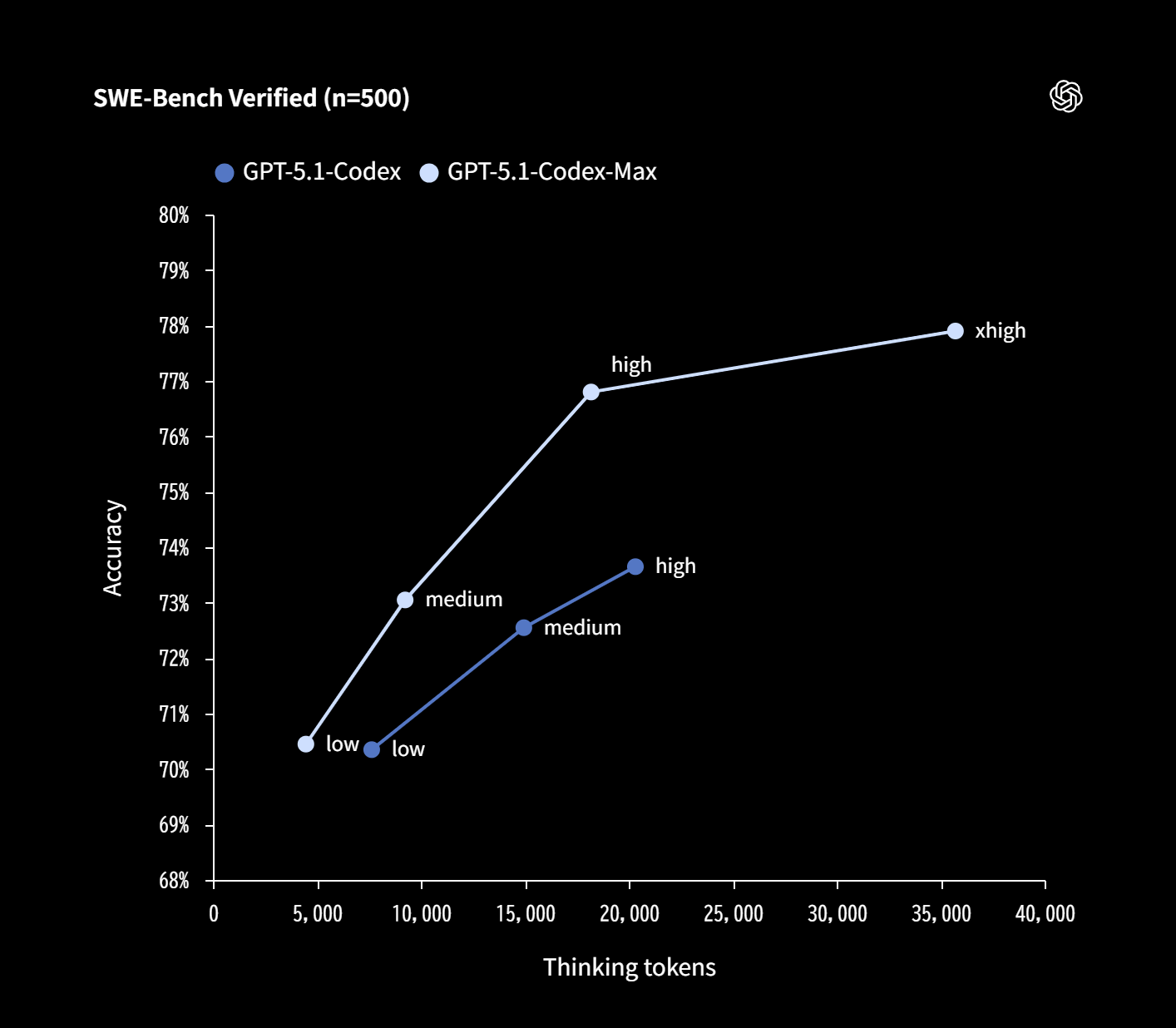

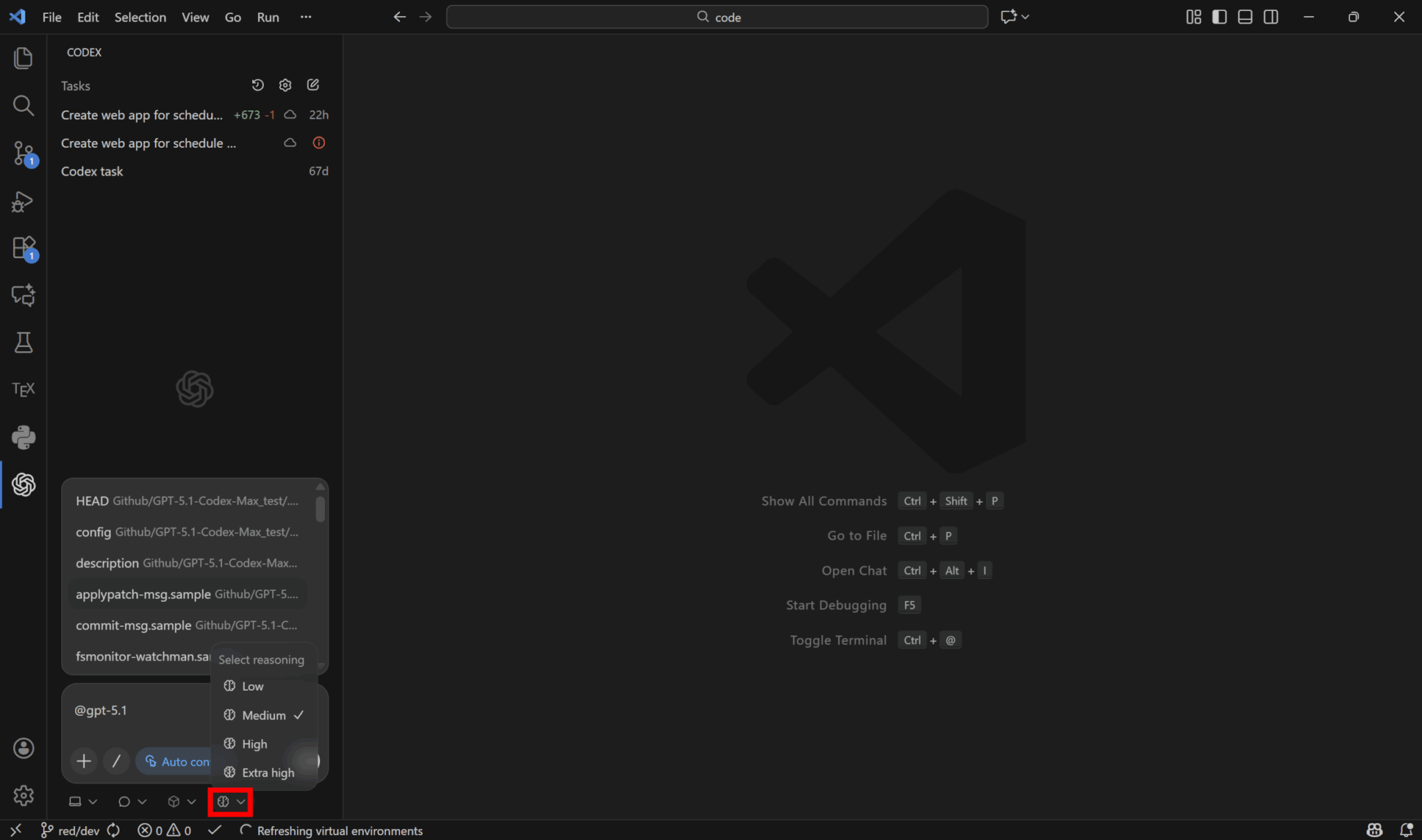

GPT-5.1-Codex-Maxでは、レイテンシの影響を受けないタスク向けに、より良い答えを得るためにさらに長い時間思考する新しいExtra High(xhigh)モードが導入されました。ただしほとんどのタスクでは、日常的な使用には引き続きmediumが推奨されています。

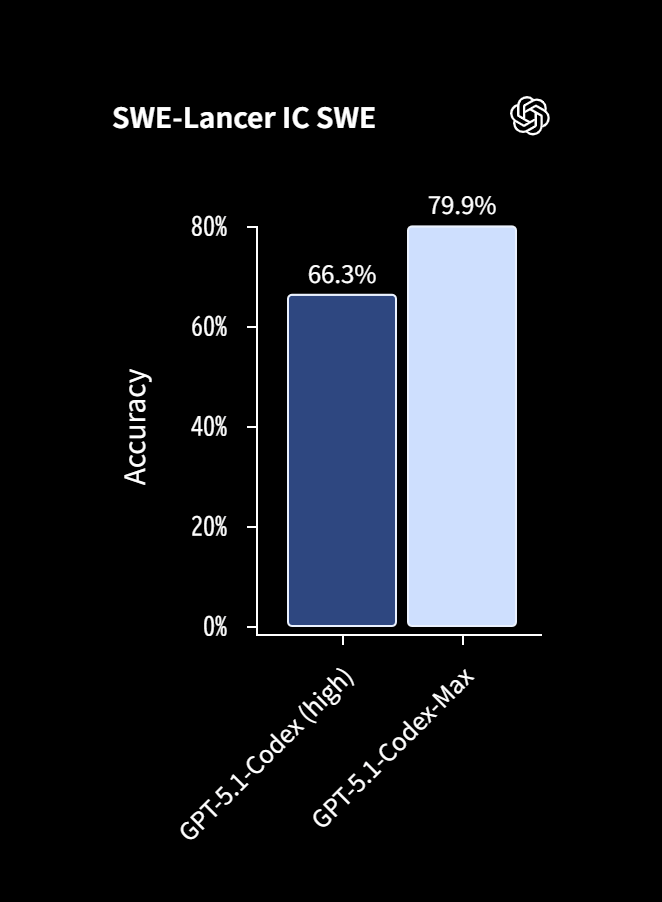

ベンチマークから見るコーディング性能

GPT-5.1-Codex-Maxは、実務レベルのソフトウェアエンジニアリング能力を測るSWE-bench Verifiedにおいて、より長い時間思考するExtra High推論モードで77.9%というOpenAIのCodex系モデルとしては過去最高水準の精度を達成しました。

これは前世代のGPT-5.1や競合するGemini 3 Proを上回るスコアであり、自律型エージェントとしての信頼性が飛躍的に向上したことを示しています。

特に、難易度の高いSWE-Lancerテスト(実サービスに近い環境でのコード修正ベンチマーク)でも約80%のスコアを記録しており、単なるコード生成にとどまらず、複雑なGitHubのissue解決やプルリクエスト作成を完遂する能力が証明されました。

これらの結果は、人間の介入を最小限に抑えた完全自律型の開発フローが実験段階から実用段階へと移行したことを意味していると言えるでしょう。

速度とトークン効率

本モデルは同等のタスクにおいて前世代より高い性能を発揮しながらも、約30%少ない思考トークンで動作するよう最適化されています。

On SWE-bench Verified, GPT‑5.1-Codex-Max with ‘medium’ reasoning effort achieves better performance than GPT‑5.1-Codex with the same reasoning effort, while using 30% fewer thinking tokens.

訳)SWE-bench Verified では、GPT‑5.1-Codex-Max は「medium」推論設定で、同じ推論設定の GPT‑5.1-Codex を上回る性能を発揮しつつ、思考トークンを30%削減しています。

出典:Building more with GPT-5.1-Codex-Max

この効率化の鍵となるのがネイティブ実装されたコンパクション技術であり、膨大な履歴を毎回フルサイズで再処理するのではなく、圧縮された文脈を引き継ぐことでAPIコストを劇的に削減します。

長時間稼働するエージェントにとってコンテキストの肥大化はコストに直結するため、このトークン削減効果は経済的な運用を可能にする決定的な要素となります。

結果として、数万行に及ぶ大規模なコード修正や24時間以上の連続稼働タスクであっても、予算を抑えながら実行可能なパフォーマンスを実現しました。

Windows対応・CLI連携などエージェント機能のポイント

Codex-Maxの大きな転換点、従来はLinuxやmacOS上でのタスクを主な対象としていましたが、本モデルではWindows環境およびPowerShell操作も訓練に含めることで、初めてネイティブに対応した点が大きな転換点でもあります。

これにより、Codex CLIを介してWindows上のローカル開発環境に直接アクセスし、ビルドエラーの解消や環境構築、テスト実行を自律的に行えるようになりました。

PowerShell特有のコマンド体系やファイルパスの扱いをモデルが熟知しているため、WSLを経由せずともスムーズにタスクを完遂できます。

この高いCLI連携能力は、セキュアなローカルサンドボックス内での自律操作を現実的なものにし、企業利用の多いWindowsベースの開発現場に即した実用性を提供します。

GPT-5.1-Codex-Maxの使い方:ChatGPT・CLI・IDE・APIでの利用パターン

次に、GPT-5.1-Codex-Maxの使い方を解説します。GPT-5.1-Codex-MaxはChatGPTのCodex CloudやCLI、IDE拡張で利用可能であり、近日中にAPIでの提供も予定されています。

GPT‑5.1-Codex-Max is available in Codex today for use in the CLI, IDE extension, cloud, and code review, and API access is coming soon.

訳)GPT‑5.1-Codex-Max は本日より CLI、IDE 拡張機能、クラウド、コードレビューで利用可能になっており、API でも近日提供予定です。

出典:Building more with GPT-5.1-Codex-Max

ChatGPTのCodexからGPT-5.1-Codex-Maxを使う手順

ChatGPTのサイドバーからCodex Cloudを起動することで、GPT-5.1-Codex-Maxを使用することができます。

使う手順は以下の通りです。

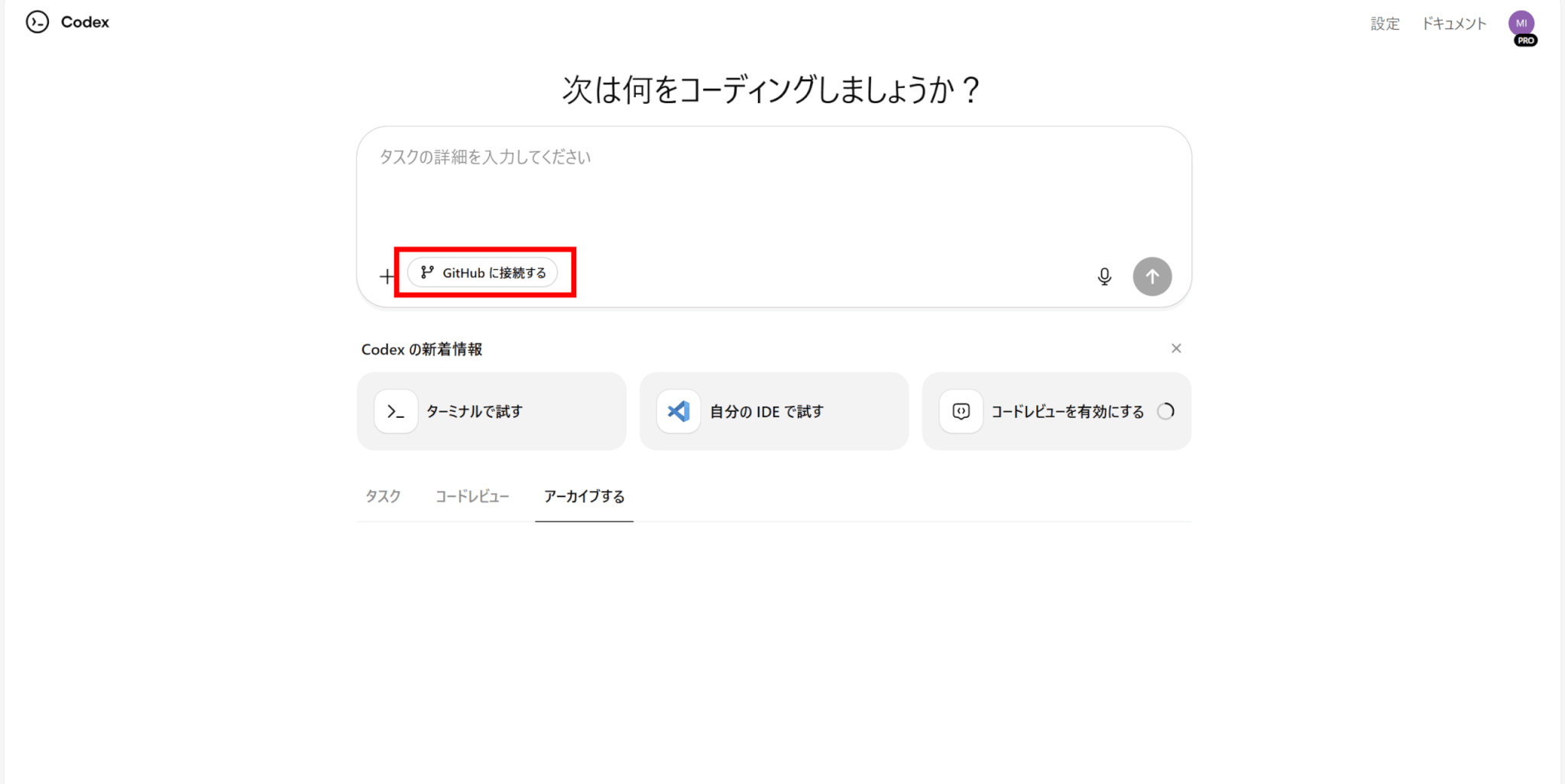

次にCodexをGitHubアカウントに接続します。

「GitHubに接続する」をクリックしてください。

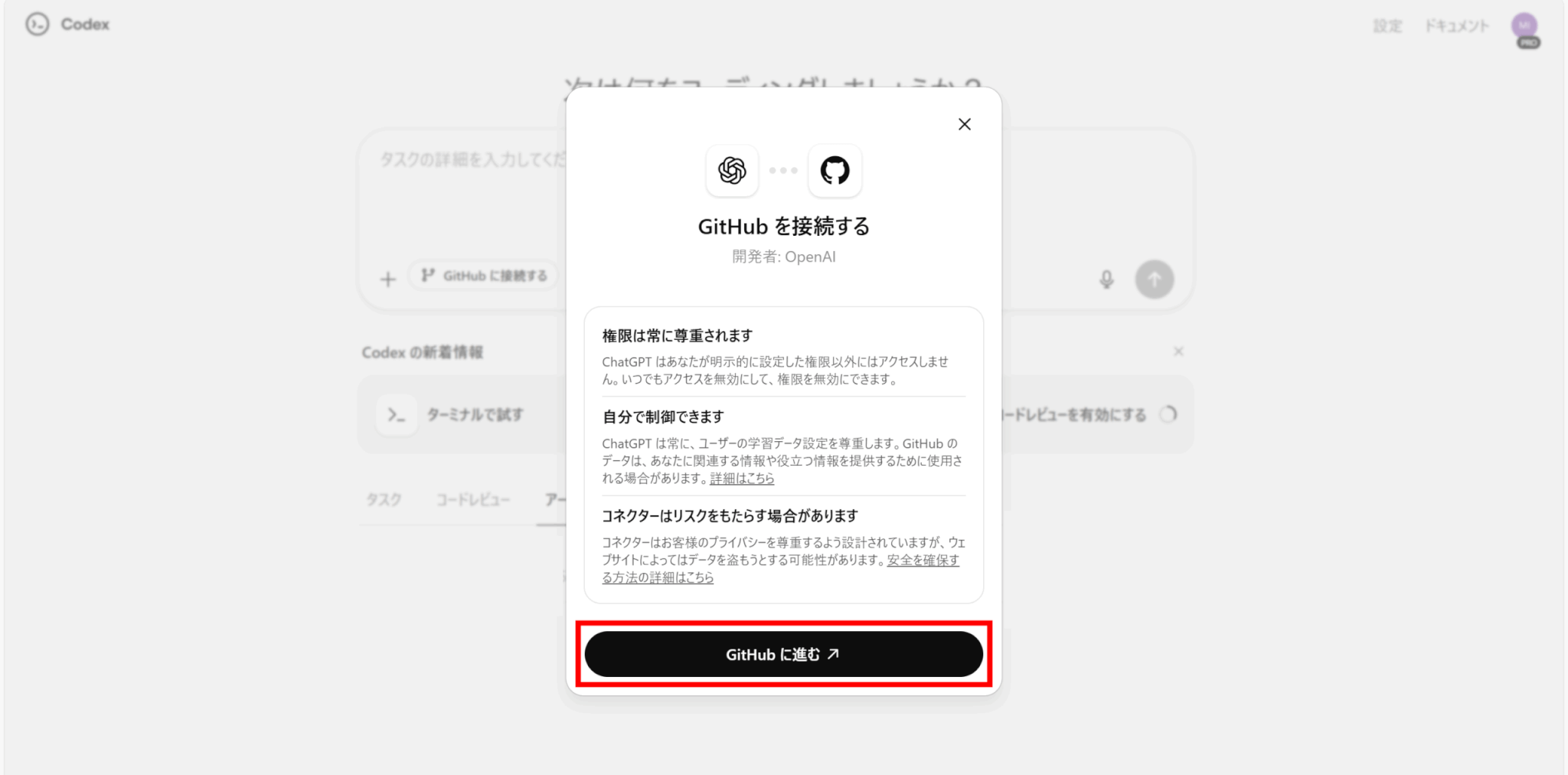

「GitHubに進む」をクリックします。

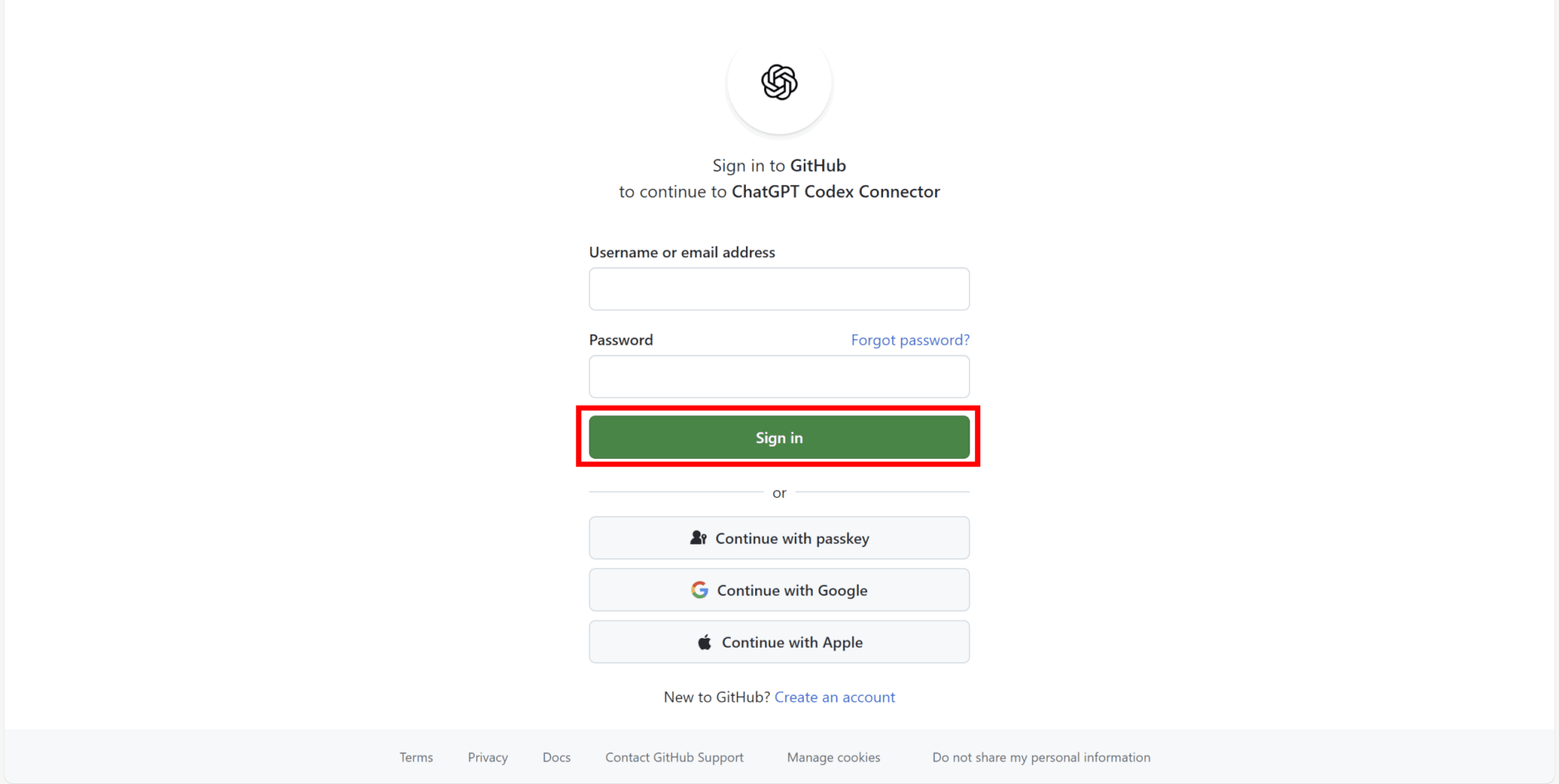

アカウント情報を入力してサインインしましょう。

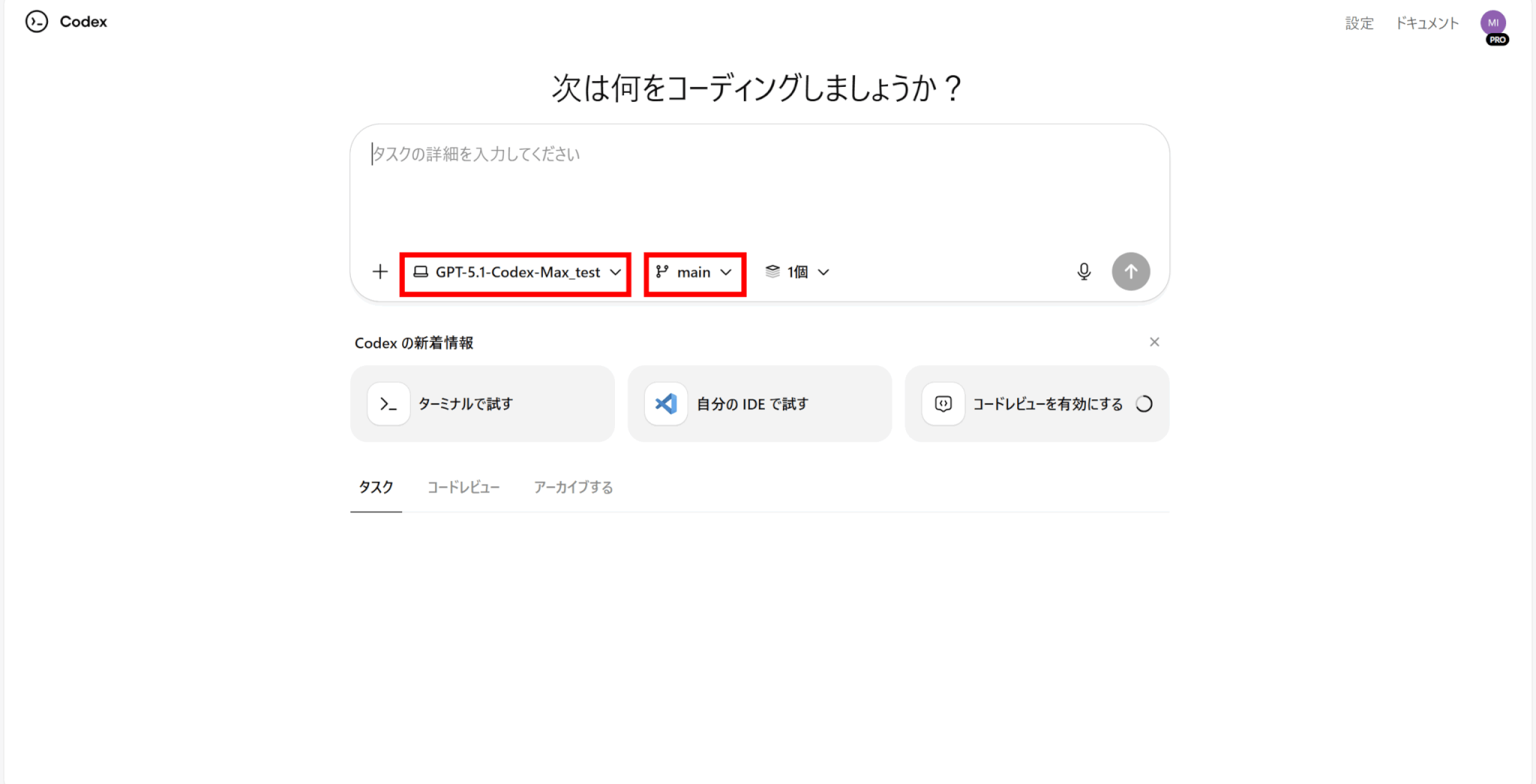

GitHubに接続後、プルダウンからCodexを使用するリポジトリとブランチを選択します。

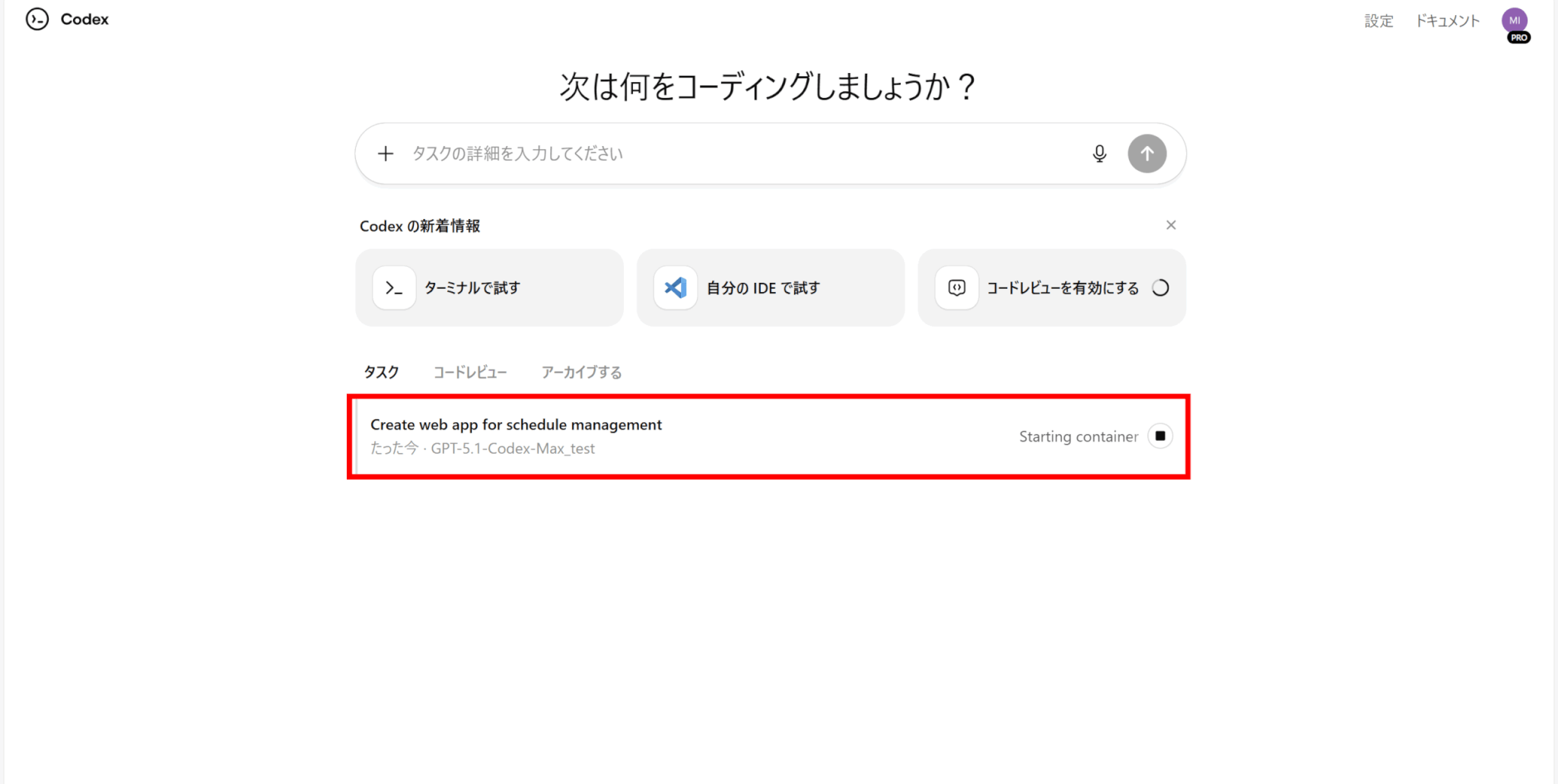

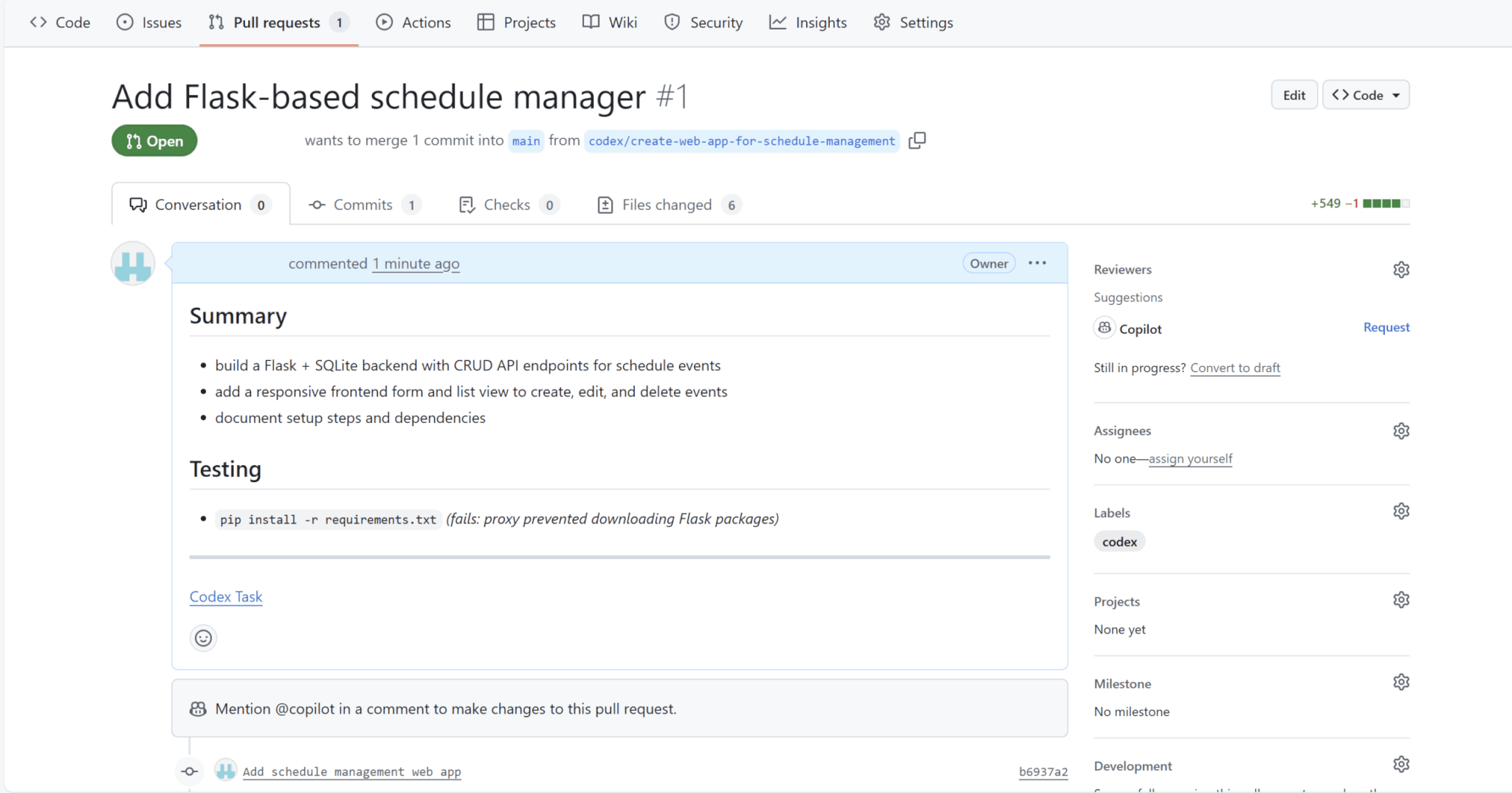

AIに実行させたいタスクの内容をプロンプトとして入力し、送信します。今回はスケジュール管理アプリを1から作成してもらいました。

プロンプト「スケジュール管理用のWebアプリを作成してください。」

実行開始後は、下に表示される各タスクから状況を確認することができます。

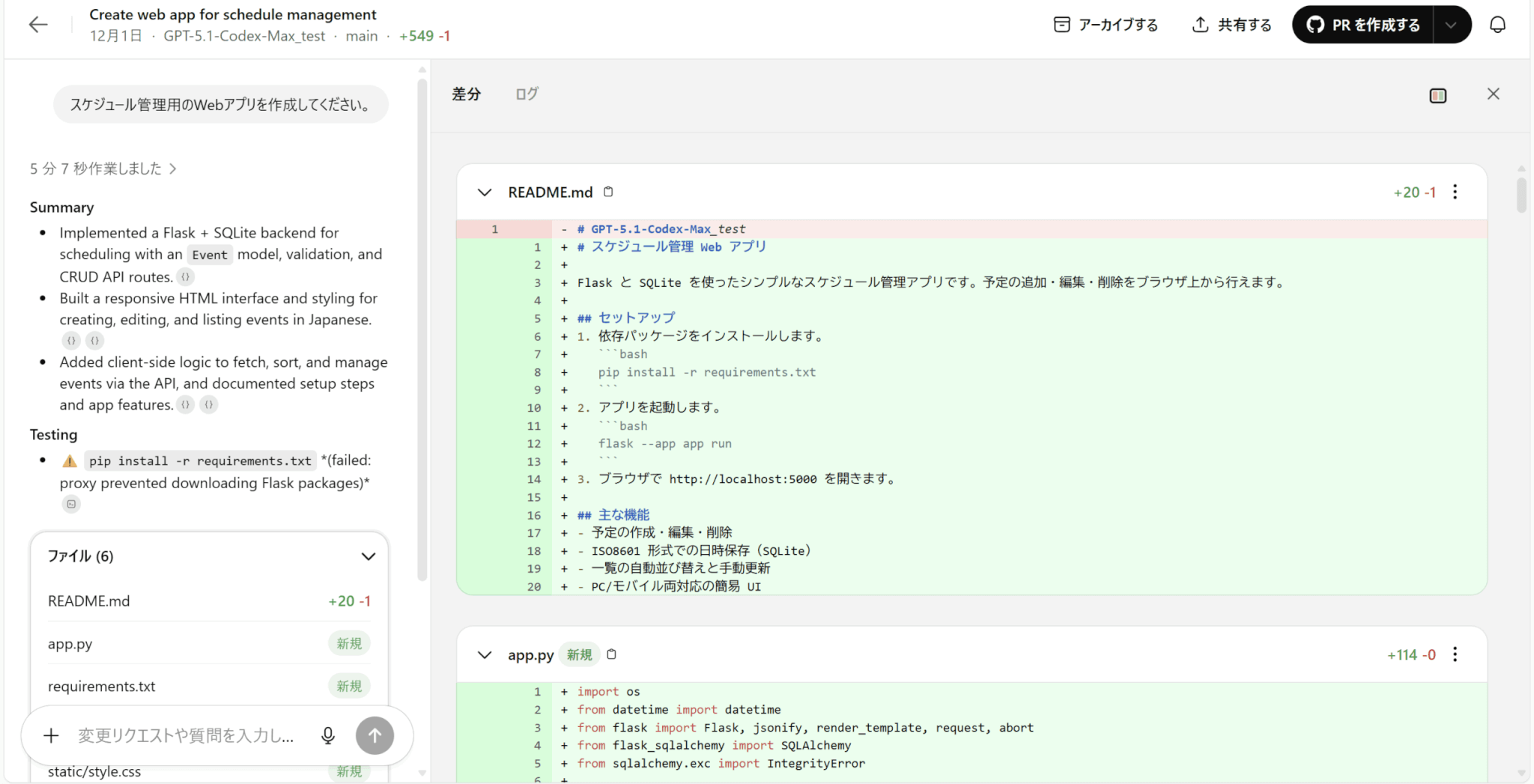

しばらくすると、実行結果が出力されます。結果には、ファイルの差分と実行ログがあります。

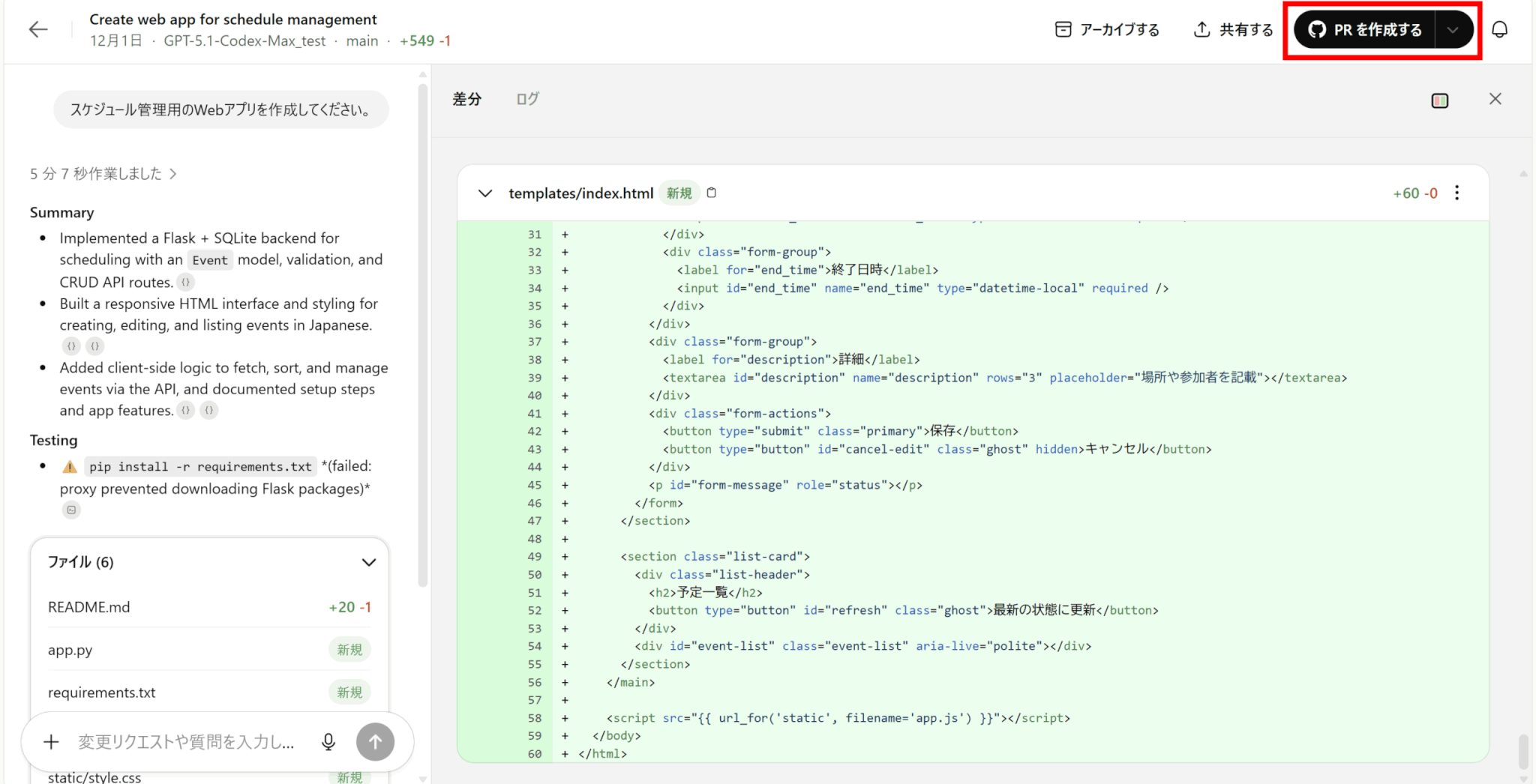

内容に問題がないかどうか、差分とログを見ながら確認しましょう。

実行結果に問題がなければ、右上の「PRを作成する」からプルリクエストを作成しましょう。

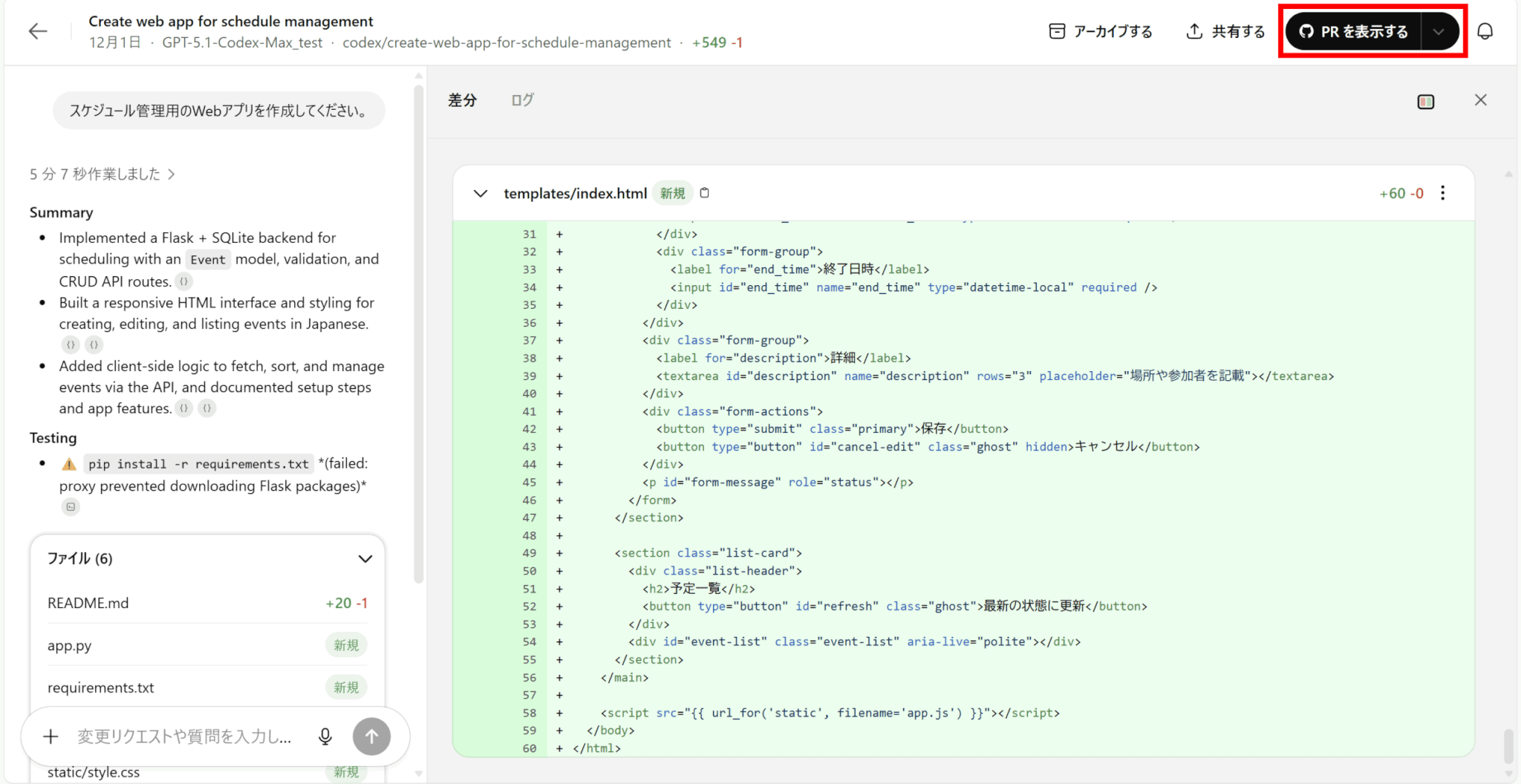

作成が完了すると、右上の表示が「PRを表示する」に変わります。

これをクリックすると、直接GitHubのプルリクエスト画面に遷移します。

あとは通常の手順と同様に、コードレビューをしてマージしましょう。

Codex CLIでの基本的な使い方

続いて、Codex CLIでの使い方をご説明します。

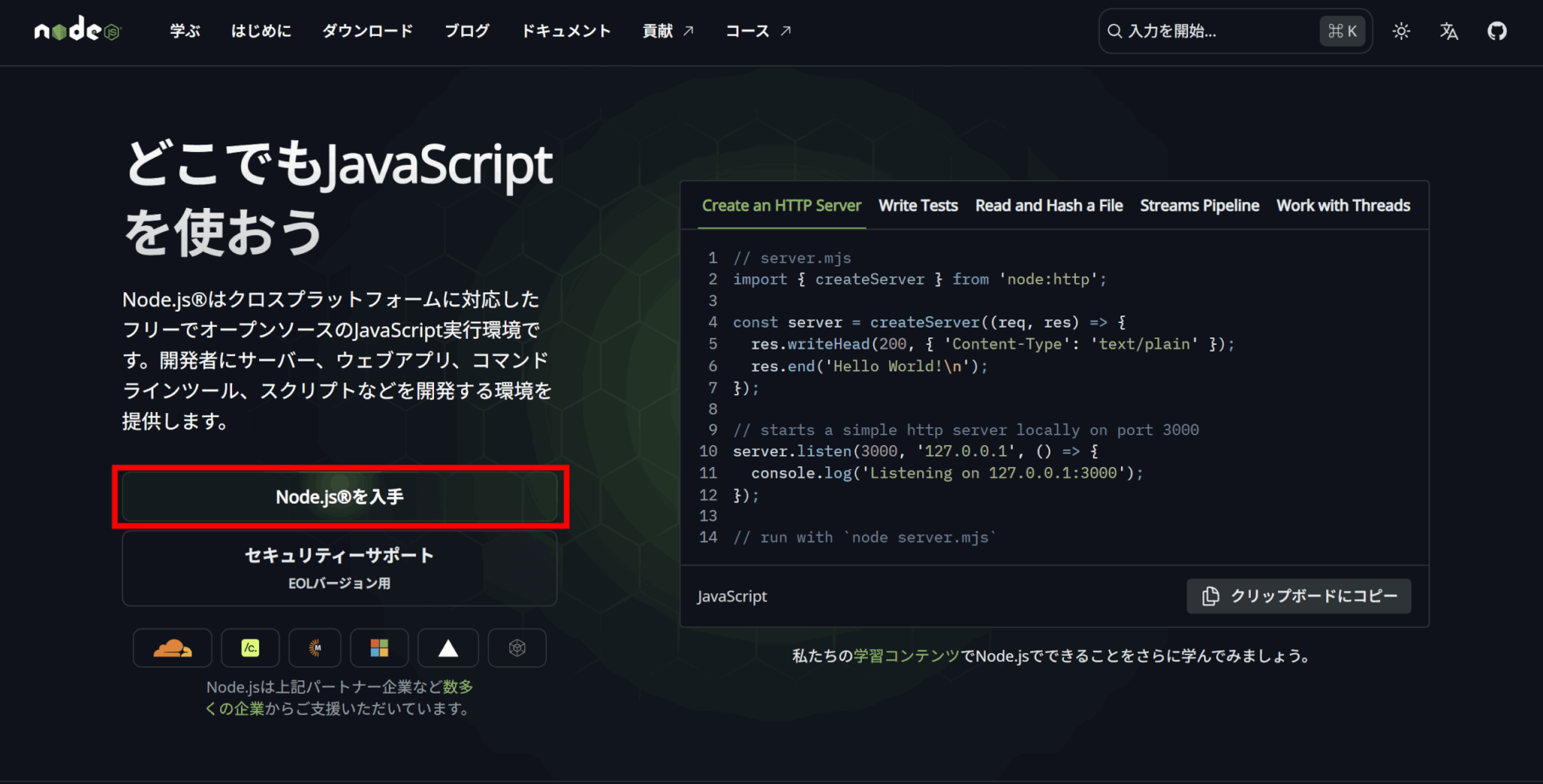

Codex CLIはnpmコマンドでのインストールが案内されているため、Node.jsが入っていない方はまずこちらをインストールしましょう。

公式サイトにアクセスし、「Node.jsを入手」をクリックしてください。

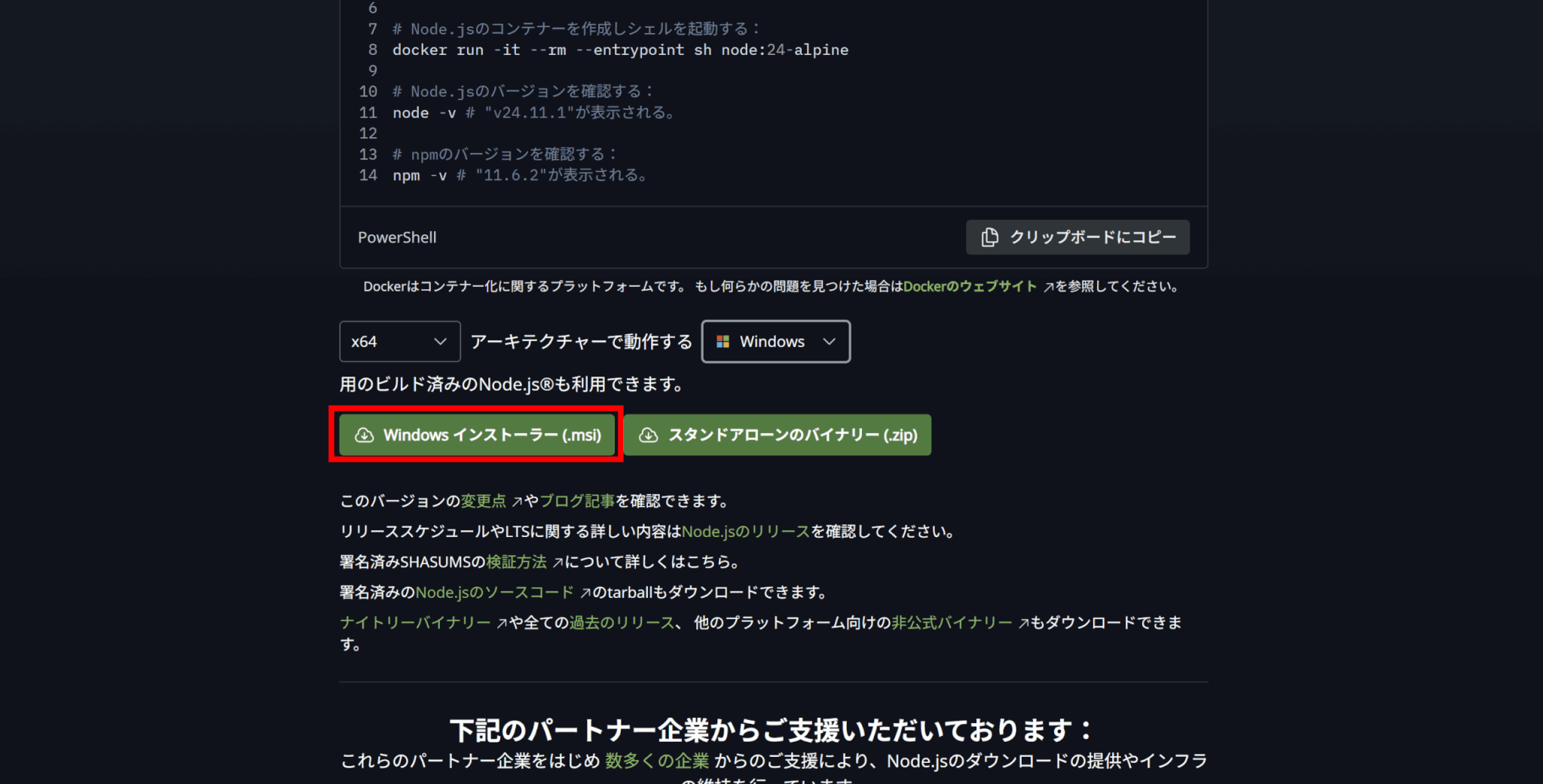

コマンドを使ってインストールする場合、自分の環境に合わせて各プルダウンを選択してください。ただし、npmは忘れずインストールするようにしてください。

または下にインストーラーもあるため、こちらをダウンロードしてインストールすることもできます。

ターミナルで以下のコマンドを実行してCodex CLIをインストールします。

npm i -g @openai/codexインストールができたら、対象のリポジトリ内で以下のコマンドを実行し、Codexを起動します。

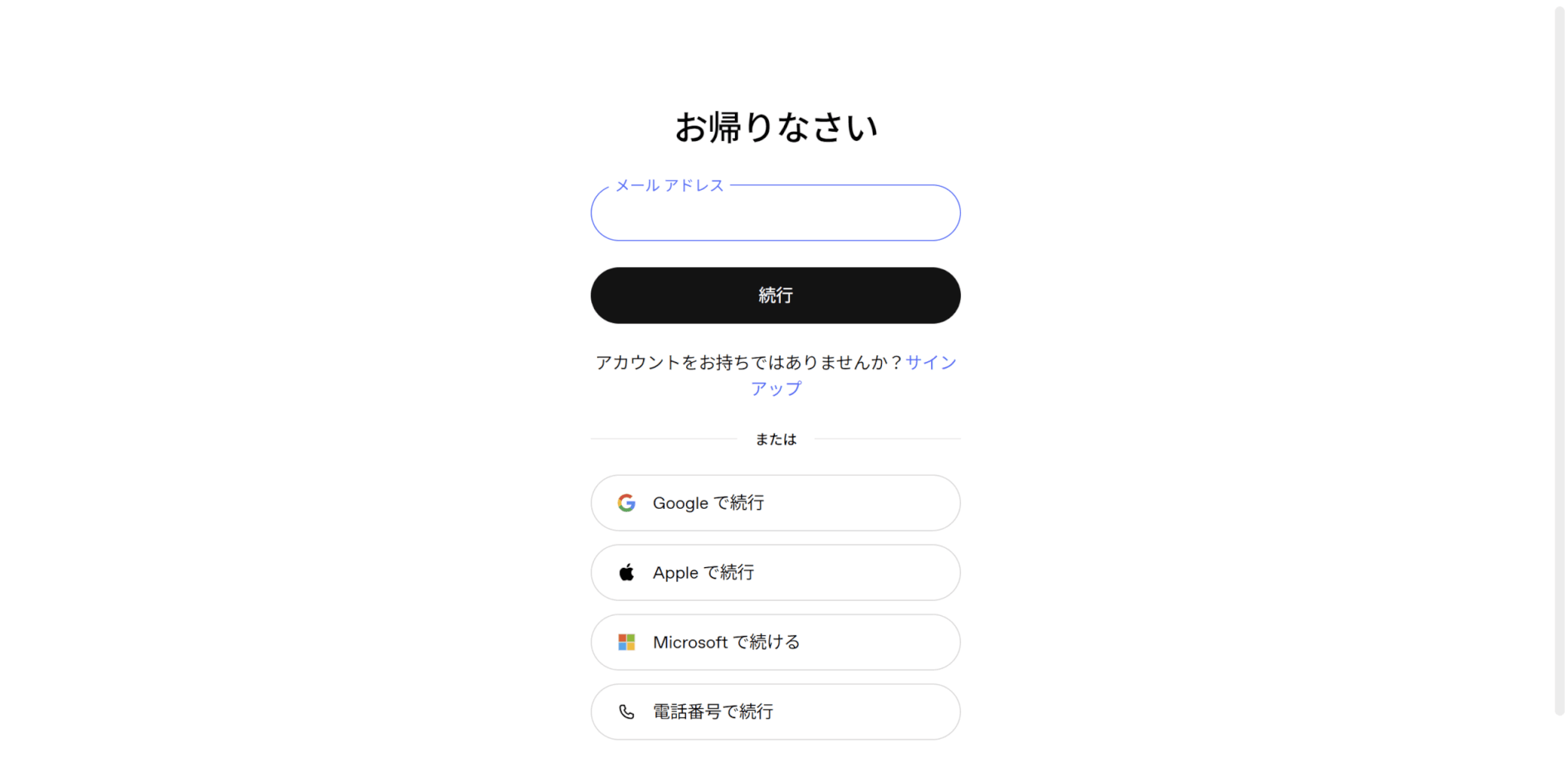

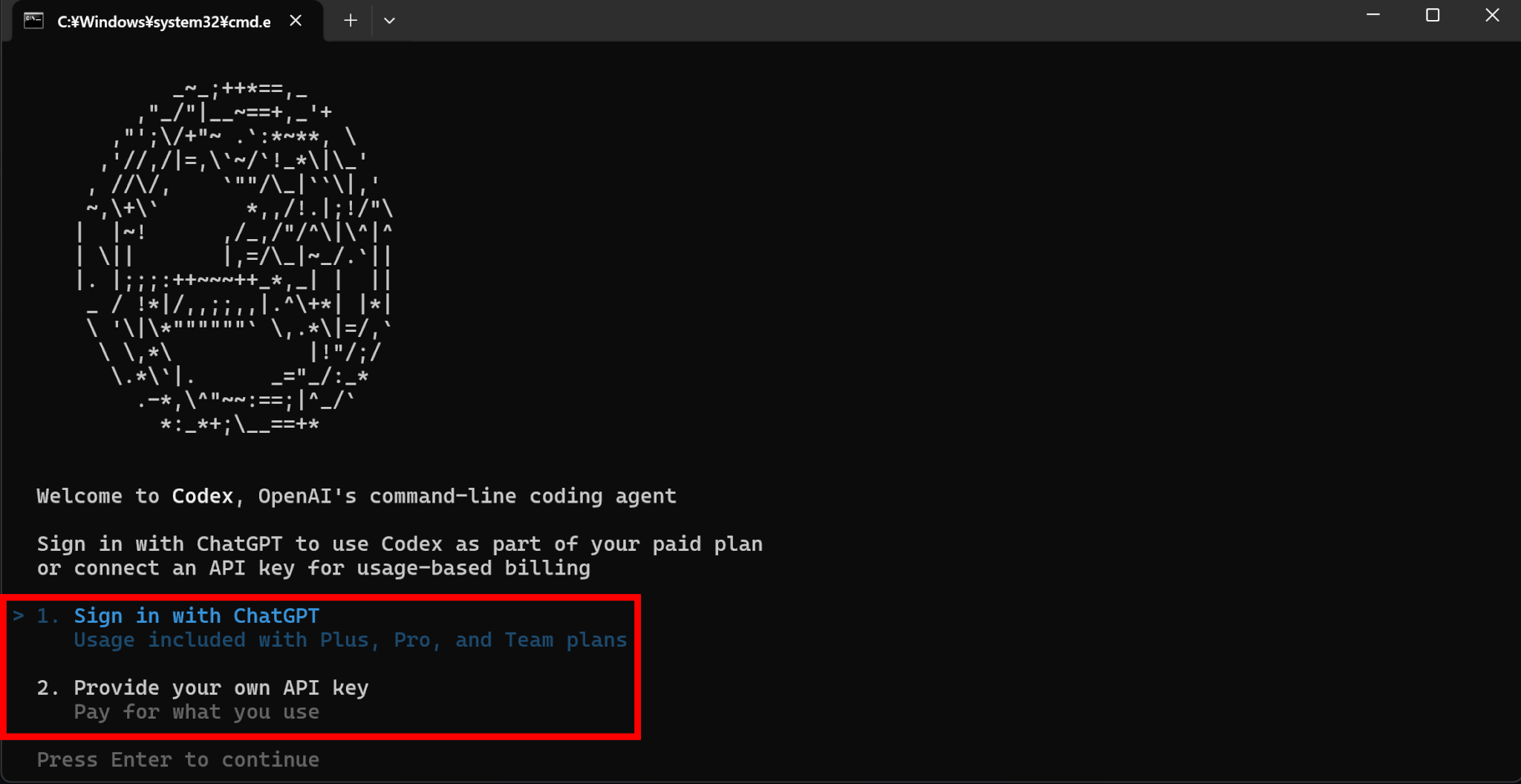

codex初めて起動する際は、ChatGPTアカウントへのログインが求められます。

アカウント情報を入力してログインすると、Codexが使えるようになります。

または、ログイン画面からターミナルに戻ってEscキーを押すとChatGPTへのログインか、APIキーの使用を選べます。

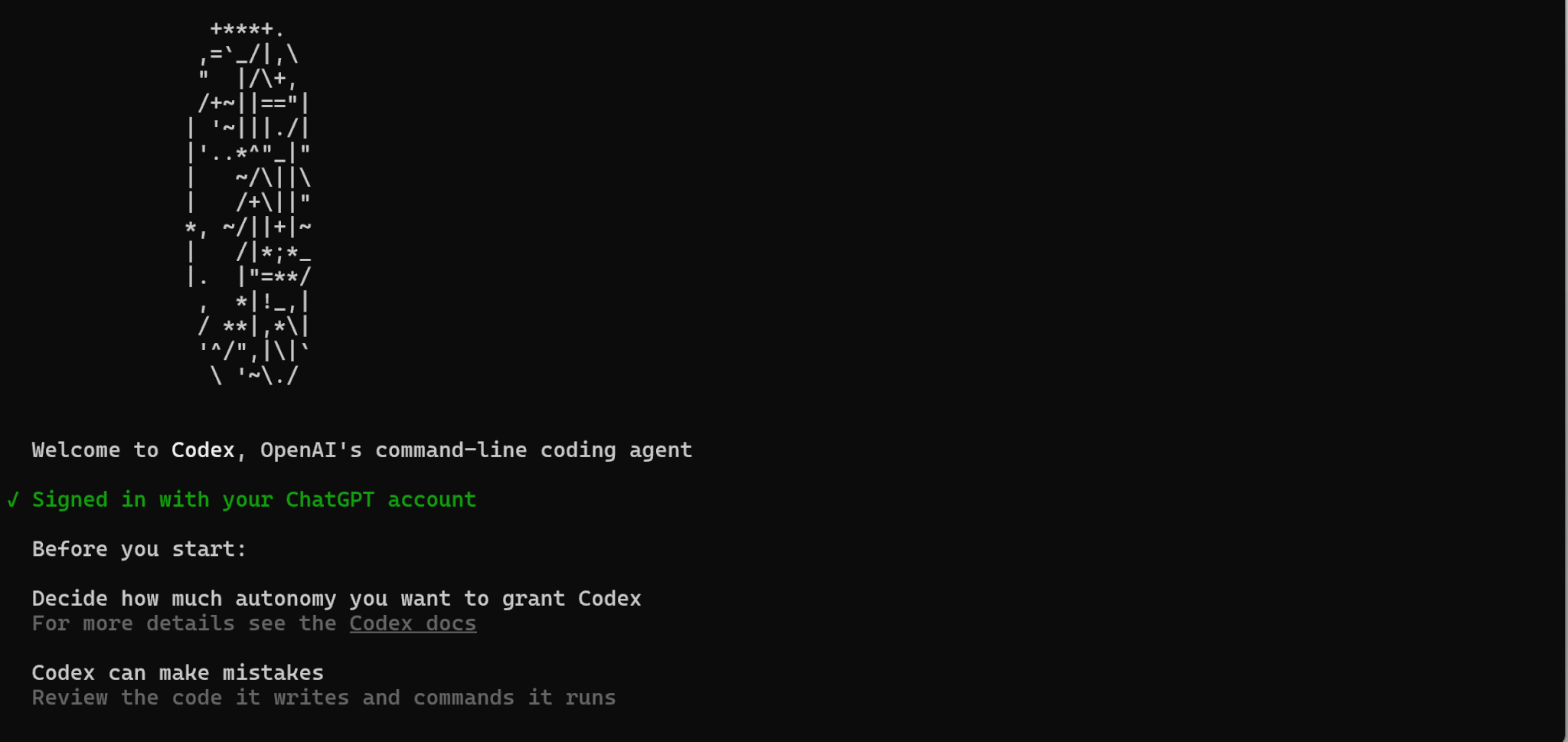

ログインができたら、ターミナルに戻りましょう。注意事項が表示されているので、確認してEnterキーを押します。

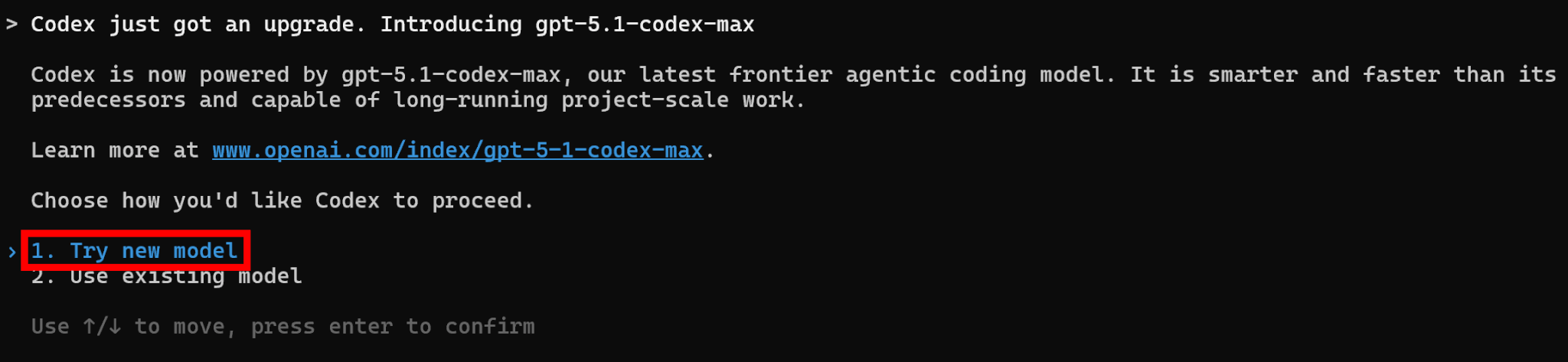

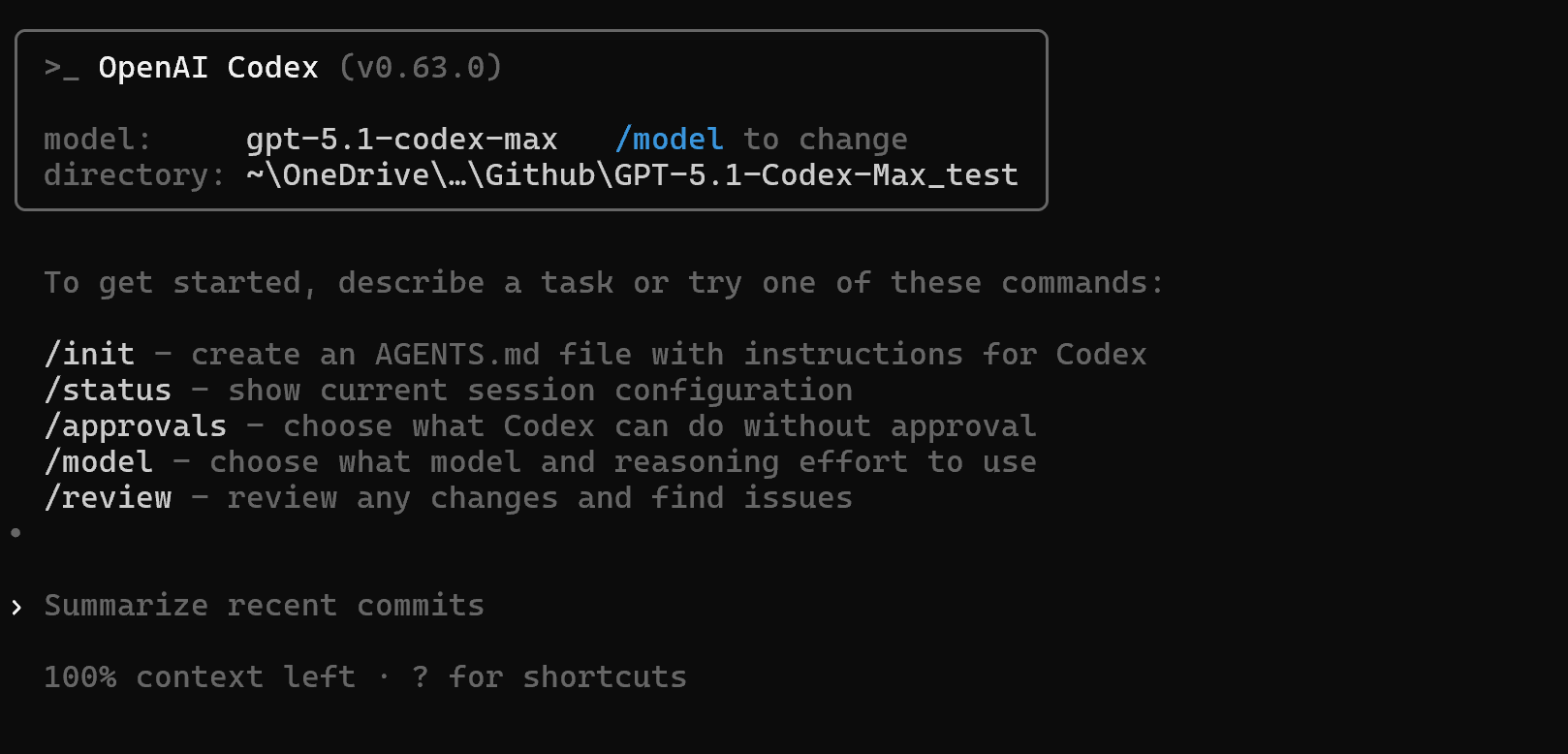

2025年12月現在は、初めて起動するとGPT-5.1-Codex-Maxを選択するかどうか選べます。「Try new model」を選択することで、GPT-5.1-Codex-Maxを使用できます。

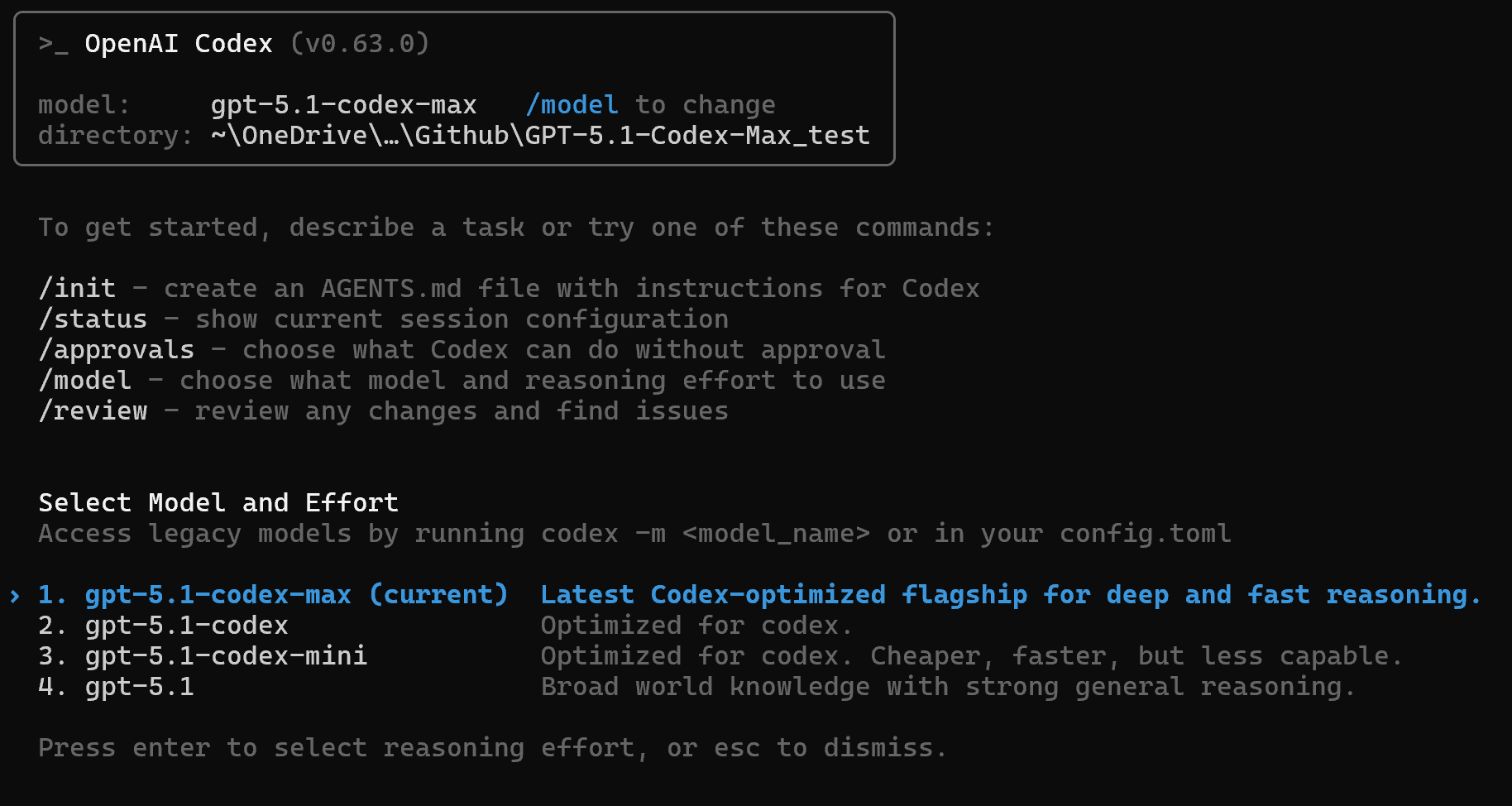

もしモデルを変更したい場合は、/modelと入力することで変更可能です。

セットアップが完了したら、ターミナル上でプロンプトを送信することで、リポジトリ内でタスクを実行させることができます。

VS CodeなどIDE拡張でのGPT-5.1-Codex-Max使用法

VS Codeやその派生版であるCursor、Windsurfなどでは、拡張機能としてCodexをインストールでき、GPT-5.1-Codex-Maxを使用可能です。

IDE拡張での使用方法は以下の通りです。なお、ここではVS Codeを用いて解説します。

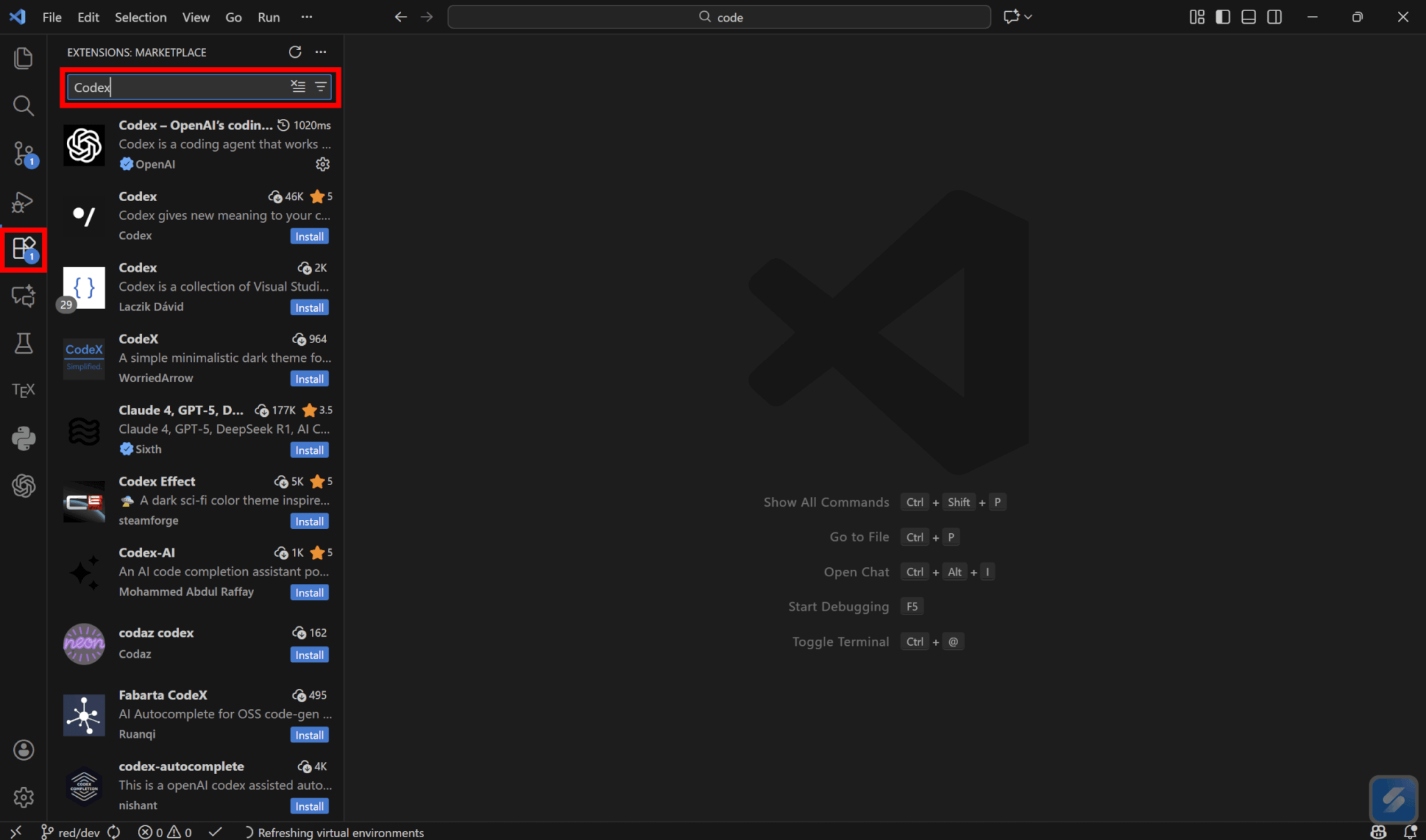

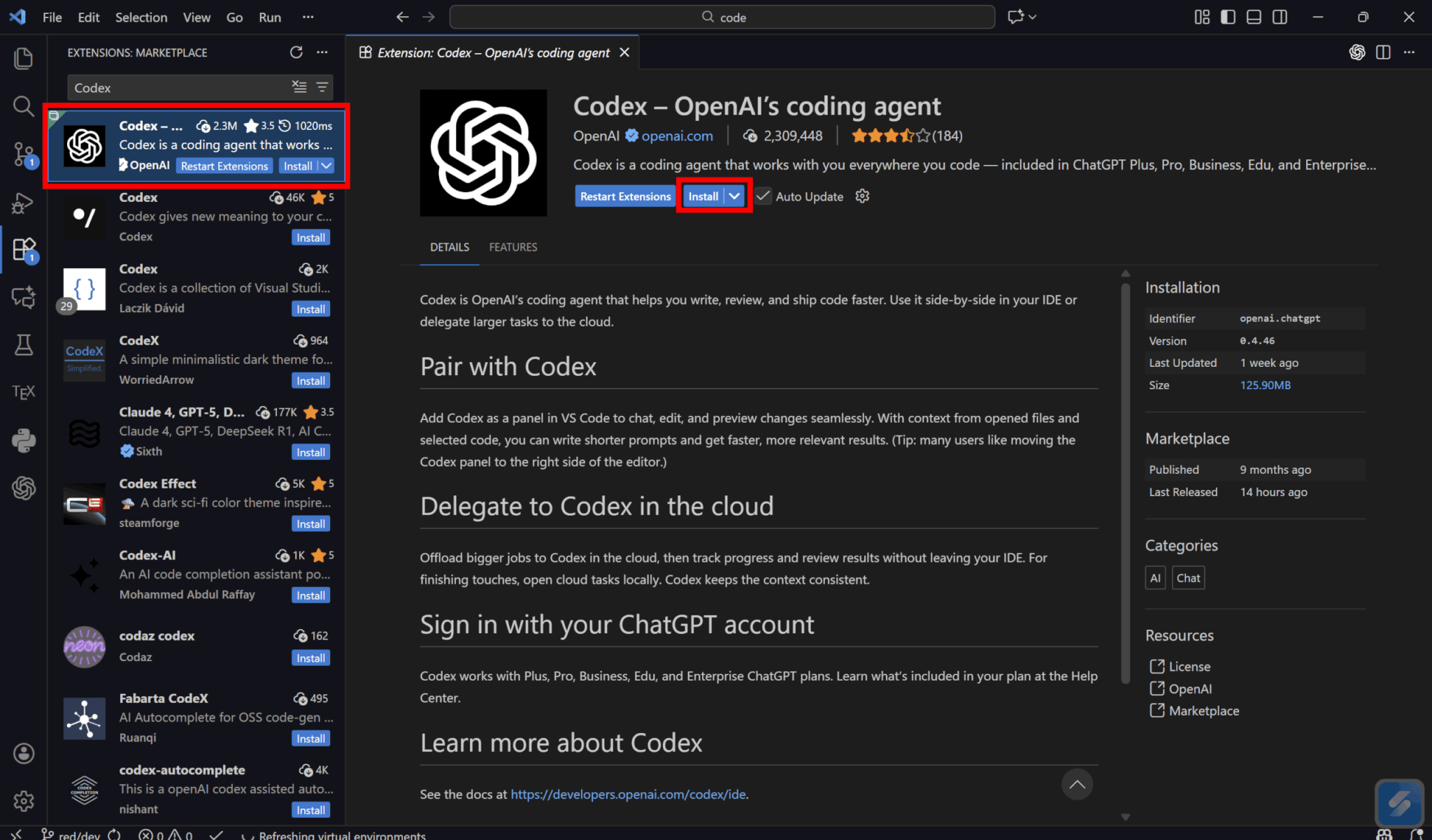

拡張機能タブに移動し、検索バーに「Codex」と入力します。

表示されたCodexを選択し、「Install」をクリックします。

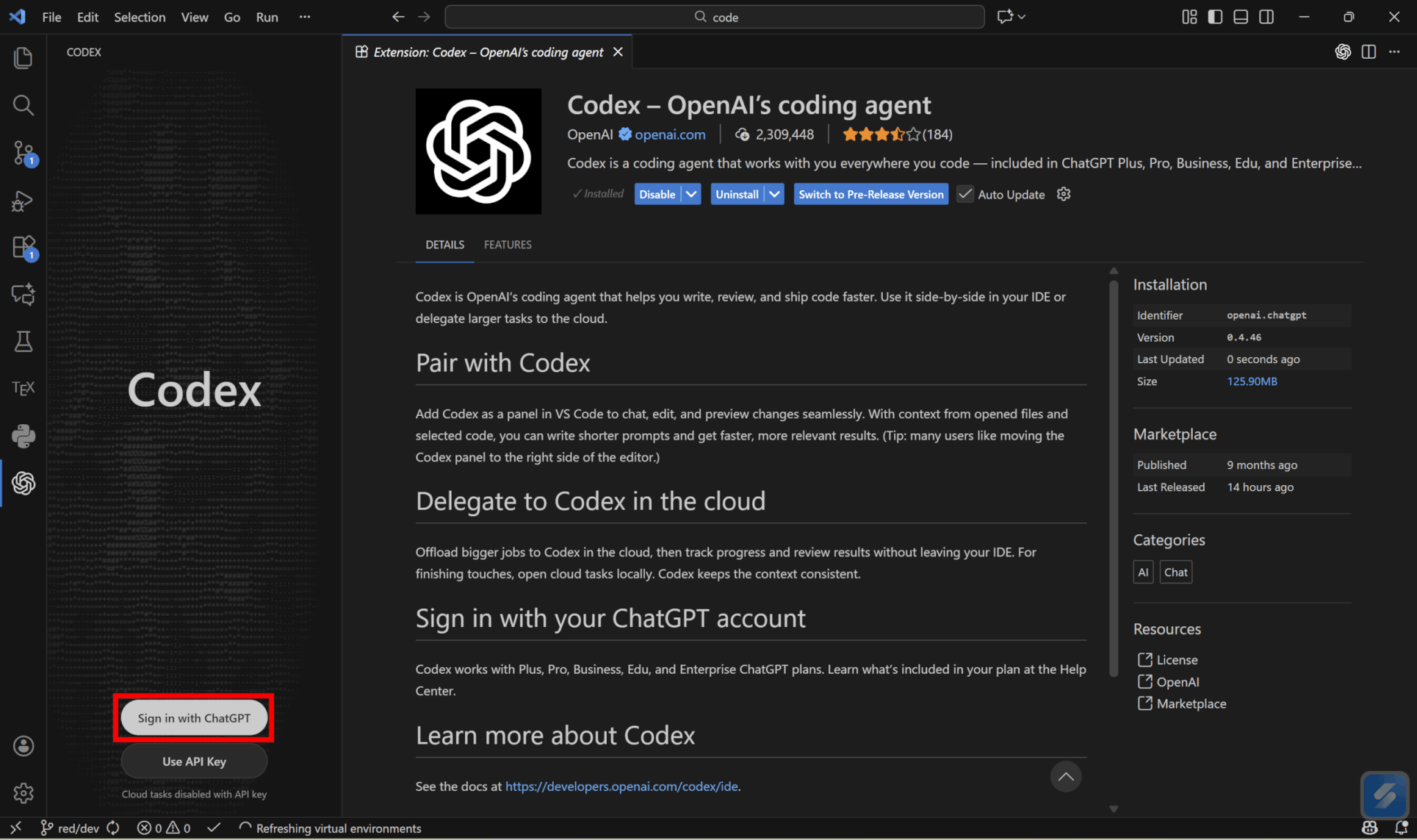

画面左のCodexタブに移動し、「Sign in with ChatGPT」をクリックします。なお、APIキーを使用する場合は「Use API Key」をクリックしてください。

Webのログインページに遷移するので、アカウント情報を入力してログインします。ログインが完了したら、VS Codeに戻りましょう。

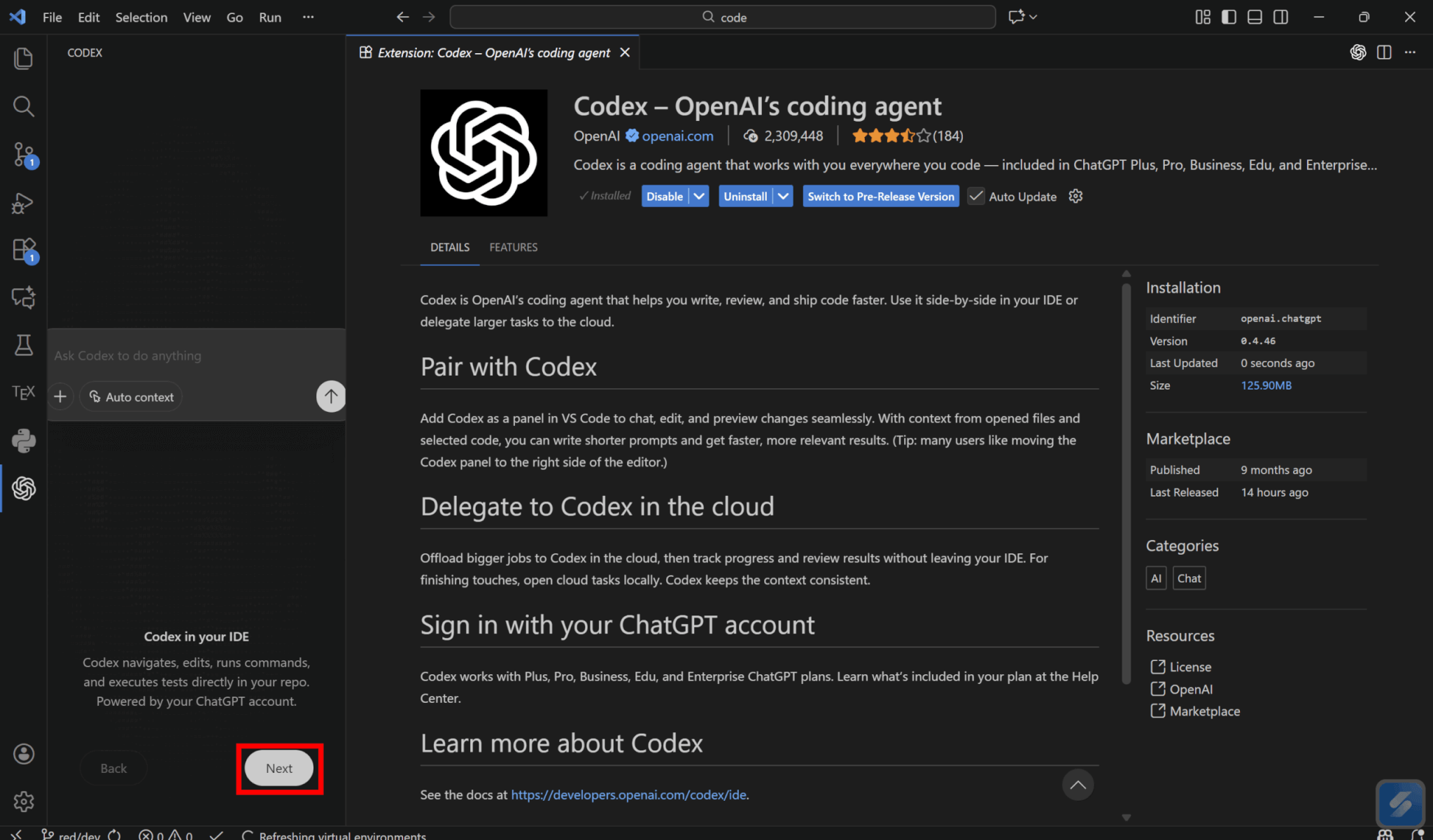

戻るとCodexが使用できるようになっているので、「Next」をクリックします。

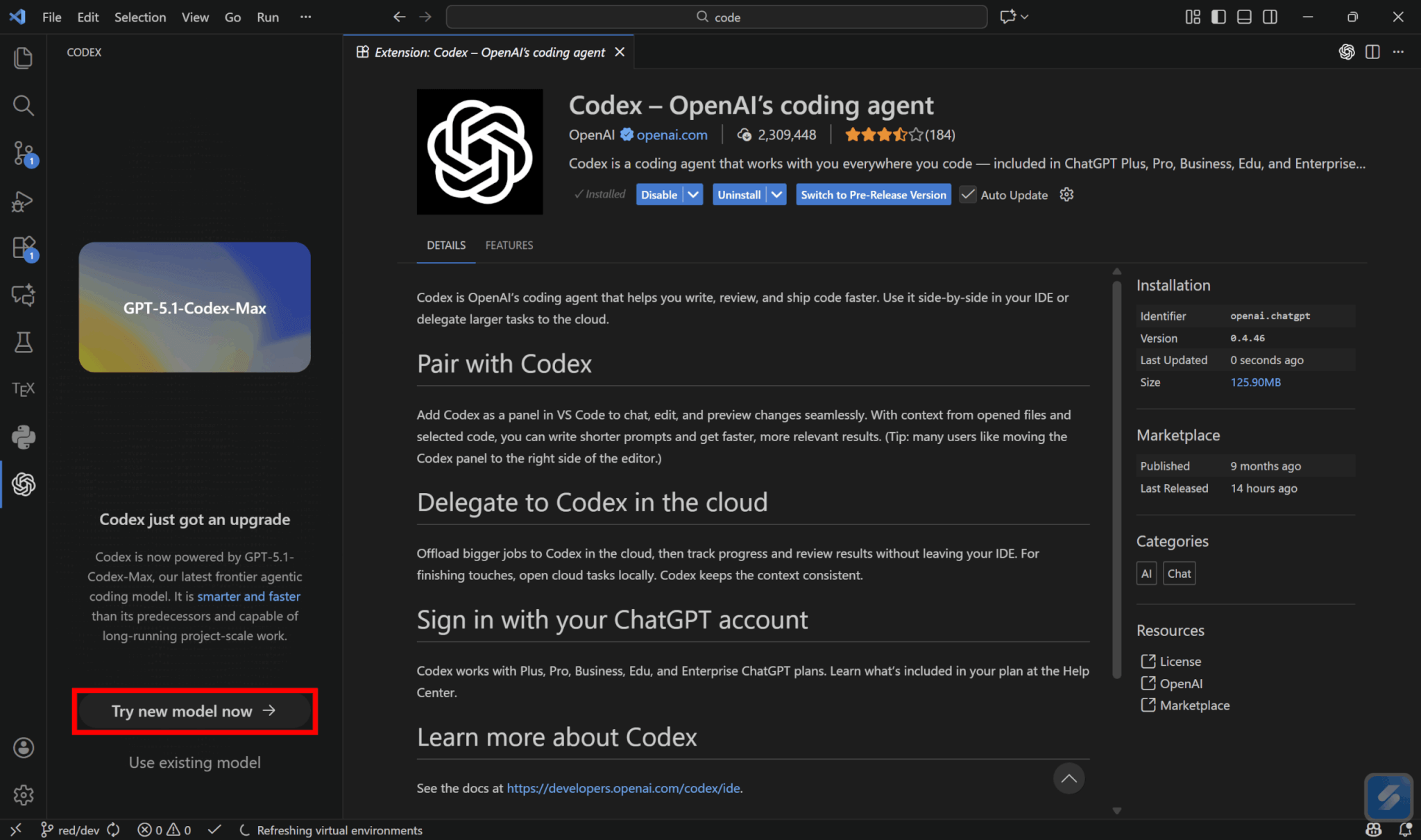

CLIと同様GPT-5.1-Codex-Maxの使用を勧められるので、「Try new model now」をクリックすると利用できます。

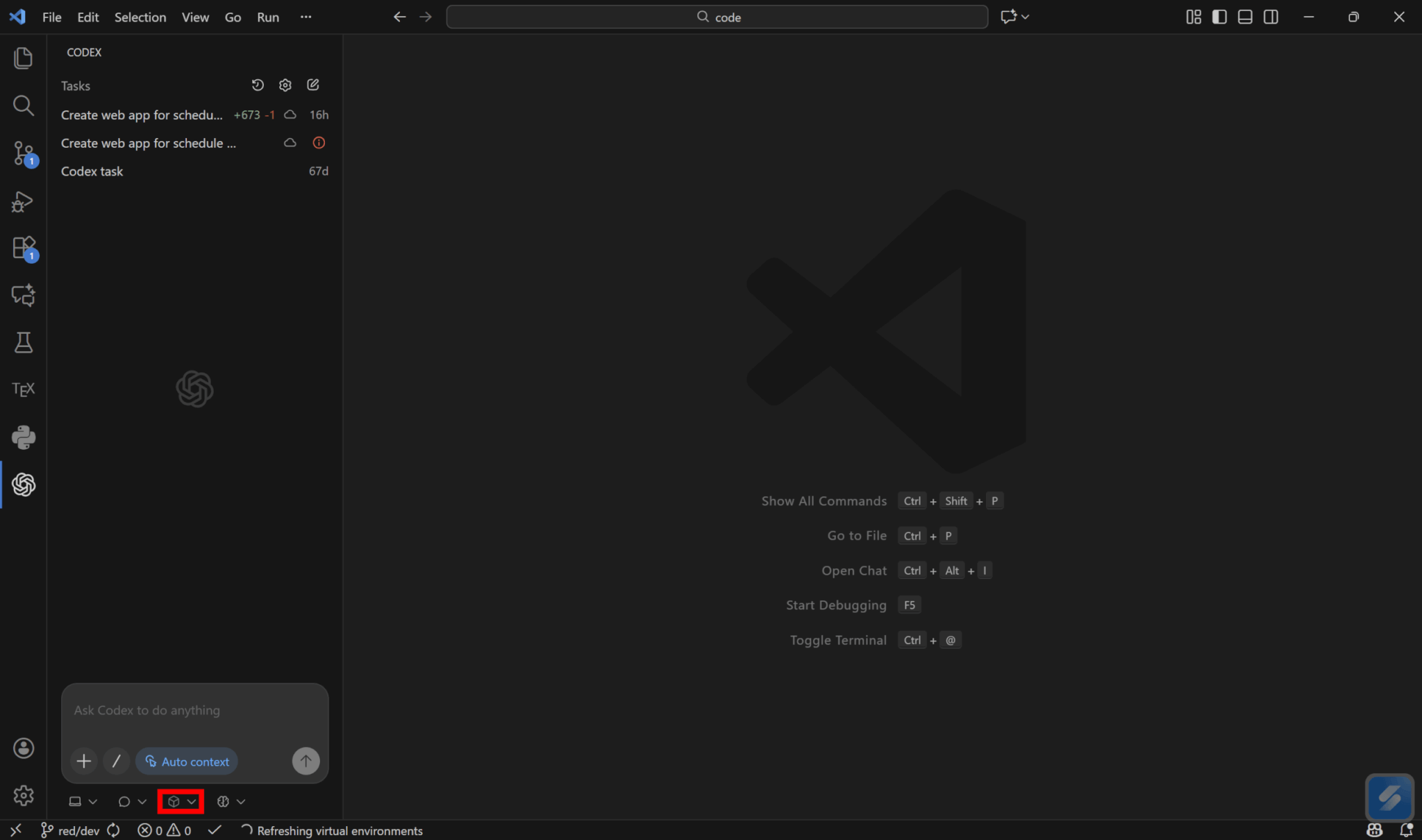

なお、モデルは左下の「Choose model and reasoning」をクリックすることで選べます。

IDE拡張のCodexでは、@でファイルをメンションすることで特定のファイルに対して操作を行えます。

基本的にはCloudやCLIと同様に、メッセージウィンドウにプロンプトを入力して送信することで、AIが自律的にタスクを実行してくれます。

APIでの使用について

GPT-5.1-Codex-Maxは、近日中にAPIでの提供が予定されていますが、2025年12月1日現在はまだ一般向けAPIでの利用はできません。

For developers using Codex CLI via API key, we plan to make GPT‑5.1-Codex-Max available in the API soon.

訳)API キー経由で Codex CLI を利用している開発者向けには、近日中に API でも GPT‑5.1-Codex-Max を提供する予定です。

出典:Building more with GPT-5.1-Codex-Max

提供が開始された場合、GPT-5.1-Codexと同じくResponses APIのみで利用できる可能性が高いと考えられます。

GPT-5.1-Codex-Maxの利用料金とプランの比較

続いて、GPT-5.1-Codex-Maxの利用にかかる料金について解説します。

ChatGPTの各プランの料金と提供状況

GPT-5.1-Codex-Maxは、ChatGPTの各有料プランで利用可能です。

それぞれのプランでの提供状況は以下の通りです。

| 項目 | Plus | Pro | Business | Enterprise |

|---|---|---|---|---|

| 月額料金 | $20 | $200 | $30/ユーザー (年次請求:$25/ユーザー) | 要問い合わせ |

| GPT-5.1-Codex-Max | ||||

| ローカルメッセージ | 45〜225/5時間 | 300〜1,500/5時間 | 柔軟に設定 | 柔軟に設定 |

| クラウドタスク | 10〜60/5時間 | 50〜400/5時間 | 柔軟に設定 | 柔軟に設定 |

どの有料プランでもGPT-5.1-Codex-Maxを利用できますが、5時間あたりの使用制限が異なります。

Plusプランは5時間あたり、ローカルメッセージは45〜225件、クラウドタスクは10〜60件の実行が可能です。一方Proプランでは、ローカルメッセージが300〜1,500件、クラウドタスクが50〜400件と制限が引き上げられます。

また、組織向けプランのBusinessやEnterpriseでは、基本の上限はPlus相当ですが、柔軟価格プランを契約することで、クレジットを追加購入して実質的に使用制限を引き上げることができます。。

個人利用であれば、まずはPlusプランで使い、制限によく引っかかるようであればProプランの契約を検討しましょう。

APIのトークン単価

現在GPT-5.1-Codex-MaxはAPIでの提供が開始されていないため、正確なAPI料金は分かっていません。

ただし、参考として前のモデルであるGPT-5.1-Codexは、100万トークンあたり入力が$1.25、キャッシュされた入力が$0.13、出力が$10.00となっていました。

2つのモデルはChatGPTの各プランでの使用制限が近いため、API料金もこれに近い体系になることが予想されます。

最新の情報については公式のドキュメントをご確認ください。

reasoning_effortやバッチ処理などでコストを抑える考え方

今後APIを使ってGPT-5.1-Codex-Maxの利用を考える場合、エージェントの運用コストを最適化するためには、タスクの難易度に応じて推論深度を調整するreasoning_effortパラメータの活用を推奨します。

例えば、単純なバグ修正であれば「low」や「medium」に設定し、アーキテクチャ設計などの複雑なタスクのみ「high」や「xhigh」を選択することで、高価な思考トークンの消費を抑制できます。

なお、IDE拡張であれば左下の「Select reasoning effort」から選択可能です。

即時性が求められない大規模なリファクタリングやテスト生成タスクには、24時間以内に結果を返すBatch APIを利用することで、トークン単価を正規料金の50%に抑えることが可能です。

このように、モデルの自律性に任せきりにするのではなく、エンジニアが適切な制約と実行タイミングを管理することが、経済的な運用の鍵となります。

GPT-5.1-Codex-Maxのユースケース・活用シナリオ

次に、GPT-5.1-Codex-Maxの具体的なユースケースや活用シナリオをご紹介します。

大規模リファクタリングやフレームワーク移行への活用

Codex-Maxは、ファイル数が数百から数千に及ぶ大規模なプロジェクト構造の変更において最大の費用対効果を発揮します。

例えば、ReactからNext.jsへの移行や、Java 8から21へのバージョンアップ、モノリスからマイクロサービスへの切り出しといった破壊的変更を伴うタスクにおいて、モデルはコンパクション技術を用いてプロジェクト全体の依存関係を記憶し続けます。

人間が手作業で行えば数週間を要する移行作業も、エージェントが各ファイルの整合性を保ちながら自律的に修正を適用することで、レビュー可能な状態までわずか数時間で到達します。

特に、修正箇所の特定だけでなく、それに伴って発生する連鎖的なエラーの解消までを一貫して任せられる点が、従来の補完ツールとは異なります。

長時間デバッグ・テスト自動化・CI/CD統合の事例イメージ

本モデルをCI/CDパイプラインに自律修復エージェントとして組み込むことで、夜間のビルド失敗や不安定なテストへの対応コストを劇的に削減できます。

GitHub Actionsなどでテスト落ちを検知すると、Codex-Maxが自動的に起動してエラーログを解析し、ローカル環境での再現から修正コードのプッシュ、再テストまでを人間の介入なしにループ実行します。

人間が調査に半日かかるような複雑な競合状態やタイミング依存のバグであっても、エージェントは数時間にわたって粘り強くデバッグを試行し、翌朝には「修正済み」のプルリクエストとして提案します。

このように、開発者の就業時間外を解決時間として有効活用できる点が、チーム全体の業務効率向上に直結します。

セキュリティ・脆弱性診断など防御目的での使い方

Codex-Maxは、従来の静的解析ツールでは検知が困難なビジネスロジックの脆弱性を発見するためのRed Teaming運用でも効果的です。

リリース前のコードベースに対し、エージェントに「攻撃者」のペルソナを与えて数時間の侵入シミュレーションを行わせることで、権限昇格の抜け道や不正な決済フローなどを文脈理解に基づいて特定しやすくなります。

単純なパターンマッチングではなく、複数のAPI呼び出しを組み合わせた複雑な攻撃シナリオを自律的に生成・実行できるため、誤検知を最小限に抑えながら実効性の高いレポートを作成します。

これにより、専門家による監査の前段階でクリティカルな問題を洗い出し、手戻りを防ぐことが可能です。

GPT-5.1-Codex-Maxは誰に向いている?他モデルとの使い分け

最後に、GPT-5.1-Codex-Maxの他モデルとの使い分けについて解説します。

OpenAIの類似モデルに加え、他社のモデルも加えて比較していきます。

GPT-5.1/GPT-5.1-Codex/他社モデルとの比較ポイント

GPT-5.1が汎用的な推論能力を持ち、標準のGPT-5.1-Codexが対話的なプログラミングに特化しているのに対し、Codex-Maxは人間の指示を最小限にしてプロジェクトを完遂させる自律エージェントとして明確に区別されます。

また、Claude 4.5 SonnetやGemini 3 Proなどの他社のハイエンドモデルと比較した際の最大の優位性は、単発のコード生成能力ではなく、独自技術であるコンパクションを用いて数千ファイルの文脈を維持し続ける維持力と一貫性にあります。

短い関数の生成や単一ファイルの修正であれば、応答速度の速い標準モデルや他社モデルの方が、費用対効果で勝る場合があります。

しかし、依存関係が複雑な大規模リファクタリングや、環境構築を含むエンドツーエンドのタスクにおいては、Codex-Maxの深い推論能力と記憶保持機能が有効な選択肢となります。

モデルごとの得意領域と、GPT-5.1-Codex-Maxを選ぶべき条件

GPT-5.1-Codex-Maxを導入すべき条件は、タスクが単一ファイルで完結せず、かつ試行錯誤のループが必要な場合です。

レガシーシステム全体のモダナイゼーション、再現性の低いバグの長期調査、あるいは仕様書からプロトタイプ全体を構築するような数時間から数日規模の作業が該当します。

逆に、特定のアルゴリズムの実装や、構文エラーの即時修正といった、人間が数分で完了できるタスクにMaxを使用するのは、費用対効果が悪くなってしまいます。

開発者は、タスクの「複雑性」と「時間的規模」を見極め、単純作業は標準モデル、プロジェクト単位の改修はMaxという形で明確に使い分ける戦略が求められます。

チーム導入時の権限設計・レビュー体制のイメージ

チームでCodex-Maxを運用する際、最も重要な原則はエージェントにコミット権限は与えても、マージ権限は与えないというルールで運用することです。AIが提案したコードは必ず人間がレビューするようにしましょう。

理想的なワークフローは、Codex-Maxが作成したコードをブランチにプッシュし、プルリクエストを作成した時点で人間のエンジニアにバトンタッチする形です。

また、セキュリティ事故を防ぐため、エージェントには本番環境へのアクセス権やデータベースの書き込み権限を与えず、CI上の隔離されたサンドボックス環境でのみコードを実行できるよう権限を絞る必要があります。

これにより、AIの自律性を活かしつつ、最終的な品質責任とセキュリティ担保は人間が担うという健全な協働体制が構築できます。

まとめ

GPT-5.1-Codex-Maxは、自律的にタスクを実行できるエージェント型コーディングモデルです。コンパクション技術により文脈を要約して保持することで、より高品質な出力が可能となりました。

現在Codexのデフォルトモデルとして提供されており、CloudやCLI、IDE拡張機能として利用できます。

ChatGPTの有料プランを契約していれば使用可能であるため、気になる方はぜひ試してみてください。