ChatGPTは便利なツールですが、大切な個人情報を誤って入力してしまった場合、情報漏洩のリスクが生じます。

この記事では、ChatGPTの情報漏洩対策や機密情報を学習させない方法について、実例を交えながら紹介します。

ChatGPTに個人情報入力してしまった!どのようなリスクがある?

ChatGPTに個人情報を入力してしまった場合、それがどのように利用され、保存されるか不安に思う方も多いでしょう。

特に、第三者に情報が漏洩する危険性や、意図しない目的で利用される可能性について心配するのは当然です。

以下の章ではChatGPTの学習について解説します。

ChatGPTはユーザーが入力した個人情報や機密情報も学習に使用している

最大のリスクは、ユーザーが入力した情報がAIの学習に使われることです。

特に個人向けプラン(Free、Plus、Pro)を利用している場合、デフォルトの設定では、入力した会話データがモデルの改善(学習)に利用される仕様になっています。

もし学習データとして情報が定着してしまうと、全く別のユーザーが関連する質問をした際に、AIがあなたの入力した個人情報や機密情報を回答として出力してしまう可能性がゼロではありません。

これを「学習による意図しない情報漏洩」と呼びます。

一方で、法人向けプラン(ChatGPT Business、Enterprise)やAPI利用の場合は、デフォルトで学習に利用されません。

OpenAIは積極的に個人情報を収集しているわけではない

ChatGPTに入力した情報は、会話の生成やLLMの改善に利用される場合があると先述しました。

しかし、OpenAIは公式の声明として、意図的に個人情報を収集しているわけではないと主張しています。

当社は、当社のモデルのトレーニングのために個人情報を積極的に求めることはしません。

出典:OpenAI Help Center

上記のように、ChatGPTはユーザーが入力したデータを学習に使用していますが、プロファイリングや特定の目的のために情報を収集しているわけではないということがわかります。

ChatGPTの情報漏洩リスクを実例とともに紹介

「気をつけて使えば大丈夫だろう」と思っていても、つい機密情報を入力してしまう可能性は十分に考えられます。

ここでは、生成AIのセキュリティリスクが世界的に注目されるきっかけとなった、実際の情報漏洩(未遂含む)事例を紹介します。

事例1:サムスンの従業員が機密プログラムや議事録を誤入力

最も象徴的な事例として、2023年に世界中で大きく報じられたサムスン電子(Samsung Electronics)のケースがあります。

報道によると、同社の半導体部門において、エンジニアが業務効率化のためにChatGPTを利用した際、本来外部に出してはならない機密データを入力してしまう事案が発生しました。

具体的には、半導体設備計測プログラムのソースコードに見つかったエラーの修正をChatGPTに依頼するためにコード全体をコピー&ペーストしたり、社内会議の内容を録音したデータを文字起こしし、その全文を入力して議事録の作成を指示したりといった行為が行われていました。

同社エンジニアが4月に社内ソースコードをChatGPTにアップロードし、誤ってリークさせた。

出典:サムスン、従業員の生成AI利用を禁止-ChatGPT経由でデータ漏れる Bloomberg

当時のChatGPTの仕様も、入力されたデータはOpenAIのサーバーに送信され、モデルの学習に利用される可能性があるものでした。

つまり、自社の競争力の源泉である独自のプログラムコードや会議内容が、AIの知識の一部として取り込まれ、競合他社を含む第三者への回答として出力されてしまうリスクが発生したのです。

事例2:Amazon弁護士が警告した「社外秘データへの酷似回答」

サムスンの事例と同様に、入力したデータが学習され、他人に回答されてしまうという懸念が現実味を帯びたのが、米Amazon(アマゾン)の事例です。

報道によると、2023年1月、Amazonの企業内弁護士が従業員に対し、「ChatGPTにコードや機密情報を共有しないように」という緊急の警告を発しました。その理由は、単なる予防措置ではありませんでした。

弁護士は、ChatGPTが生成した回答の中に、「Amazonの社外秘データに酷似した内容」が含まれている事例を実際に確認したとしています。

“wouldn’t want its output to include or resemble our confidential information (and I’ve already seen instances where its output closely matches existing material),”

訳:「その出力結果に当社の機密情報が含まれたり類似したりすることを望まない(実際に出力結果が既存資料と酷似する事例を既に目撃している)」

出典:Amazon Employees Using ChatGPT for Coding and Customer Service Warned Not to Share Company Information With AI Chatbot

これは、Amazonの従業員(あるいは関係者)が過去に入力した内部データが、AIモデルによって学習され、第三者が閲覧できる形で出力されてしまった可能性が示唆されています。

「自分たちが入力した機密情報が、ライバル企業のエンジニアへの回答として表示されるかもしれない」というリスクは、もはや理論上の話ではなく現実に起こり得る脅威として認識されたのです。

ChatGPTの情報漏洩リスクは入力データの学習だけじゃない

ChatGPTからの情報漏洩は、常に誤操作によって生じるとは限りません。

システムのバグや不正アクセスによる漏洩の危険も存在します。

ChatGPTのバグにより個人情報が閲覧可能な状態に

2023年3月20日、ChatGPTに重大なバグが発生し、ChatGPTの左側のサイドバーに表示される会話履歴の一部に、第三者のチャットタイトルが誤って表示されたのです。

OpenAIはこの問題を受けて一時的にChatGPTを停止して、修正作業を実施しました。

今週初め、オープンソース ライブラリのバグにより、一部のユーザーが他のアクティブ ユーザーのチャット履歴のタイトルを表示できるようになったため、ChatGPT をオフラインにしました。また、両方のユーザーがほぼ同時期にアクティブだった場合、新しく作成された会話の最初のメッセージが他のユーザーのチャット履歴に表示される可能性もあります。

出典:March 20 ChatGPT outage: Here’s what happened | OpenAI

さらに調査が進む中で、有料サービスであるChatGPT Plusの加入者のうち1.2%の支払関連情報が、別の加入者の端末に誤って表示された恐れがあることも、明らかになりました。

漏洩した情報には加入者の氏名・メールアドレス・支払い先住所・クレジットカードの種類・番号の下4桁・有効期限が含まれていましたが、完全なクレジットカード番号が漏洩することはありませんでした。

さらに詳しく調査したところ、同じバグが原因で、特定の 9 時間の時間帯にアクティブだったChatGPT Plus 加入者の 1.2% の支払い関連情報が意図せず表示された可能性があることも判明しました。月曜日に ChatGPT をオフラインにする前の数時間で、一部のユーザーは他のアクティブユーザーの氏名、メール アドレス、支払い先住所、クレジットカードの種類、クレジットカード番号の最後の 4 桁 (のみ)、クレジットカードの有効期限を見ることができました。クレジットカード番号全体が露出することはありませんでした。

出典:March 20 ChatGPT outage: Here’s what happened | OpenAI

OpenAIは、サービスを一時停止して復旧に取りかかりましたが、一部の時間帯の履歴は復元できない状態が発生しました。OpenAIは、影響を受けた可能性のあるユーザーに通知しました。

この事件は、AIツールの急速な普及に伴うセキュリティとプライバシーの課題を浮き彫りにしています。

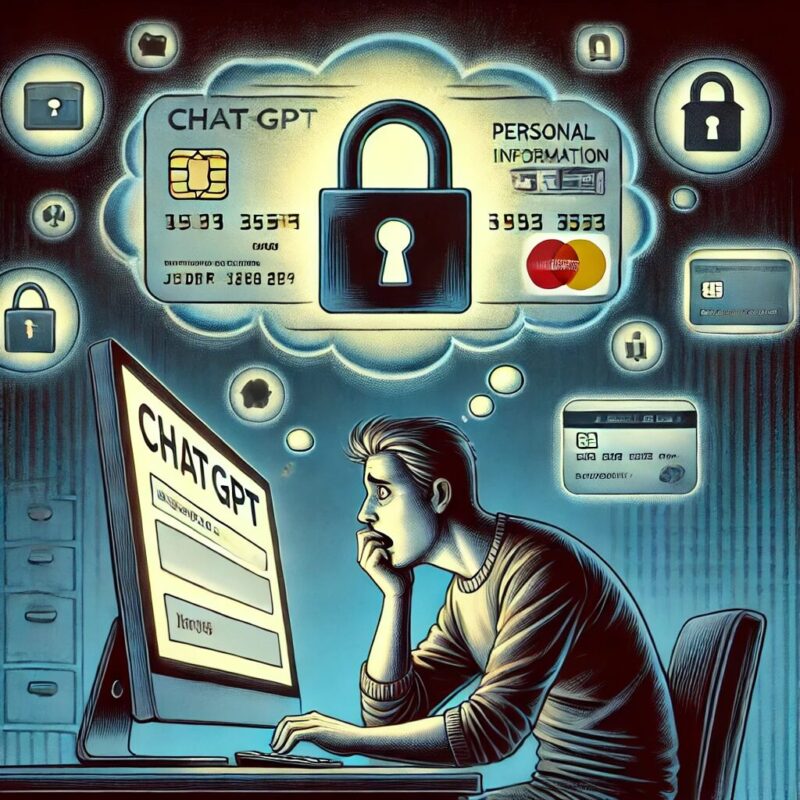

ChatGPTのアカウント情報がダークウェブで売買されている

サイバーセキュリティ企業のGroup-IBの調査によると、10万件以上のChatGPTのアカウント情報がダークウェブ市場に出回っていることが明らかになりました。

売買された情報は、マルウェアによって収集されたもので、アジア太平洋地域での流出が特に多かったと報告されています。

流出したアカウント情報には、機密情報や企業の知的財産が含まれている恐れがあり、これらが悪用された場合、個人や企業に甚大な被害を与える危険性があります。

この事実は、ChatGPTには見られたくない情報を入力しないことや、アカウントの管理に十分な注意が必要であることを、改めて示しています。

GPTsやApps(外部連携)経由で第三者にデータが送信される

「GPTs(カスタムGPT)」や「Apps(旧Connectors)」を使用する場合、データがOpenAI以外の第三者に渡るリスクが発生します。

特定のGPTsやアプリは、外部のAPI(他社のサーバー)と連携して動作します。

例えば「PDF資料作成GPT」や「Webサイト分析アプリ」などを使う際、入力したデータやアップロードしたファイルは、OpenAIを経由して外部API提供者などの第三者サービスに送信される可能性があります。

OpenAIのポリシーでは、これらの外部連携を行う場合、有効化前にユーザーへの通知が表示される仕様になっていますが、クリック一つで許可できてしまうため、無自覚にデータを第三者へ送信してしまう可能性は大いにあります。

「OpenAIは信頼できても、その先の連携ツールが安全とは限らない」というサプライチェーンリスクを認識する必要があります。

ChatGPTの個人情報漏洩対策は機密情報を学習させないこと

最も重要な対策は、大切な個人情報などをLLMの学習に利用させないことです。

本ブロックでは、重要な情報がAIの学習に使われないための方法を紹介します。

ChatGPTを使っていい業務と使ってはいけない業務を規定する

ChatGPTから大切な情報の漏洩を防ぐ最も効果的な方法は、それらを入力しないことです。

まずは、ツール側の設定以前に、人間側のルールであるガイドラインを明確にすることが必要です。企業やチーム内で、情報の機密レベルに応じた取り扱い規定を策定しましょう。

例えば、すでにWebサイトで公開されているプレスリリースや一般的なビジネスメールの作成であれば問題ありませんが、社内情報となると注意が必要です。

取引先名や担当者名を伏せ字にするなど、匿名化を徹底する場合に限り入力可とするような運用ルールが求められます。

一方で、顧客の氏名やクレジットカード情報、未発表の製品仕様といった機密性の高い情報は、どのような設定をしていても入力してはいけません。万が一のシステムトラブルやアカウント侵害のリスクがあるため、入力しないことこそが最も確実な防御策となります。

ChatGPTに入力データを学習させないようにオプトアウトする

OpenAIでは、ユーザーが自分のデータをChatGPTの学習に利用されないように、オプトアウトできる機能を提供しています。

オプトアウトの具体的な方法を紹介します。

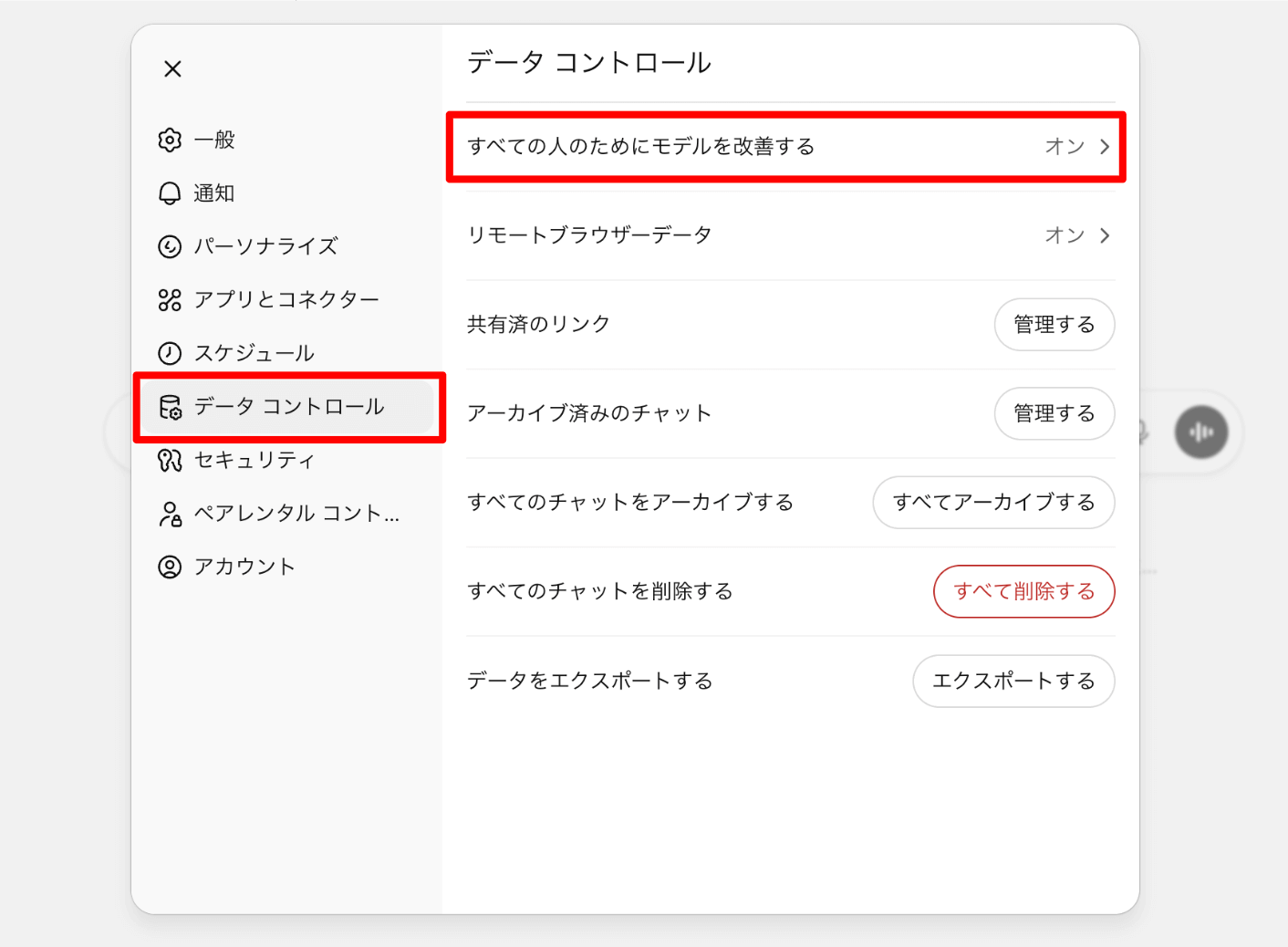

「データコントロール(Data Controls)」から「全ての人のためにモデルを改善する(Improve the model for everyone)」を選択します。

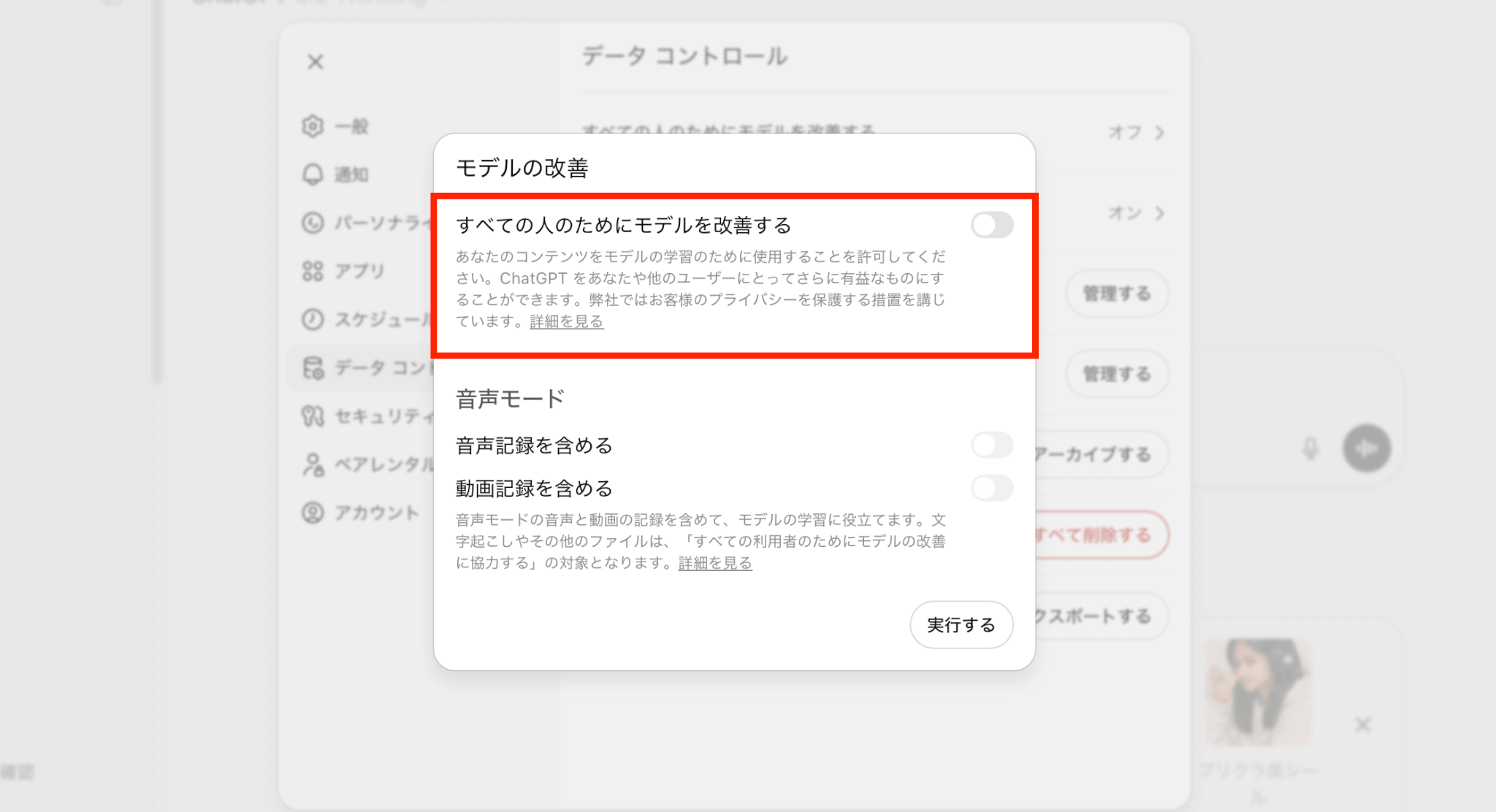

「すべての人のためにモデルを改善する」のボタンをOFFにして、「実行する」をクリックすることで、学習させない設定にできます。

また音声データについても、「音声記録」「動画記録」のそれぞれモデル学習のためにデータを提供するかどうかを選択できます。

オプトアウトのやり方や、その他の情報漏洩対策の方法については、以下の記事で解説しているので、併せて確認してみてください。

まとめ

ChatGPTは使いこなすと便利ですが、情報漏洩のリスクも存在します。

大切な個人情報の入力は避け、必要に応じてオプトアウトを設定しましょう。

また企業で利用する際は、明確なガイドラインをあらかじめ策定しておくことが不可欠です。

適切な対策を講じることで、ChatGPTを安全に活用して、その恩恵を享受できます。