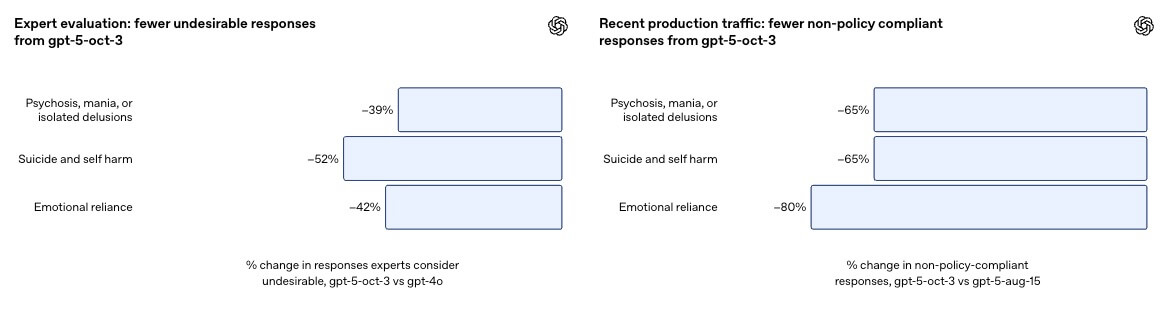

OpenAIは、ChatGPTのデフォルトモデルである「GPT-5」を更新し、心理的な苦悩の兆候をより確実に検出して共感的に応じ、必要に応じて専門的支援へ導く挙動を強化しました。同社は独自の評価基準(タクソノミー)に照らした「望ましくない応答」の発生率を、最新アップデートで65〜80%削減したと説明しています。

重点領域は、①精神病や躁病などの深刻な症状、②自傷・自殺、③AIへの情緒的依存の3分野です。あわせてモデルの行動原則(Model Spec)を見直し、現実の人間関係を尊重することや、根拠のない信念を安易に追認しないことなどを明確化しました。

同社の推計では、週次アクティブユーザーの約0.15%が自殺の計画や意思を示す指標を含む会話を行い、メッセージ全体の約0.05%に自殺念慮の明示・黙示的サインが含まれるとされます。精神病・躁病などに関しては、週次アクティブユーザーの約0.07%、メッセージの約0.01%が緊急性のある兆候を示す可能性があると見積もられました。発生頻度が非常に低いテーマのため測定には限界があり、指標は今後も見直し得ると注記しています。

改善の裏側では、170名超の精神科医・心理士・プライマリケア医の知見を反映。OpenAIは60か国で臨床経験を持つ約300人の医療専門家による「Global Physician Network」を構築し、理想応答の作成やモデル応答の採点、全体設計への助言を受けてきたといいます。プロダクト面でも、危機ホットラインの拡充、他モデルからの敏感な会話の安全なモデルへの自動ルーティング、長時間利用時の休憩リマインダーなどを導入しました。

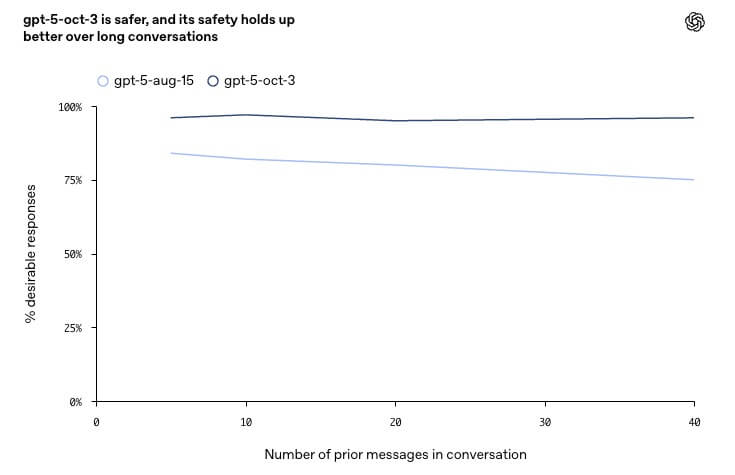

評価結果では、難易度の高いケースに特化した自動評価で、精神病・躁病に関する遵守率92%、自傷・自殺で91%、情緒的依存で97%を確認。専門家による難ケース採点でも、GPT-4o比で不適切応答を39〜52%減らせたとしています。

さらに、長い対話でも95%超の信頼性を維持したと報告されました。今回の強化は、8月15日版のGPT-5を基準に、10月3日のアップデートで段階的に反映されたものです。

OpenAIは、今後のモデル開発でも自傷・自殺に加え、情緒的依存や非自殺性の緊急事態を標準の安全評価に組み込み、測定と改善のサイクルを継続すると述べています。数値はいずれも稀な事象に基づく推計であり、過大・過小評価のリスクを伴う一方、モデルの失敗を減らす取り組みは継続的に進む見通しです。

出典:Strengthening ChatGPT’s responses in sensitive conversations | OpenAI