この記事は、Podcast「AI未来話」のエピソード「生成AIの創造性は実はバグだったのかもしれない」を再構成した内容をお届けします。

生成AIが質問に対して毎回異なる答えを返す「ランダム性」。これは創造性として評価される一方で、実は意図しないシステムのバグだった可能性が最新研究から浮上しています。

今回は、このランダム性の原因やその是非を掘り下げ、AIの進化にとっての意味を考察します。

生成AIのランダム性の新たな原因「バッチ不変性の欠如」とは

生成AIはその出力結果に微妙な違いがあり、これが創造的と評価されることもあります。

しかし、この現象は意図したものではなく、実はバグが原因なのではないかという議論が注目されています。その背景と最新の研究について見ていきます。

生成AIの非決定的と決定的とは

生成AIが毎回異なる結果を返す理由について、まず押さえておきたいのが「非決定性」と「決定性」の違いです。AIが質問に答える時、同じ入力に対して常に異なる結果を出すことを「非決定的」、常に同じ結果を出すことを「決定的」と呼びます。

―― 確かにChatGPTを使っていると、毎回少しずつ回答が違うので不思議だなと思っていました。

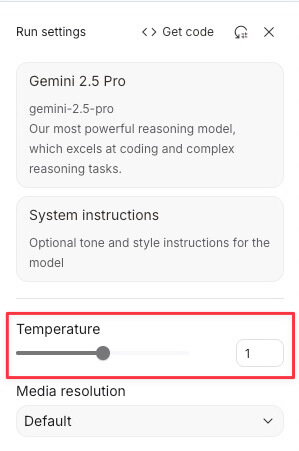

「そうですよね。生成AIは次に選ぶべき言葉を確率的に選択していて、この確率に基づいたランダム性が非決定性を生んでいます。ただ、完全にランダムなのかというとそうではなく、『Temperature(テンパレーチャー)』という設定値である程度コントロールが可能です。Temperatureを高くすると多様で予測困難な結果が出やすくなり、逆にTemperatureをゼロにすると、理論上は毎回最も確率の高い回答が出てきて結果が固定されるようになるはずなんですよ」

―― Temperatureをゼロにすれば必ず同じ結果が得られるはず、という理屈は理解できます。でも実際にはゼロにしても毎回微妙に結果が違いますよね。

「そうなんです。ここが問題でして、理論上は同じ回答になるはずなのに現実には揺らぎが生じます。その理由を説明するために、これまで『GPUの並列処理と不動少数点計算の性質』という通説がありました。GPUの並列処理というのは、簡単に言えば大量の計算を同時並行で処理する仕組みのことです。生成AIが使っているGPU(グラフィックス処理ユニット)は、一つの処理を複数の細かな演算に分けて、それぞれを同時に計算し、最終的にその結果を一つにまとめるという方法をとっています。この時、並列で実行された個々の計算結果をまとめる際に、わずかな時間差や順序のズレなどの影響で微小な差異が発生する可能性があります。さらに、その計算時には『不動少数点』という仕組みで計算を省略していることで丸め誤差も発生するのです。」

―― 「不動少数点」というのは、具体的にはどういうことなんですか?

「簡単に言うと、数字を計算する際にあまりにも桁数が多くなるため、それらを一定の桁数に丸めて箱詰めするような処理です。これによって少しずつ数字に誤差が生じ、それが計算を繰り返すことで積み重なり、最終的に大きな違いを生む『バタフライエフェクト』のような現象が起きると言われていました」

―― バタフライエフェクトというのは、確か「蝶の羽ばたきが原因で遠く離れた場所の気候が変わる」といった話ですよね。

「まさにその通りです。GPUの並列処理における微小なズレと、不動少数点による計算の丸め誤差が重なり合い、小さな誤差が最終的な結果に大きく影響を与えるので、まるで『バタフライエフェクト』のような現象なわけです。」

元OpenAIのCTOミラ・ムラティ氏の会社「Thinking Machines Lab」とは

生成AIが抱える「非決定性」の真相に迫る研究を行ったのが、元OpenAIのCTOであるミラ・ムラティ氏が新たに立ち上げた新会社「Thinking Machines Lab(シンキング・マシーンズ・ラボ)」です。設立から間もないこの研究所が発表した最初の論文は、AI業界で大きな注目を集めています。

Thinking Machines Lab exists to empower humanity through advancing collaborative general intelligence.

— Mira Murati (@miramurati) July 15, 2025

We're building multimodal AI that works with how you naturally interact with the world – through conversation, through sight, through the messy way we collaborate. We're…

―― OpenAIはChatGPTなどを開発したことで非常に有名ですが、そのCTOだったミラ・ムラティさんが独立して新しい会社を設立したというのは興味深いですね。

「そうなんです。ムラティさんが立ち上げた『Thinking Machines Lab』という会社は、『人間にとって安全で信頼できるAIの開発』を目標に掲げています。設立当初からすでに約30名のメンバーが在籍していて、その3分の2はOpenAI出身者ということで、まさに『ほぼOpenAI』という感じですね(笑)。それだけに、この会社の動向には業界内でも非常に関心が高まっています」

―― 初めての研究論文でこのランダム性の問題を取り上げたということは、やはり業界内でも重要な課題だと認識されているわけですね。

「そうですね。この論文を執筆したのはホレス・ヒー氏という方で、彼はこれまでの通説に対して異議を唱えました。ヒー氏によると、従来の『GPUの並列処理と不動少数点計算の性質』という説は確かに存在する現象ではあるものの、それだけでは実際に起きている大きな揺らぎを説明できないと主張しています」

―― 具体的にはどんな実験をしてそれを証明したんでしょうか?

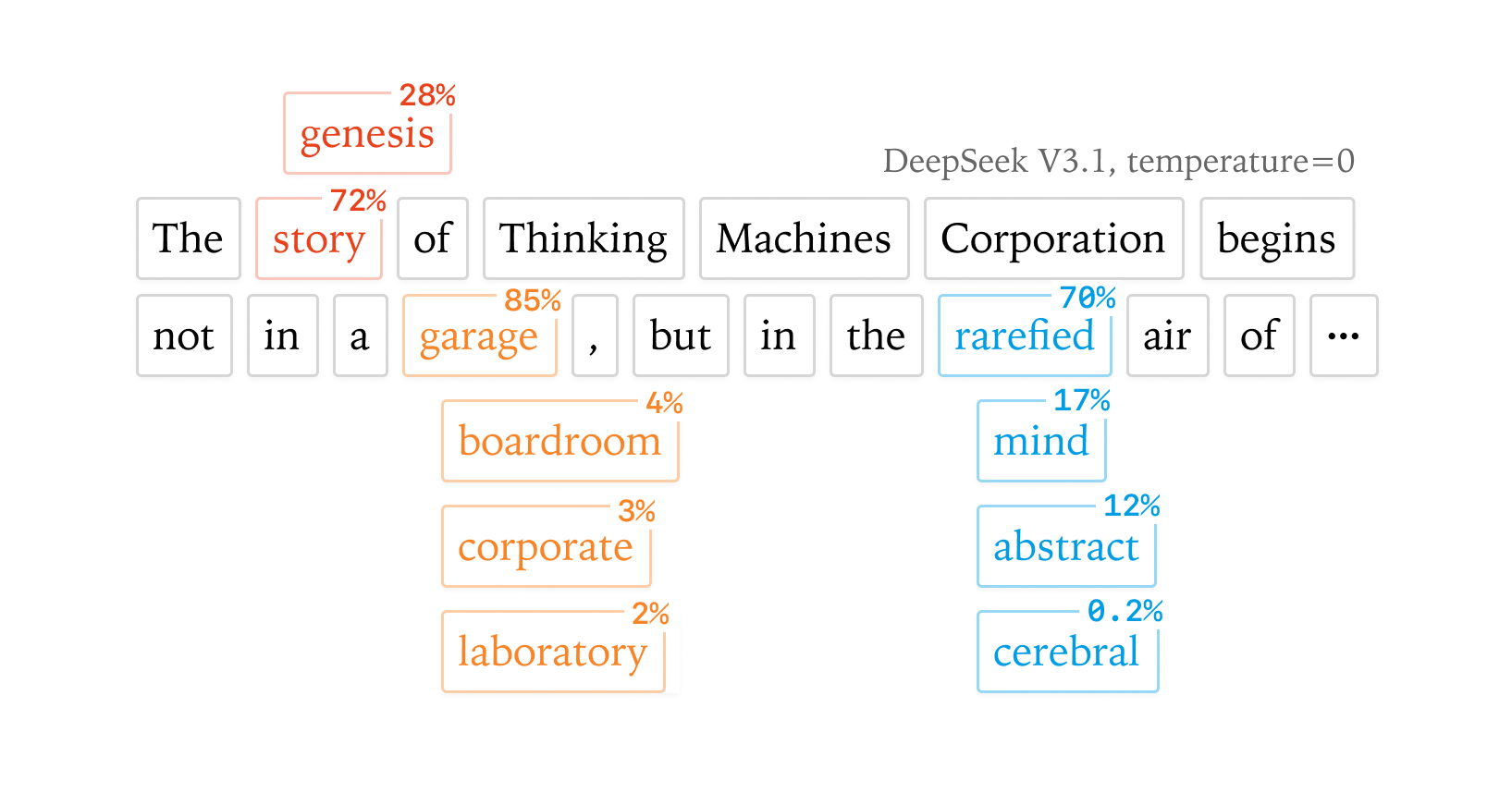

「論文の中でヒー氏は『GPU上で全く同じ行列の掛け算を1000回繰り返した結果を観察した』という実験を報告しています。もしGPUの並列処理自体が非決定的なら、同じ計算を繰り返すうちにどこかでズレが出るはずですよね。しかし、実際の実験結果は1000回とも完全に一致したというのです。つまり、並列処理による誤差だけでは現実に起きている非決定性を説明できないということが証明されたわけです」

―― なるほど。言われてみれば、同じ条件で同じ処理をして毎回同じ結果になるというのは自然な気もしますね。

「そうなんですよ。つまりGPUの個々の処理自体は完全に決定的なのに、なぜか全体の処理結果が非決定的になってしまうという、一種のパラドックスが起きている状態です。これはつまり、別の何かが原因で非決定性が発生している可能性を示しています。そして、その新しい原因として特定されたのが、次に解説する『バッチ不変性の欠如』という現象なんです」

ランダム性の新たな原因「バッチ不変性の欠如」とは?

Thinking Machines Labのホレス・ヒー氏が特定した生成AIのランダム性の新たな原因が「バッチ不変性の欠如」です。この現象は従来のGPU並列処理説を超える、より根本的な問題として業界の注目を浴びています。

―― 「バッチ不変性の欠如」というのはなかなか難しい言葉ですが、具体的にはどういうことなのでしょうか?

「確かにちょっと難解な用語ですよね。まず『バッチ』というのは、データを一定数まとめて一括処理することを指します。AIの推論サーバーでは、世界中から送られてきた複数のユーザーのリクエストを一つのグループにまとめ、一括して処理しています。これをバッチ処理と言いますが、このバッチのサイズ(処理単位)がサーバーの負荷状況に応じて常に変動することが、『バッチ不変性の欠如』という現象なんです」

―― つまり、毎回違う人数のリクエストをまとめて処理しているから、結果も毎回微妙に異なってしまうということでしょうか?

「その通りです。例えば、あるときは7人のユーザーのリクエストを一緒に処理し、別のときは255人のユーザーのリクエストを一括処理する、といった具合にバッチサイズが常に変わっているわけです。処理の規模が違えば計算プロセスが微妙に異なり、その結果として最終的な回答にも違いが生じてしまうんです」

―― パンを焼くときに大量に焼くのと少量で焼くのとでは、味や焼き具合が違うのと同じようなイメージでしょうか?

「まさにそのイメージが近いです。バッチという言葉自体の由来はパンなどをまとめて焼く『batch baking』に由来していますから、イメージとしては間違っていないと思います。AIの処理の場合も、『大量にまとめて処理するとき』と『少量の処理をする場合』では細かな演算の手順が変化し、それが微妙な誤差となって結果に反映されてしまうわけです」

―― そうなると、ユーザーから見ると毎回微妙に違う回答が返ってきてしまうのですね。これはちょっと意外な原因でした。

「そうですね。ヒー氏の研究によれば、今ほとんどのLLM(大規模言語モデル)の推論で起きている非決定性の問題は、この『バッチサイズが変動すること』が最大の原因だと指摘されています。しかも、この問題は特定のAIモデルやハードウェアに限定されず、広範囲な生成AIに共通する構造的な問題だとされています。実際、GoogleのTPUなど他のプロセッサでも同様の現象が起きていると報告されています」

―― これは解決するのは難しそうですが、具体的にどのような対策が考えられるんでしょうか?

「最も単純な解決策は『バッチサイズを固定化すること』です。つまり、常に一定数のリクエストを処理するように設計すれば、原理的には非決定性を排除できます。ただし、これには性能の犠牲という大きなデメリットが伴うため、現実的には簡単な話ではありません。」

ランダム性を取り除くメリットとデメリット

生成AIのランダム性が意図しないバグに起因していることが明らかになったことで、このランダム性を取り除くべきかどうかが新たな議論になっています。ランダム性を排除することで得られるメリットは大きい一方、意外なデメリットも存在するため、このバランスを慎重に見極める必要があります。

安定したAIがもたらす分野ごとの恩恵

ランダム性を排除して安定したAIが実現すると、特に恩恵を受けるのが医療や金融、法務などの正確性が求められる分野です。これらの分野では回答が少しでも揺らぐことは致命的なリスクを生むため、生成AIの非決定性は実用化を阻む大きな壁となっています。

―― 確かに医療や金融の場面でAIが使われるには、回答が毎回一致しなければ信用されにくいですよね。

「そうですよね。医療分野を例にすると、AIを用いて患者の病気の確率を診断する場合、一度目の診断結果が『病気の確率76%』だったのに対して、二度目は『95%』と大きく違ってしまったら、それを治療判断の基準として使うのは難しいですよね。これではAIの導入を躊躇せざるを得ないのです。逆にランダム性が取り除かれ、毎回同じ安定した診断結果が出るようになれば、医療現場でもAIが安心して導入できるようになります」

―― 金融や法務でも同じような問題がありますね。

「そうです。金融では融資判断やリスク評価にAIが使われますが、結果に揺らぎがあれば経済的損失に直結する可能性があります。法務分野においても判例検索や法的判断の支援にAIを使う場合、一貫性のない回答は裁判などの場で致命的な問題を引き起こします。そのため、これらの分野でも安定した回答が極めて重要です」

また、映像制作や画像生成といったクリエイティブ分野においても、安定した生成が求められる場面が少なくありません。

―― 映像制作の現場でも毎回結果が変わってしまうと非常に困りますよね。

「映像制作においては、同じキャラクターやシーンが毎回微妙に違ってしまうことは避けるべきです。安定したAIがあれば、こうした制作工程が効率化され、作品のクオリティ向上にもつながるでしょう」

さらにAI自身の強化学習においても大きな恩恵が期待できます。オンポリシー強化学習と呼ばれる手法では、AIが自身の行動に基づいて報酬を得て学習を繰り返しますが、結果が安定しないと学習効率が著しく低下してしまいます。ランダム性が排除されれば、AIが安定した方策で行動を繰り返し、学習プロセスがより効率化されることが期待されています。

―― AIが学習する際にも安定性が重要ということですね。

「まさにその通りです。研究者からも、わずかな揺らぎが学習アルゴリズムに深刻な影響を与えるという指摘があります。ランダム性を取り除くことで、こうした学習時の問題も改善される見込みです」

性能低下と創造性の喪失というデメリット

一方で、生成AIのランダム性を完全に排除することは必ずしも良いことばかりではありません。実際には、性能の大幅な低下や創造性の喪失といった深刻なデメリットも伴います。

―― ランダム性を排除すると性能が落ちるという話がありましたが、具体的にどれくらい落ちてしまうのでしょうか?

「Thinking Machines Labの論文によれば、バッチサイズを固定化してランダム性を排除すると、生成AIの性能が約20%低下することが確認されています。この数字は決して小さくなく、現在、軽量化を目指しているAIモデルからさらに性能が落ちるとなると、場合によっては実用に耐えなくなってしまう恐れがあります。特に日常的に利用する一般ユーザーにとっては、生成の精度や速度が落ちることは大きなストレスとなるでしょう」

―― 確かに、AIの性能が20%も下がったら利用者としては使いづらく感じるかもしれませんね。

「そうなんですよね。今後AIがより広く普及するには、性能が高いことが前提条件になっています。したがって、この性能低下を受け入れてまでランダム性を排除するという選択が果たして現実的かどうかという点は、議論の余地があると思います」

また、もう一つ重要なデメリットとして指摘されているのが「創造性の喪失」です。これまで生成AIが評価されてきた「創造性」とは、実はこのランダム性が生み出した偶然の産物である可能性が高いためです。

―― AIが創造的だと評価されている背景には、偶然のランダム性があったというのは意外ですね。

「確かに意外ですが、考えてみれば当然とも言えます。これまでのAIは、毎回異なる結果を偶然に生成することで、予想外のユニークなアイデアを提供してきました。これがユーザーにとって新鮮で創造的に映っていたわけですが、その『偶然の産物』をもたらしていたランダム性がなくなれば、結果が画一的になり、創造的と評価されることも減ってしまうかもしれません」

―― AIの創造性が失われると、特にクリエイティブな分野では問題になりそうですね。

「まさにその通りです。映画や音楽、アート、さらにはマーケティング分野など、AIの偶然性や創造性を評価し利用している場面は少なくありません。完全にランダム性を排除してしまえば、これらの分野でAIが提供できる価値が低下する可能性があります」

実際、人間のクリエイティブな活動にも「偶然性」や「予測不可能な要素」がしばしば重要な役割を果たしてきました。映画監督やミュージシャンの創造的なひらめきやインスピレーションが、一種の偶然性や予測不能性に起因していると考えると、AIにおいてもランダム性は創造性を生み出す大切な要素だったのかもしれません。

―― ということは、ランダム性は完全になくすべきではないかもしれないということでしょうか?

「そうですね。ランダム性の排除が必要な分野もあれば、逆にランダム性を積極的に活用したい分野もあるということです。むしろ今後のAI開発では、目的や用途に応じてランダム性を『適切にコントロールする』という視点が求められるのではないかと思います。つまり、ただ排除するだけでなく、意図的にランダム性を残すことで創造性を保ちつつ、必要な場面では安定性を確保するというハイブリッドなアプローチが有効になる可能性があります」

エンディング

―― ランダム性を排除することが本当に正しい方向なのか、改めて考えさせられる内容でしたね。

「そうですね。個人的には、このランダム性を巡る議論を聞いて、映画『マトリックス』を思い出しました。『マトリックス』の世界では、システムがわざとバグを作り出すことでシステム全体が強化されるという設定があります。つまり、バグは必ずしも排除されるべきものではなく、むしろ新たな進化や強化のきっかけになり得るという考え方ですね」

―― AIのランダム性も、そのような性質があるかもしれないということでしょうか?

「まさにその通りです。生成AIが抱えていたランダム性というバグは、これまで『創造性』という予期せぬ恩恵をもたらしていました。仮に今回このバグを取り除いたとしても、別の新しいバグが現れ、それがまた新しい発見や進化につながる可能性も十分あるわけです。完全なデバッグが必ずしも良いとは限らない、ということを示していると思います」

―― そう考えると、この問題は単純に解決すべきバグではなく、AIの未来を左右する重要なテーマになるかもしれませんね。

「そうですね。ランダム性をどう扱うかという問題は、単なる技術的課題を超えて、AIという技術そのものの在り方や方向性を決定する重要な議論になるでしょう。今後のAI開発は、単純な性能向上だけでなく、安定性と創造性をどのように共存させるかという難しい課題に向き合っていくことになると思います」

まとめ

生成AIのランダム性は、従来「創造性」として評価されてきましたが、実はシステムのバグに由来する可能性が最新研究から明らかになりました。このバグの根本原因は、Thinking Machines Labが指摘した「バッチ不変性の欠如」であり、これまで考えられてきたGPUの並列処理による誤差とは異なる次元の問題です。

ランダム性を取り除くことで医療や金融など高い安定性が求められる分野へのAI導入が加速し、強化学習の効率化にもつながる一方、性能の約20%低下や、AIの創造性の喪失というデメリットも懸念されています。AIの進化においては、この「安定性」と「創造性」の絶妙なバランスをどう取るのかが、重要な議論の焦点となっていくでしょう。