「MidjourneyとStable Diffusionの違いを知りたい」「結局どっちが最適?」

そんな疑問に答えるべく、画像生成AIの2大ツールを画質・操作性・料金・機能などの観点からわかりやすく比較しました。

この比較を読めば、自分の用途に最適なツールがすぐにわかります。

画像生成AIの2大ツール:MidjourneyとStable Diffusionの基本をおさらい

近年急速に注目を集める画像生成AI。その中でも特に人気を集めているのがMidjourneyとStable Diffusionの2つです。

どちらも高品質な画像を生成できる強力なツールですが、得意な分野や使い方には違いがあります。

まずはそれぞれの特徴を簡単におさらいしておきましょう。

Midjourneyとは?

Midjourneyは、クオリティの高いビジュアルを手軽に生成できる商用AIツールです。

Discord上でプロンプトを入力するだけで画像を生成でき、アーティストやデザイナーにも人気があります。

操作が直感的で、細かい技術知識が不要な点も大きな魅力です。公式サイトからWeb上で利用することも可能です。

特に最新では「V1 Video Model」という動画モデルも登場し、プロンプトから動画が生成できるようになり、今後は3D生成にも展開する予定が明らかにされています。

この進化により、Midjourneyは従来の静止画生成を超えて、より多彩なクリエイティブ表現を実現するツールへと変貌を遂げています。

Stable Diffusionとは?

Stable Diffusionは、オープンソースで利用できる画像生成AIです。

ローカル環境で動かすことも、Web UIやサービス経由で使うこともできるため、柔軟性が非常に高いのが特徴です。

ベースモデルを拡張したモデルや特徴を付与するLoRAやVAEも豊富で、高度なカスタマイズや自分好みのモデル選択も可能です。

拡張性と自由度に優れ、LoRA・VAE・ControlNetなどの追加要素で進化を続けています。公式のアップデート以上に、コミュニティの盛り上がりがエコシステムの成長を牽引しているのが特徴です。

MidjourneyとStable Diffusionの違いを徹底比較【8項目で解説】

MidjourneyとStable Diffusionのどちらを使えばいいか悩んでいませんか?

この章では、画像生成AIの2大ツールを8つの視点から徹底的に比較していきます。

画像の仕上がり・自由度・料金・著作権ポリシーなど、使い勝手に直結する要素ばかりなので、ぜひ選定の参考にしてください。

画像のクオリティとスタイル傾向の違い

Midjourneyは見栄えのいい画像が得意で、デフォルトでも印象的な構図・照明・スタイルを自動調整してくれます。特にV6以降は写真に近いリアリティ、V7ではさらに動画的なフレーミングセンスや美的整合性が進化しています。

一方でStable Diffusionは出力の質がモデル依存。ベースモデル(SDXL 1.0)のままでも十分高画質ですが、写真・アニメ・イラストなど用途に応じたLoRAやVAE、カスタムモデルを追加することで画風の自由度が広がります。

Midjourneyはそのままでも「いい感じ」の画像が作れますが、表現の幅や自由度においてはStable Diffusionが一歩リードしています。逆に、安定したクオリティと見映え重視ならMidjourneyの手軽さと仕上がりの良さが魅力的です。

また、MidjourneyとStable Diffusionでは、同じテキストプロンプトを使っても得られる画像のスタイルや構図に違いが出ます。

a surreal landscape of floating islands with ancient ruins, cinematic lighting, ethereal atmosphereというプロンプトでは、Midjourneyは追加指示がなくても、幻想的な空気感や光の演出が際立ち、背景まで含めた構図が完成されています。

特にV7では、シネマティックかつ印象的な一枚絵を自動的に作る力が顕著です。

一方、Stable Diffusion(SDXL 1.0)は構図がやや素材的に見えることもありますが、モデルやVAEの調整次第で作風の自由度は高いです。

a woman holding an umbrella in her left hand, standing on a bridge at sunset, facing the cameraのように構成要素が具体的なプロンプトでは、Midjourney V7は色彩や雰囲気だけでなく、構図の再現性もかなり高くなってきています。

左手で傘を持ち、カメラに正対するといった要素もおおむね正しく表現されています。ただし、橋などの背景構造はやや雰囲気寄りに解釈される傾向があります。

論理的な構造(たとえば「左手に傘を持つ」「カメラに正対する」など)をある程度反映する力があります。

こうした違いから、Midjourneyは“絵作りが得意なカメラマン”、Stable Diffusionは“きっちり仕事するエンジニア”のような性格が見えてきます。

モデル構造・学習拡張の自由度

Stable Diffusionは「自分でカスタマイズできる」ことが最大の特徴です。LoRA・VAE・ControlNetなどの追加により、モデル自体を拡張・再学習できる設計になっています。

コミュニティ発の学習済みモデルも充実しており、「好みの画風に特化したモデルで生成したい」というニーズに強く対応できます。

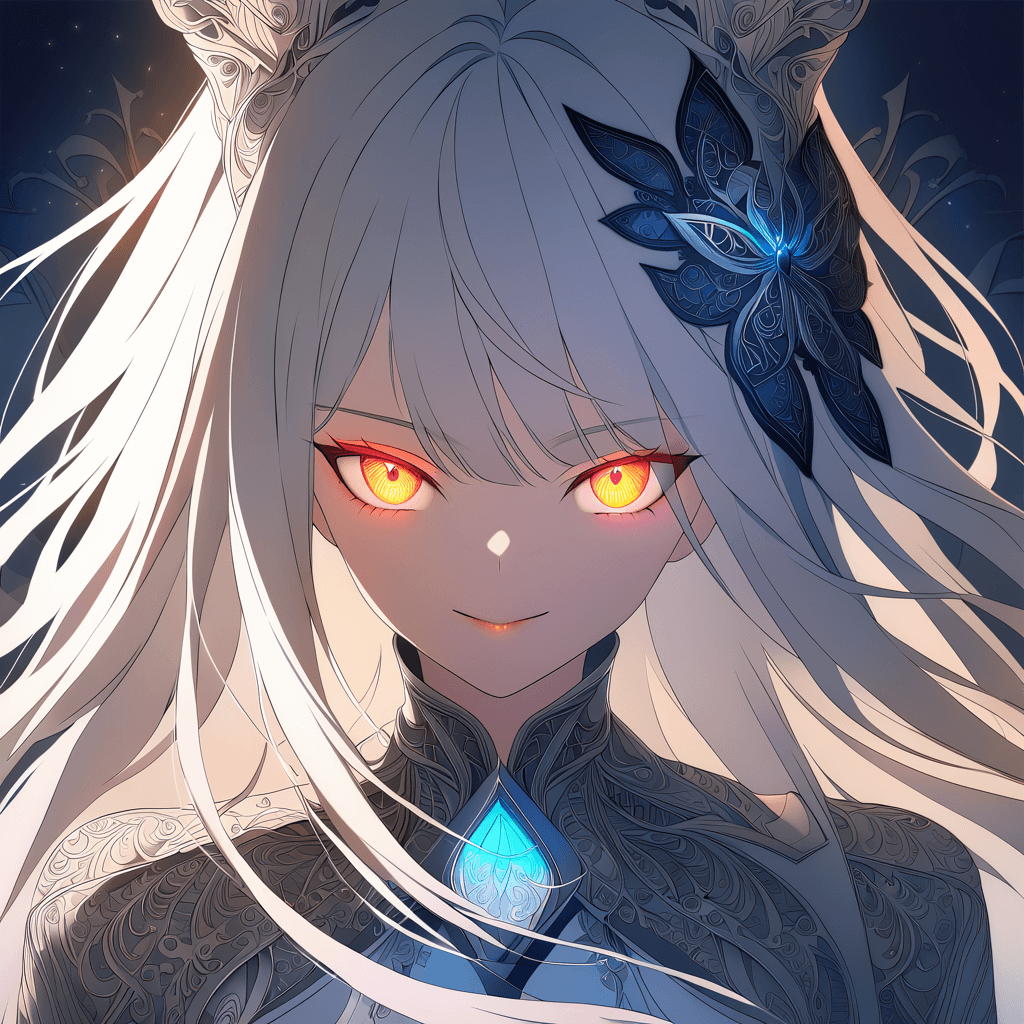

同じポジティブプロンプトを用いて、同じシード値を利用しても、モデルの違いや、ネガティブプロンプトを追加することで、このように大きく変化があります。

モデルを変えると出てくる画風が完全に変わりますし、ネガティブプロンプトを入れると不自然なところを排除することが出来ます。

# ポジティブプロンプト

a detailed fantasy portrait of a young woman with glowing eyes, soft lighting, intricate clothing, highly detailed, sharp focus, digital art

# ネガティブプロンプト

blurry, bad hands, deformed fingers, lowres, poorly drawn, extra limbs, disfigured| 条件 | 画像 |

|---|---|

| ベースモデル ポジティブプロンプトのみ |  |

| ベースモデル ポジティブプロンプトと ネガティブプロンプトを利用 |  |

| 学習済モデル ポジティブプロンプトと ネガティブプロンプトを利用 |  |

一方Midjourneyは、モデル構造は非公開かつユーザーによる学習は不可。V5、V6、V7と内部アップデートで進化していますが、ユーザーが任意の学習データを加えたり、個別のスタイルモデルを差し替えるといったことはできません。あくまで「完成された生成体験」を提供する方向性です。

ただし最近では、Midjourneyも「Style Tuner」などの形で見た目の調整プリセットを使える機能が登場しており、部分的なカスタマイズに対応しつつあります。とはいえ、本格的なモデルのチューニングや追加学習を重視するなら、Stable Diffusionが圧倒的に有利です。

操作のしやすさとワークフロー効率

MidjourneyはDiscordベースの操作が特徴的です。チャットにプロンプトを入力して生成指示を出し、結果がスレッド形式で返ってきます。

これにより手軽に始められ、操作はシンプルかつ直感的。アップスケールやバリエーション展開もワンクリックで可能です。現在はWebブラウザ上でも利用可能になっており、より視覚的で整理されたUIで操作できるようになっています。

一方、Stable Diffusionは多様なGUIツールやAUTOMATIC1111などのWebUIが存在し、操作性はツールによって大きく異なります。慣れが必要ですが、そのぶん細かいパラメータ調整やバッチ処理など多機能で柔軟なワークフローが組めます。

「手軽さと即効性」を求めるならMidjourney、「細かい調整と一括処理」をしたいならStable Diffusionが適しています。

生成速度と環境依存の違い

Midjourneyはクラウド上で画像生成が行われるため、ユーザーのPCスペックに左右されず、安定した速度と品質が期待できます。

生成速度や同時実行数はプランによって異なりますが、手間なく始められるのが魅力です。

一方、Stable Diffusionは基本的にローカルで実行するため、快適に使うにはローカル環境を構築するための知識と、GPU性能が重要です。

目安としては、VRAMが8GB以上のGPU、たとえばRTX 3060以上を搭載したPCなら、SDXL 1.0でもストレスなく動作します。

料金体系とランニングコスト

Midjourneyはサブスクリプション型の料金プランが設定されています。月額10ドル程度のベーシックプランから、生成可能枚数や優先度が上がるプランまで複数あります。日本円換算で約1,200~4,500円程度が相場です。

ベーシックプランではファスト生成時間を使い切ると画像が作成できなくなります。画像を大量に作成したい場合は、スタンダードプラン以上に入る必要があります。

| 項目 | Basic Plan | Standard Plan | Pro Plan | Mega Plan |

|---|---|---|---|---|

| 月額料金 | $10 約¥1,500 | $30 約¥4,500 | $60 約¥9,000 | $120 約¥18,000 |

| 年額プラン (月額相当) | $8 約¥1,200 | $24 約¥3,600 | $48 約¥7,200 | $96 約¥14,400 |

| ファスト生成時間 | 3.3 h | 15 h | 30 h | 60 h |

| 同時高速画像ジョブ数 | 3 | 3 | 12 | 12 |

| 同時高速動画ジョブ数 | 1 | 3 | 6 | 12 |

| リラックス生成 | — | 無制限 (画像のみ) | 無制限 (画像&動画) | 無制限 (画像&動画) |

| ステルスモード生成 | — | — | ○ | ○ |

Midjourneyでは環境構築が不要で、誰でもすぐに高品質な画像を得られます。月額料金がかかるためランニングコストが掛かりますが、手間や学習コストは最小限です。

一方、Stable Diffusionは無料で使えるオープンソースの画像生成AIですが、本格的に使うにはローカル構築や機材の準備といった初期コストが必要です。一度環境を整えれば、その後のランニングコストはほぼゼロで使えるというのが強みです。

このように、「初期コストを抑えて手軽に始めたいならMidjourney」「長期的なランニングコストを抑えるならStable Diffusion」と、目的に応じた選択ができます。

著作権・商用利用ポリシーの比較

Midjourneyは商用利用も可能な有料サービスですが、ポリシー違反となる利用には注意が必要です。

“You may not use the Services to infringe the rights of others, or generate content that is unlawful, harmful, violent, racist, sexually explicit, or otherwise objectionable.”

「本サービスを利用して他者の権利を侵害したり、違法、有害、暴力的、人種差別的、性的に露骨な、またはその他の不快なコンテンツを作成したりすることはできません。」

出典:Midjourney Terms of Service

また、自動生成ボットなどによる不正アクセスやAPIの不正利用も明確に禁止されています。著作権は有料ユーザーに帰属しますが、利用規約に反した用途は制限されます。詳細は公式規約をご確認ください。

Stable Diffusion(SDXL 1.0)はオープンソースで、生成物の著作権はユーザーに帰属します。ただし、用途には制限があり、たとえば未成年の搾取や差別的な利用、医療・法律関連での誤用などは禁止されています。これらの禁止事項は派生モデルにも適用されるため、商用・研究問わずガイドラインの確認が推奨されます。

“You may not use the model or its derivatives: for any unlawful, harassing, or discriminatory purpose; to exploit or harm minors; or for medical or legal advice.”

「モデルまたはその派生物を、違法、嫌がらせ、または差別的な目的、未成年者を搾取または危害を加える目的、または医療または法律上のアドバイスのために使用することはできません。」

出典:Attachment A, Prohibited Uses

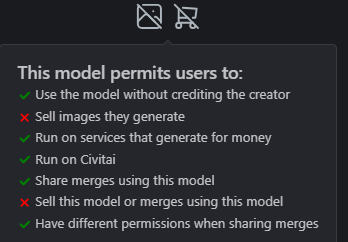

また、LoRAやカスタムモデルなど、派生モデルごとに独自のライセンスや利用制限が設けられている場合もあります。商用利用や公開の際は、それぞれのモデルページでライセンス条項を確認することが重要です。

Civitaiでは、モデルページ右下の「License」欄で確認できるため、利用前に必ず目を通しておきましょう。この画像のようにSell images they generate部分が許可されていない場合、商用利用不可のモデルとなります。

商用利用の明確な許可を重視する場合、Midjourneyを用いるか、Stable Diffusionのそれぞれのモデルでのライセンス確認が重要となります。

利用コミュニティとサポート体制

Midjourneyは、公式Discordを中心としたコミュニティが非常に活発で、画像生成のサンプルやプロンプトの共有も盛んに行われています。

初心者でも入りやすい雰囲気があり、困ったときには他ユーザーからすぐにリアクションをもらえることもあります。公式からのアナウンスも頻繁で、最新情報にすぐアクセスできるのも利点です。

英語中心ではありますが、視覚的なやりとりが多く直感的に理解しやすい点も魅力です。

Stable Diffusionは、GitHubやReddit、Civitaiなど多くの分散型コミュニティが存在し、技術寄りの情報が非常に豊富です。カスタマイズや拡張性を求めるユーザーにとっては、プラグインやモデルの導入事例が多く、大きな強みになります。

ただし、情報が多岐にわたるぶん初心者には取捨選択が難しく、導入のハードルを感じる場合もあります。自分のペースでじっくり探求したい中〜上級者に向いています。

コミュニティの“入りやすさ”と“情報の多様性”で選ぶなら、Midjourneyは初心者向け、Stable Diffusionは技術好き向けと言えます。

ローカル vs クラウド:導入ハードルと柔軟性

Midjourneyは完全クラウドサービスのため、インストール不要で誰でもすぐに始められます。PCスペックを気にせず利用可能ですが、インターネット接続が必須です。

Stable Diffusionはローカル環境構築が標準で、設定やPCスペックの問題が導入の壁になることがあります。しかしその分、カスタマイズ性やオフライン利用の自由度は高いです。

Stable Diffusionをクラウド上で利用する場合、Stable Diffusion OnlineやLeonardo.aiのような無料サービスを使えば、簡単に画像生成を体験できます。毎日付与される無料クレジット内であれば誰でも利用可能で、環境構築なしに画像生成が可能です。ただし、使用できるモデルや細かな設定には制限があります。

一方で、ConoHa AI Canvasは無料プランこそありませんが、Stable Diffusion WebUIやComfyUIといった高度なツール群をクラウド環境上でそのまま利用できます。LoRAや各種モデルの導入も自由に行えるため、ローカルに近い柔軟なカスタマイズ性と生成品質が求められるユーザーには適しています。

\ MiraLab AIの読者限定で500円割引適用中 /

MidjourneyとStable Diffusionの8項目比較まとめ

画像生成AIの代表格であるMidjourneyとStable Diffusionは、それぞれ特徴や強みが異なります。

操作性やカスタマイズ性、料金体系、著作権ポリシーなど多角的に比較することで、自分に合ったツール選びの参考になるでしょう。以下の表で主な違いを簡潔にまとめています。

| 比較項目 | Midjourney | Stable Diffusion |

|---|---|---|

| 画像のクオリティ・スタイル | 見栄え重視、印象的・自動調整が強い。動画的フレーミングも進化中。 | モデル依存。カスタムモデルやLoRAで多様な画風に対応可能。 |

| 論理構造・プロンプト忠実性 | 絵作りが得意なカメラマン的。柔軟だが細部は曖昧な傾向。 | エンジニア的にきっちり仕事。レイアウトや構図忠実度が高い。 |

| モデル構造・学習自由度 | モデル非公開・ユーザー学習不可。限定的なStyle Tunerあり。 | オープンで拡張自在。LoRA・VAE・ControlNetでカスタマイズ可能。 |

| 操作性・ワークフロー効率 | Discordベースで直感的。手軽で即効性が高い。 | 多様なGUI/WebUIあり。慣れが必要だが多機能で柔軟な操作が可能。 |

| 生成速度・環境依存 | クラウド処理でPCスペック不問。プラン依存で速度・同時処理数変動。 | 基本ローカル実行。高性能GPU推奨。クラウド版もあり導入ハードル低減。 |

| 料金体系・コスト | 月額サブスク制。プランにより生成枚数や優先度が異なる。 | 基本無料(オープンソース)。ローカル構築時に初期費用が発生する。 |

| 著作権・商用利用ポリシー | 商用利用可能だが利用規約厳格。禁止事項あり。 | 著作権はユーザー帰属。派生モデルのライセンスに注意が必要。 |

| コミュニティ・サポート | 公式Discord活発。初心者に優しい。 | 技術系コミュニティ豊富。情報多いが初心者にはややハードル高い。 |

| 導入ハードル・柔軟性 | 完全クラウドで簡単導入。PCスペック不問だがネット必須。 | ローカル構築が基本。自由度が高いが設定に知識必要。クラウド版も存在。 |

MidjourneyとStable Diffusionのアップデートと将来性

AI画像生成は日進月歩で進化しており、MidjourneyとStable Diffusionも例外ではありません。

ここではアップデートの頻度や将来の展望に注目して比較します。

Midjourneyのアップデートと将来性

MidjourneyはV5からV7へと段階的に大きなアップデートを重ねてきました。特に最近はビデオモデルも登場しプロンプトから動画生成が可能になり、3D生成にも展開予定と発表されています。

このように、Midjourneyは生成品質の向上だけでなく、多様なメディア展開を視野に入れたプロダクト開発が進んでいるのが特徴です。

アップデートは公式が一括管理しており、ユーザーは常に最新機能をすぐに利用可能です。新しい表現技術やUI改善も随時行われており、サービスとしての成長速度は速いと言えます。

Stable Diffusionのアップデートと将来性

Stable Diffusionはオープンソースとして多くの研究者やコミュニティにより進化が続けられています。基本モデル(SDXL 1.0)自体のアップデートは比較的ゆるやかですが、ユーザーがLoRAやカスタムモデルで多様な拡張を行うエコシステムが活発です。

また、GUIツールもAUTOMATIC1111やComfyUIをはじめ多様化しており、今後の主流はComfyUIに移行しつつあります。このため、Stable Diffusionの強みは「自由度の高い拡張性とカスタマイズ性」にあり、用途に応じて柔軟に進化し続ける点です。

目的別で見る!MidjourneyとStable Diffusion、どっちがおすすめ?

画像生成AIを選ぶとき、「自分の使い方や環境に合ったツールはどっち?」と迷うことは多いはずです。

ここでは利用シーンやユーザータイプ別に、MidjourneyとStable Diffusionの選び方をわかりやすく解説します。

クリエイターにはどっちが最適?表現重視の選び方

クリエイターの方は、「直感的に操作できて高品質な画像を手早く得たい」場合はMidjourneyがおすすめです。特にアートや広告、コンセプトデザインなど、幅広いスタイル表現が求められる場面で強みを発揮します。

一方、細かい画風調整や独自モデルの導入をして独特な表現を追求したいならStable Diffusionが向いています。LoRAなどの技術を使って自分好みのスタイルを作り込むことも可能で、自由度の高さが魅力です。

開発・研究で使うなら?エンジニア視点の選び方

エンジニアや研究用途では、モデルやパラメータのカスタマイズ性、自由に改変できる点が重要です。この点で、Stable Diffusionはオープンソースで多くの拡張が可能なため最適です。

Midjourneyはクラウドサービスとして手軽ですが、内部構造がブラックボックスで細かな調整はできません。研究目的や技術検証、学習データの追加などにはStable Diffusionが圧倒的に向いています。

PCスペック別おすすめツールは?環境に合った選び方

PCスペックによっては使いやすさや快適さに差が出ます。グラフィックボードを搭載したハイスペックPCを持っているなら、Stable Diffusionのローカル実行で高速かつ柔軟に使えます。

一方、PCスペックが低い場合や手間なくすぐに使いたいならMidjourneyのクラウド利用がおすすめです。

ローカル環境の構築が難しい、または高性能PCが手元にない場合は、Stable Diffusion OnlineやLeonardo.ai、ConoHa AI Canvasなどのクラウド型Stable Diffusion環境を利用する選択肢もあります。

環境構築の知識がなくても、直感的なUIからすぐに生成を始められるため、初心者にも導入しやすいのが特徴です。

まとめ

MidjourneyとStable Diffusionは、それぞれ異なる強みと特徴を持つ人気の画像生成AIツールです。

Midjourneyは操作が簡単で高品質な画像生成が手軽にできること、またV7から動画生成や3D展開が進んでいる点が魅力です。

一方、Stable Diffusionはオープンソースならではの自由度と拡張性、ユーザー自身でモデルを選び・カスタマイズできる点が強みです。

Midjourneyが向いているのは、手軽に高品質な画像を生成したいクリエイターや初心者の方です。複雑な設定なしで多彩なスタイルの画像が作れるため、アイデアをすぐに形にしたい場面に適しています。

一方、Stable Diffusionが向いているのは、細かなカスタマイズや独自の研究開発を行いたいエンジニアや上級者です。モデルの拡張性や自由なワークフロー構築が可能な点が大きな強みです。

この記事で紹介した違い・比較ポイントを参考に、ご自身のニーズや環境に合った選択をしてください。

あなたに最適な画像生成AIが見つかることを願っています。