テンセントは5月28日、単一の画像と音声クリップだけで人物が自然に話したり歌ったりする動画を自動生成できるオープンソースモデル「HunyuanVideo-Avatar」を公開しました。ポートレート写真をアップロードし、最大14秒の音声を与えるだけで、高精度な口パクや表情、全身の動きを持つアバター動画を生成できるのが特徴です。

🚀 Introducing HunyuanVideo-Avatar, a model jointly developed by Tencent Hunyuan and Tencent Music, bringing photos to life.

— Hunyuan (@TencentHunyuan) May 28, 2025

✅ Upload a photo + audio — auto-detect scene context & emotion, then generate lifelike speech/singing with dynamic visuals.

✅ Supports multi-style,… pic.twitter.com/pTh2T7Xwgn

モデルの中核にはマルチモーダル拡散トランスフォーマー(MM-DiT)が採用され、キャラクター画像インジェクションで人物一貫性を保ち、Audio Emotion Moduleが音声の感情を細かく解析して表情やジェスチャーに反映します。さらにFace-Aware Audio Adapterにより、複数キャラクターの同時生成でも互いの音声が干渉しません。

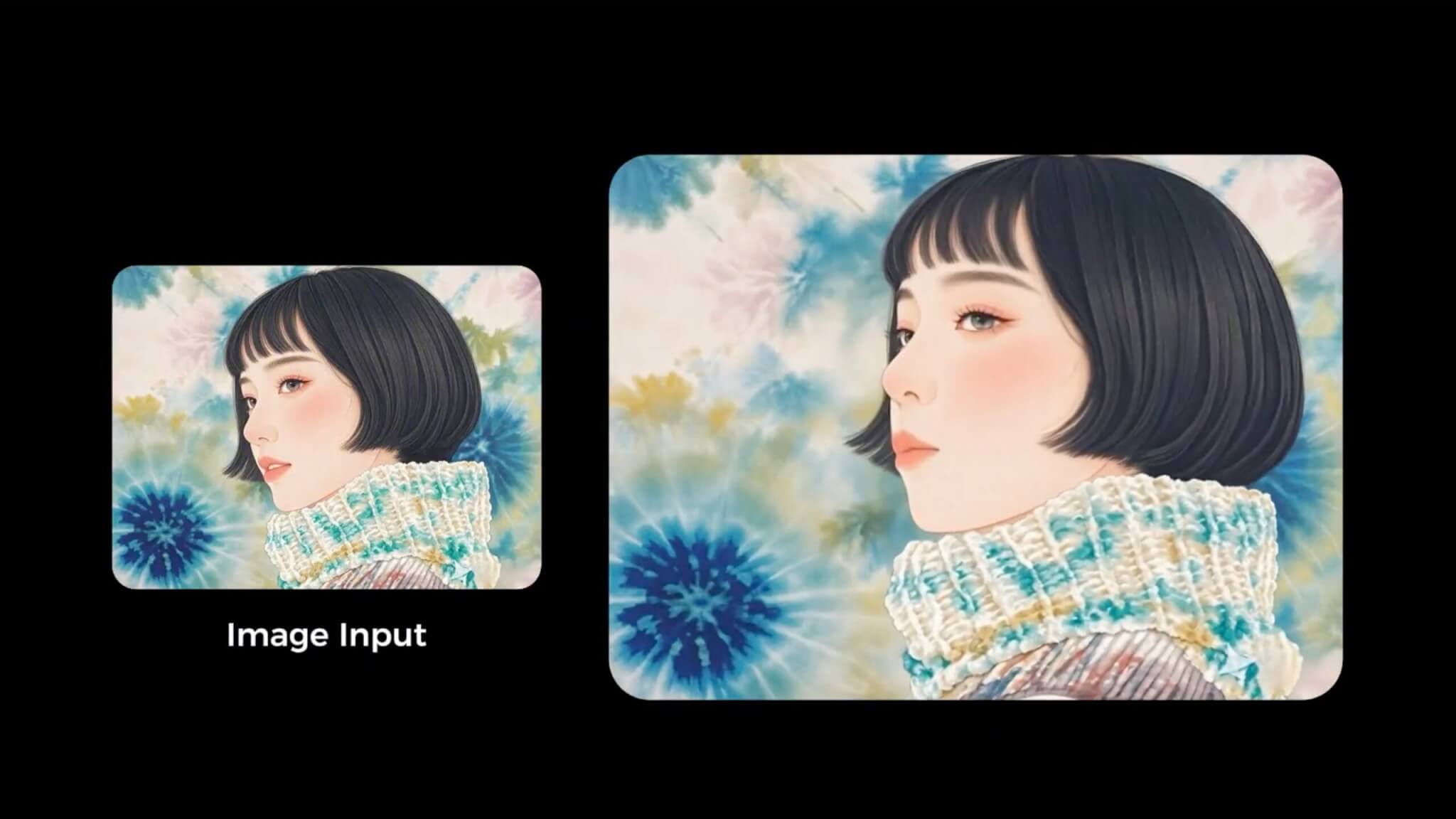

生成スタイルはフォトリアル、アニメ、3D、擬人化など多岐にわたり、頭部・半身・全身スケールを自由に切り替えながらダイナミックなモーションを維持します。

ハードウェア面では、公式READMEが推奨GPUをVRAM96 GBと示しており、高解像度・高フレームな動画を快適に生成するにはかなりの演算資源が求められます。ただし解像度を下げれば24 GB程度でも動作し、ComfyUIのタイル化ワークフローを使えば8〜16 GBの一般的なGPUでも時間をかけて推論する事例が報告されています。

ソースコードと学習済み重みはGitHubおよびHugging Faceで無償公開され、DockerイメージやGradioデモも用意されています。短尺動画制作、EC広告、ライブ配信でのバーチャル司会など、商用・クリエイティブ双方での利用が期待されており、公開直後から開発コミュニティの注目を集めています。