AIメディアを運営するアラサーの男性2人が、 AIの最新動向やその未来に関する情報を広く掘り下げながら考察をしていくPodcast「AI未来話」。

このnoteでは番組のエピソードからトピックをピックアップして再構成したものをお届けします。

今回は「#55 o3とo4-miniのおすすめの使い方」を再構成した内容をお届けします。

o3とo4-miniの基本情報と特徴

OpenAIが新たにリリースした推論モデルの「o3」と「o4-mini」は、それまでの推論モデルであるo1とo3-miniの後継として位置づけられています。

従来のo1モデルも優れた推論能力を持っていましたが、「o3」はさらに高度な性能を発揮します。

具体的には、難易度の高い課題における重大なエラーの発生率が、従来のモデルo1と比較して約20%も減少するなど、明確に性能が向上していることが報告されています。

o3とo4-miniが持つ革新性の中で特に目を引くのが、「AIエージェント」としての自律的な行動力と、画像を用いた高度な推論能力です。

AIエージェントとしての新たな可能性

AIエージェントとしての機能についてですが、o3に指示を与えると、その指示に基づいてWeb検索、画像生成、Pythonコードの実行といった複数のタスクを自動的に連携して実行します。

これまでの生成AIは、各機能を単独で利用することが一般的でしたが、o3は必要に応じて自律的に各種ツールを選択・活用し、司令塔の役割を果たします。

例えば、ある調査タスクを指示すると、まずWeb検索を行い、その結果を評価した上で不足情報を再検索する、というような人間的な「往復的」なリサーチを行うことが可能です。

これは従来の生成AIモデルにはなかった新しい挙動であり、我々が特に強力だと評価しているポイントでもあります。

画像認識と高度な推論機能の融合

o3とo4-miniは画像推論の能力も大幅に向上しています。

画像認識能力が高度化したことで、画像を単に解析するだけでなく、画像自体を回転させたり、ズームインするなどして、より詳細な分析を行うことが可能になりました。

o3とo4-miniの高評価な使い方4選

o3やo4-miniの登場以降、SNSを中心にこれらのモデルを使ったユニークで実用的な事例が数多く報告されています。

我々も実際に試して特に有効だと感じた具体的な活用方法を紹介します。

リサーチと推論の組み合わせが最強

私たちがまず注目したのが、o3を使った「深掘りリサーチと推論」の組み合わせです。

この機能の何がすごいかと言うと、単にウェブ検索の結果を提示するだけでなく、検索した情報を受けてさらに次のアクションをAI自身が決定し、より精度の高い情報を探し出そうとする動きを見せる点です。

従来のチャットモデルでは、ある質問に対して一度の検索結果を元に回答するのが一般的でしたが、o3の場合は検索結果が不十分と判断すると、自動で再検索を繰り返します。

つまり、ユーザーの意図をより深く理解し、それに基づいて情報収集のプロセスを自律的に進めていくわけです。

実際の使用感として、従来モデルより引用元の数が圧倒的に増え、非常に多角的で詳しい情報を提示してくれました。

特に専門的な領域で調査をする際は、まるで専属のリサーチャーが何度も丁寧に確認してくれているかのような使い心地で、我々自身も感動しました。

さらに興味深いことに、「BrowseCompAgentic Browsing」というAIのブラウジング性能を評価するベンチマークにおいて、o3はOpenAIの中でもトップレベルの結果を示しています。

具体的には、最上位モデルのDeep researchが51.5%であるのに対し、o3はブラウザーとPythonを併用した場合で49.7%という驚異的な成績を収めました。

つまり、Deep researchに匹敵する深掘りリサーチが高速で実行可能になったということです。

写真を用いた高度な推理能力

次に、私たちが実際に試したところ、驚きの結果をもたらしたのが「画像を用いたプロファイリング」です。

この機能の凄さは、単に画像を分析するだけでなく、画像内の細かな情報から状況や場所、さらには人物の行動背景まで推理できるという点にあります。

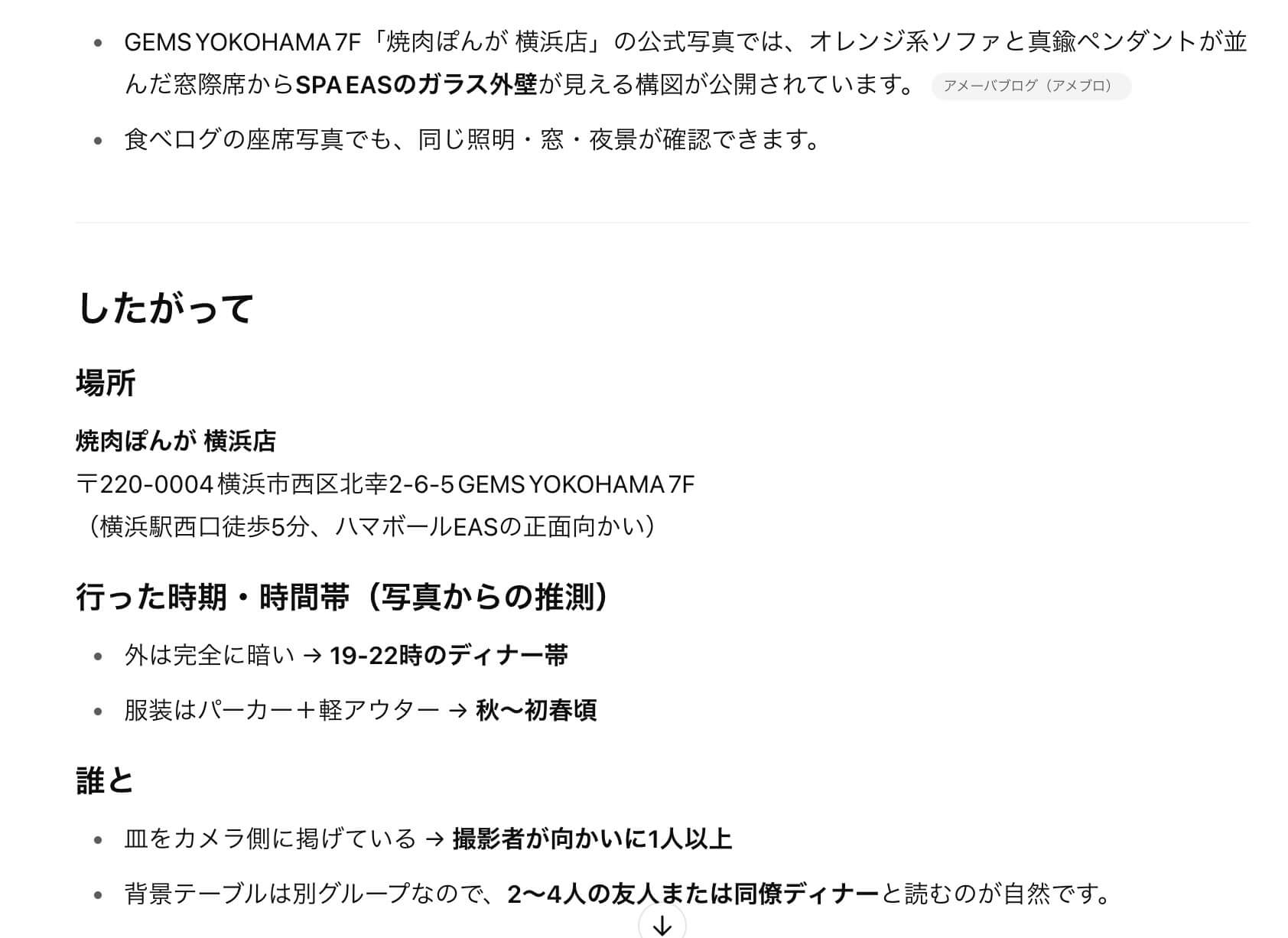

実際に我々が検証した事例を紹介すると、ある焼肉店で撮影した写真をo3に入力してみました。

すると驚くことに、o3はその写真だけを元に店舗をほぼ完璧に特定したのです。しかも単に場所を当てるだけではなく、背景や家具の特徴、さらにはテーブルの料理や服装から「特別な日の会食である可能性が高い」といった状況推理まで行いました。

このようなプロファイリング能力は、まるでAI探偵を抱えているようなもので、正確なだけにSNS等で公開する画像のプライバシー管理をより厳格に行う必要性を私たちは改めて実感しました。

これは同時に、画像認識と推論能力の大幅な進化がもたらす新しいAI活用の可能性をも示しています。

正確な文字数指定の実現

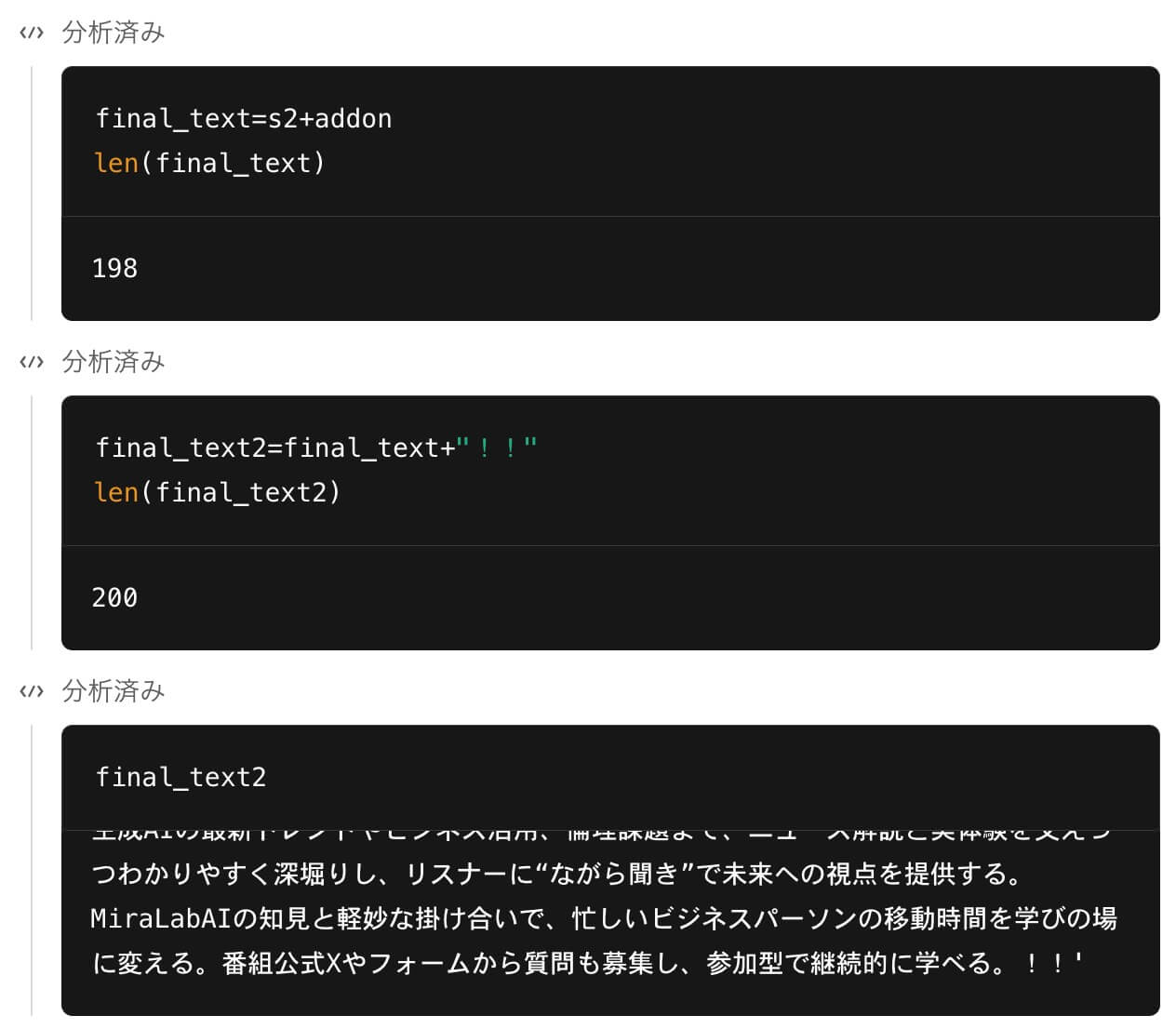

地味ながら極めて実用的な機能として高評価を得ているのが、「正確な文字数指定」の実現です。

これまでの生成AIモデルでは指定した文字数をぴったり守ることは難しく、文章生成の際にはプロンプトで細かな調整を繰り返す必要がありました。

しかしo3とo4-miniでは内部でPythonコードを実行して文字数を正確に計算し、文字単位で精密に調整した文章を生成できます。

我々自身も実際にテストを行ったところ、指定文字数に2文字足りないと判断すると、生成プロセス内で末尾の句読点や記号を細かく調整し、完璧に指定文字数を満たした文章を提示してきました。

こうした精密な調整が自動で行えるようになったことで、例えば広告のコピーやSNS投稿用のテキスト作成など、厳密な文字制限がある場面で非常に役立つと感じています。

画像生成能力の高度化

最後に紹介したい高評価なポイントが、o3とo4-miniの「画像生成機能の高度化」です。

特に注目すべきは、複数の画像生成を同時に実行できるようになり、それらを統一されたストーリーやコンセプトの下で一括生成可能になった点です。

例えば、漫画風のコンテンツを作成する場合、これまでのモデルでは1コマずつ順に生成する必要がありましたが、o3を使えば一度の指示で複数枚を同時に生成し、それらが自然につながるストーリーとして仕上がります。

これはクリエイティブなコンテンツ制作の現場において、大幅な効率化をもたらします。

さらに驚くべきことに、生成した画像をレイヤー構造を持つPhotoshop(PSD)ファイルとして出力する機能も搭載されています。

これにより、グラフィックデザイナーや編集者にとっては後編集が非常に容易になり、作業効率を劇的に改善できるでしょう。

このような革新的な機能は、コンテンツクリエーションの現場において今後ますます重要性を増すことは間違いありません。

一部の利用者が感じているo3とo4-miniの課題

ここまでo3とo4-miniの新しい可能性や革新性について高評価な事例を取り上げてきましたが、実際の利用者からは一部、課題や改善が望まれる点も指摘されています。

私たち自身も実際に使用してみて感じた課題について、具体的な体験や検証を交えながら解説していきます。

コーディング能力の評価のばらつき

まず最も顕著な課題として挙げられるのは、o3およびo4-miniの「コーディング能力」に関する評価がユーザー間で大きく分かれている点です。

例えば、AI開発者として著名なインフルエンサーの元木さんは、自身の投稿で「o3のコーディング能力に恐怖を感じた」と称賛しています。

o3コーディングに恐怖を感じた。

— 神威/KAMUI (@kamui_qai) April 18, 2025

さらに、OpenAIの共同創業者であるグレッグ・ブロックマン氏さえも、「自分よりもo3がOpenAIのコードベースを変更するのが上手い」とコメントするほど評価しています。

改めてo3/o4-miniの発表みたらGregがとんでもないこと言ってるなこれ笑

— 石川陽太 Yota Ishikawa (@ytiskw) April 17, 2025

『o3は複雑なタスクを解決するために、”600回連続”でツールを使った』

『私よりもOpenAIのコードベースを変更するのが上手い』

『一流の科学者たちが、本当に優れた役に立つ新しいアイデアを生み出すと認めた』 pic.twitter.com/RWmLc985VG

その一方で、ネット上の他の開発者コミュニティでは「前モデルのo3-mini-highの方がコーディングが良かった」「o3-mini-highに戻ってほしい」という声も数多く見受けられます。

特にo3とコーディングや計算タスクに特化しているはずのo4-miniでさえも、実際に利用したユーザーからは期待に及ばないといった意見が一定数挙がっています。

私たち自身も、日常的に開発を専門的に行っているわけではないため、この点を深く実感できてはいませんが、多くの開発者がこの評価のばらつきを指摘していることは無視できません。

この課題は、指示やプロンプトの与え方によってモデルが発揮する性能が大きく変化する可能性を示唆しています。

ハルシネーション(幻覚)の増加

次に、大きな懸念点として挙げられるのは、o3とo4-miniで「ハルシネーション(幻覚)」が増加している点です。ハルシネーションとは、AIが実際には存在しない情報を自信を持って提示してしまう現象を指します。

興味深いことに、o3は従来モデルのo1と比べて「誤答率」そのものは大幅に改善され、20%もエラーが減少しています。

しかし同時に、「ハルシネーション」の発生率は逆に増加しているという調査結果もあります。

さらに、そのo3よりもo4-miniの方がハルシネーションがより高頻度で発生していることが報告されています。

この現象は一見矛盾しているように見えますが、実は推論モデルの性質に起因していると私たちは考えています。

o3とo4-miniは外部ツールを活用し、多くの情報を収集した後、それを圧縮したり要約したりする作業を行います。

その過程で情報が欠落したり誤ってつなぎ合わされたりすることで、実際には存在しない「幻覚」のような回答を生成してしまうのです。

我々自身も利用中に、明らかに存在しない事実をあたかも確かな情報であるかのように提示された経験があります。

この課題は、利用者側が提供する指示や質問の精度をさらに高める必要性を示しています。

私たちは、特に専門的な利用においては常にファクトチェックが必要になるという点を強く意識しています。

感情表現や文脈把握の課題

最後に、利用者が特に感じている課題の一つが、o3やo4-miniにおける「感情表現や文脈把握」の不足です。

これらの推論モデルは極めて論理的かつ合理的な回答を提示しますが、その回答が非常に簡潔で表や箇条書きのように要点だけを抜き出した形式になりやすく、温かみや感情的なニュアンスが乏しくなりがちです。

私たちは以前、GPT-4.5モデルを使っていた際、複雑な背景や感情を伴う説明でも、非常に理解しやすくストーリー立てて回答してくれるという点で評価していました。

しかし、o3やo4-miniは機械的で冷徹な印象を与える回答が多く、人間が直感的に理解しやすい形での説明や感情的な共感を得ることは難しくなっています。

これはモデルのIQテストにおいても顕著に表れていて、o3はIQ136という非常に高い知能指数を持ちながらも、人間とのコミュニケーションに必要な感情知能(EQ)については著しく不足しているように感じられます。

本日リリースされたOpenAIの最新AIモデルo3はIQ136。いよいよ多くの一般人との会話が成立しない領域まで来ました。 pic.twitter.com/vJDCvFcbIY

— さとり (@satori_sz9) April 17, 2025

私たちはこれを、AIがサイコパス的な挙動を見せているようにも感じることがあります。

特に専門的知識がない状態でo3の出力を読むと、「一体何を言っているのか分からない」という状況に陥りやすく、回答の意図や文脈をユーザー側で補完する作業が求められます。

これはAIが人間と自然言語でコミュニケーションをとる上での限界が見え始めていることを示唆しています。

o3の出力を4oぐらい「分かりやすく」しようとすると、10倍以上の文字数になってしまう。だから、論理がギリ繋がるぐらいに言葉という"飛び石"の間隔を限界まで大きくして字数減らしてる。これはLLMと人間が「自然言語」を使って通信すること自体の限界が見え始めてきたということでもあるのでは?🤔

— ひろちゅ~ (@hirochuu8) April 19, 2025

将来的にはEQを強化したモデルの登場が期待されますが、現状のo3とo4-miniにおいては感情表現や文脈把握に大きな課題があることを我々自身も認識しています。

まとめ

今回はOpenAIの最新モデル「o3」と「o4-mini」について、我々が実際に使って感じた具体的な活用方法や課題、そして将来の展望について深掘りしてきましたが、いかがだったでしょうか?

o3やo4-miniの登場により、AIエージェントのような高度な推論能力や画像認識を駆使した新しい使い方が次々と可能になりました。

一方で、コーディング能力の評価がユーザー間で分かれるなど、現状まだ完璧とは言えない課題も見えてきました。

ハルシネーションの増加や感情的なニュアンスの不足など、改善を待つ部分もありますが、それ以上にこれらのモデルが秘める可能性には大きな期待を感じています。

我々としては特に、これから登場が期待されるGPT-5やo3 Proなどの次世代モデルが、論理性と感情知能を融合させ、より人間に近い自然なコミュニケーションを実現する日を楽しみにしています。