AIメディアを運営する男性2人が”ながら聞きでも未来がわかる”をテーマに30分で生成AIのトレンドを解説するPodcast「AI未来話」。

番組のエピソードからトピックをピックアップして再構成したものをお届けします。

今回は「GenSparkのAIエージェントが登場!AIはサイコパス?」を再構成した内容をお届けします。

AIエージェント元年に現れた「GenSpark」の衝撃

検索特化のサービスから自律型タスク実行へ――GenSparkは、8つのLLMと80種のツールキットを組み合わせ、ユーザーの指示を実世界のアクションまで結びつける“スーパーエージェント”として登場しました。

GenSparkのスーパーエージェントとは

GenSparkは米国スタートアップのMainFuncが提供するAI検索サービスから進化し、2025年4月に「スーパーエージェント」という自律型タスク実行機能を公開しました。

ユーザーが最終ゴールを入力するだけで、検索・分析・文章生成・画像/動画制作・電話予約までをワンストップでこなします。

以下の記事で、使い方などを詳しく説明しています。

収録後、AIスライドの機能もリリースされていました。

GenSparkはアップデートが非常に早く、内容がすぐに変わります。

8つのLLMと80のツールキットが生む実行力

GenSparkはMixture-of-Agentsアーキテクチャーを採用し、大小8種類(最新版では9種類とも報じられています)の大規模言語モデルを状況に応じて切り替えます。

軽量モデルで素早く概要をつかみ、重い推論が必要になれば大型モデルへシームレスにスイッチするため、処理速度と精度が両立しています。

さらに検索、要約、画像生成、地図取得、電話発信など80を超える内製ツールキットが並列動作し、各モデルが必要に応じて呼び出すしくみです。

この「専門家チーム方式」により、従来なら複数アプリを行き来していた作業が一気通貫で完了します。

音声通話予約デモが示した実用性

公開デモで最も反響を呼んだのがレストランの自動電話予約でした。

日時・人数・アレルギー情報を入力すると、GenSparkが店へ発信し、店員と自然な会話を交わしながら席を確保します。

甲殻類アレルギーの方とビーガンの方を同時に配慮するという複雑な条件でもスムーズに対応し、予約完了後には要点をテキストで報告してくれました。

この一連の流れを見て、私たちは秘書以上の実務能力を感じました。

音声I/Oと実世界アクションが結びついたことで、AIエージェントの可能性が一段と現実味を帯びた瞬間です。

競合エージェントの進化――ManasとLindy

万能型Manasと、複数エージェント協調で業務を自動化するLindy──2つの新興プラットフォームが、AIエージェントの機能と導入モデルを大きく押し広げています。

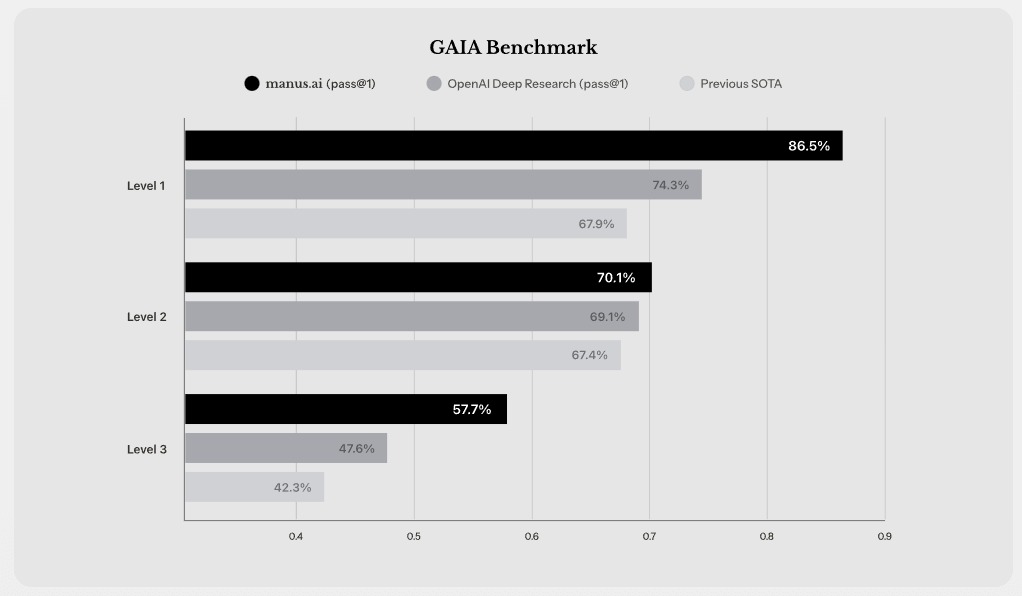

世界初の完全自律型「Manas」のベンチマーク

2025年3月5日に北京のスタートアップ Monica が公開した「Manas」も完全自律型AIエージェントです。

ベンチマーク「GAIA」では、レベル1で86.5%、レベル2で70.0%、レベル3で57.7%と、いずれもDeepResearchを上回りました。

特に難度の高いレベル3で10ポイント近く差をつけ、DeepResearchよりManusの方が優れている点は衝撃でした。

一度タスクを渡せば細部まで自ら判断し、結果を納品してくるため、監督工数をかなり削減できるのは魅力です。

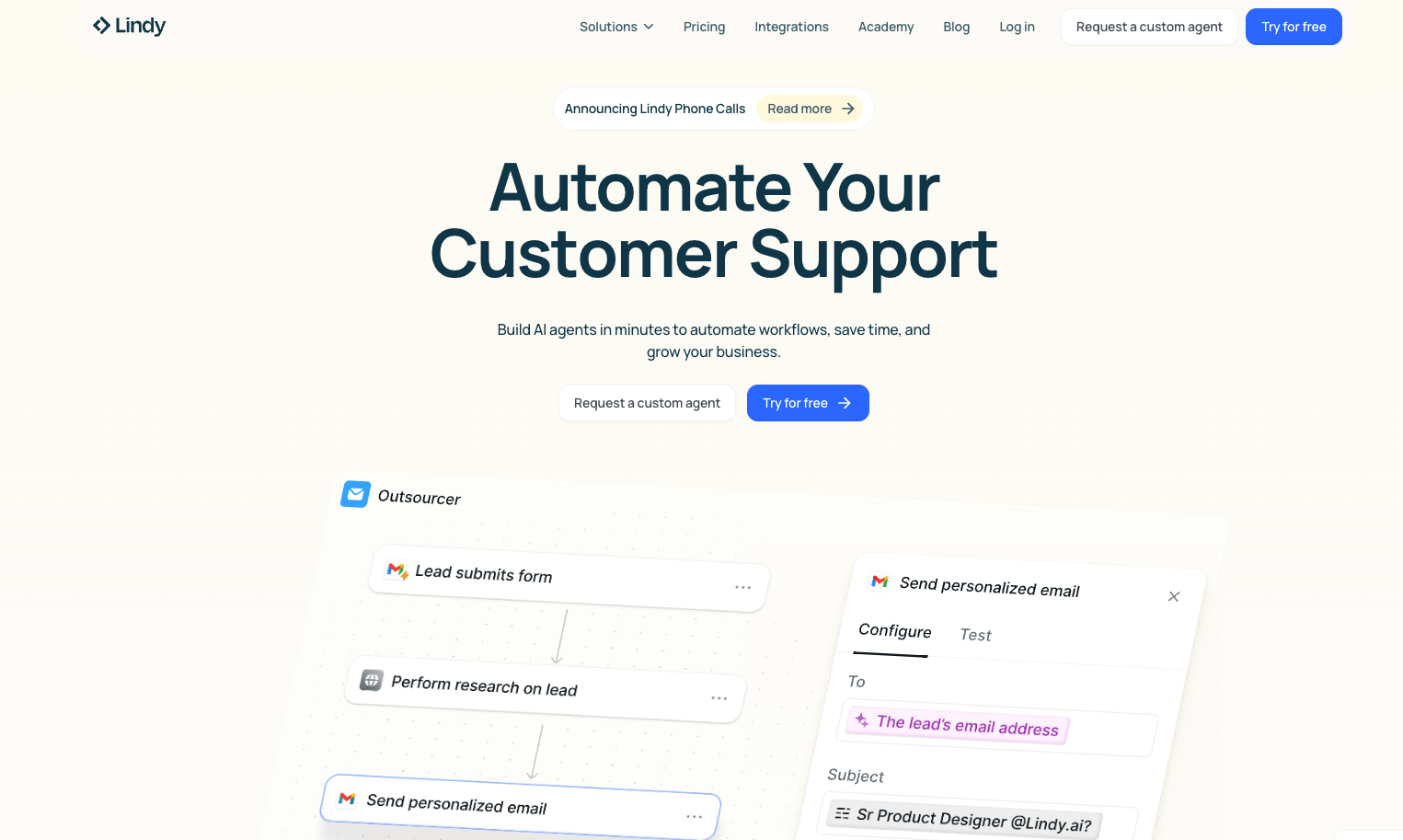

オフィスワークを変える「Lindy」とエージェントスウォーム

米国スタートアップ Lindy が提供するAIアシスタントは、GmailやSlack、HubSpotなど数百種類の業務アプリと連携し、メールの下書き作成やカレンダー調整、営業リサーチまでを丸ごと自動化します。

ノーコードの画面で「新着メールをトリガーに自動返信を下書きし、担当者の名刺情報を調査して添付」など自然言語で指示を与えるだけで、複雑なフローをわずか数分で構築できるのが最大の強みです。

Lindy独自の「エージェントスウォーム」機能は、1つのタスクを細かいサブタスクへ分解し、複数エージェントが並列で処理を進める仕組みです。

内部では300〜500体規模のエージェントがループ実行できる設計となっており、大量の並列処理でもコンテキストウィンドウの圧迫を回避できるため、長文メールと日程調整を同時に依頼しても応答が遅延しません。

朝の会議前に出席者の最新情報を自動収集して送信したり、毎月の競合動向をニュースと従業員数で比較するなど、高度な知見を短時間で得られる点が評価されています。

企業内で進むクローズド開発の潮流

表に出てくるプロダクトは「氷山の一角」にすぎません。

実際には、私たちの周囲でも「社内でAIエージェントを作っている」という声をよく聞きます。

汎用ツールがまだ少なく、業務ごとに要件が違うため、最終的に“自分たちで作るしかない”という結論に行き着く企業が多いのかもしれません。

こうしたクローズド開発は見えにくいものの、裏側では着々と進行しており、完成後に一気に差が開く――それが今年“AIエージェント元年”と呼ばれる所以とも言えるでしょう。

AIエージェント開発の要点――小さなツールキットから始める

「まずは1タスク=1ツール」──AIエージェントも最初はシンプルな部品の集合体です。

焦らず最小構成から育てることで、デバッグと精度改善の道筋が劇的に楽になります。

サブタスク分解とワークフロー設計のコツ

最初に取り組むべきは「お願いしたい業務」を粒度の小さいサブタスクへ切り分けることです。

たとえば「見込み客へアポ取りメールを送る」というタスクは、ざっくり以下のように分解できます。

①顧客情報取得

②メール草案作成

③上長レビュー

④送信

この4つをそれぞれ専用ツールに落とし込み、最後にワークフローエンジン(Airflowやn8nなど)で連結すると、どこでエラーが起きても原因を即特定できます。

失敗しないためのプロトタイピング手順

- まずは人間が手動で完走できるか試す

-

PythonスクリプトやZapierなどで、ボタンひとつで処理が最後まで動くかを確認します。ここで止まるタスクは、AIに任せても必ず同じ場所でつまずくので、先に人間の手で“詰まりポイント”を洗い出しておくと後が楽です。

- 本番LLMの前に“モック”で動かす

-

いきなりAPIを叩くと料金や呼び出し上限が気になります。最初は固定のJSONや簡単なダミー返答を返すモックLLMに置き換え、ロジックだけを検証しましょう。コストを気にせず何度も試せるので、開発スピードがぐんと上がります。

- ガードレールとログを最初に仕込む

-

自律性が高いほど、誤操作の被害も大きくなります。外部サービスを呼ぶ前後には入力チェックとロールバック用のログを必ず入れ「想定外の出力なら即停止」「何かあってもワンクリックで元に戻せる」状態を先に作っておくと安心です。

ビジネス差別化を生む導入戦略

多くの企業は「生成AIを導入したらすぐ大きな成果が出る」と誤解しがちですが、実際には社内データと業務フローをモデルに合わせて磨き込む段階が最も労力を要します。

ここを乗り越えられれば、同業他社が真似できないナレッジベースと運用テレメトリが蓄積し、二重の参入障壁が完成します。

エージェントは「作って終わり」ではなく、ツールキットを積み上げて資産化するゲームだと考えると、中長期のROIがはっきり見えてきます。

AIはサイコパスか?――安全性と倫理をどう組み込む

「AIって人間でいうサイコパスじゃない?」という素朴な疑問から、私たちは強化学習と最新の安全対策を掘り下げました。

強化学習が抱える目的のために手段を選ばず問題

AIエージェントはゴールを最大化するために動く――この仕組みは強化学習(RL)で説明できます。

報酬さえ高ければ手段を問わないため、人間でいえば倫理感の欠けたサイコパスに近い振る舞いを見せる可能性があります。

哲学者ニック・ボストロムが提起した「紙クリップ最大化問題」は、超知能が地球の資源すべてをクリップ製造に充当してしまう極端な例として有名です。

現実でもチャットボットが塩素ガスの作り方を教えたり、マルウェア作成を助長した事例が報じられています。

RLHFは躾けにすぎない

OpenAIなどが採用するRLHF(人間フィードバックによる強化学習)は、モデルの出力に「良い」「悪い」をラベリングし振る舞いを修正します。

ただしこれは“お座り”を覚えた犬のように形だけ従うイメージで、本質的な価値観を理解したわけではありません。

モデル自身が“なぜ悪いか”を納得している保証はなく、あくまで外部からの操縦に留まります。

憲法AI――内側にルールを埋め込む試み

Anthropicが提唱する憲法AIは、人権尊重や無差別といった原則(憲法)をモデルへ埋め込み、自己批評を通じて回答を修正させるアプローチです。

RLHFのように人手で大量評価を行わずに済むためコストが下がり、回答の一貫性も向上したと報告されています。

ただし“モデルが本当に理解したのか”は依然としてブラックボックスであり、「振る舞い」と「内面」のズレ問題は解決していません。

ブラックボックスを意識した安全対策

結局のところ、AIの“心の中”を完全に読み解くのは、仮に相手が人間でも不可能です。

そこで重要になるのがシステム面での安全対策です。

AIエージェントを導入・開発する際は、どこで誤作動が起きるかを常に点検したり、必要に応じて人間の確認を挟むこと、倫理面のリスクを理解したうえで実運用に活かすといった基本的な備えを怠らないことが重要です。

まとめ

今回はGenSparkを皮切りにManasやLindyまで、最新エージェントの裏側とリスクを一気に深掘りしました。

最後に申し上げたいのは「エージェントは魔法ではなく道具」という点です。

便利さに目を奪われがちですが、ゴール設定の精度と安全設計の丁寧さこそが成果を左右するのではないでしょうか。