AIメディアを運営するアラサーの男性2人が、 AIの最新動向やその未来に関する情報を広く掘り下げながら考察をしていくPodcast「AI未来話」

このnoteでは番組のエピソードからトピックをピックアップして再構成したものをお届けします。※この記事は98%が「Claude 3.5Sonnet」で執筆しています。

今回は「#18 AI犯罪から身を守ろう!各国の法整備の現状と声を上げる大切さ – 後編」を再構成した内容をお届けします。

AI犯罪対策:個人レベルでの限界と既存対策の重要性

AIの発展により犯罪手法が高度化していますが、個人レベルでの対策は従来のものが中心となります。

ここでは、AI時代においても変わらない基本的な対策の重要性を再確認しましょう。

フィッシング詐欺とディープフェイク詐欺への対応

前編で説明したように、AIの発展により金融犯罪が高度化しています。

※前編の記事はこちらから↓↓↓

特にフィッシング詐欺やディープフェイクを使った詐欺が問題となっています。これらに対する基本的な対策を確認しましょう。

フィッシング詐欺は、基本的にメールやWEB、SNSから始まることが多いため、以下の対策が効果的です。

- メールやSNSのリンクを直接クリックしない

- ブックマーク(お気に入り)に登録された正規のURLを直接入力して使用する

- 不審な添付ファイルは開かない

ディープフェイクによる詐欺に対しては、「ダブルチェック」が重要です。

例えば

- オンライン会議で重要な決定をした後、別の連絡手段(電話など)で再確認する

- 振り込みなどの重要な取引前に、直接本人に確認の連絡をする

本来のダブルチェックは2人体制で行うものですが、個人レベルでは上記のような方法で確認を徹底することが大切です。

法人の場合は、ディープフェイク検出ツールの導入も一つの有効な手段です。

海外では既にこうしたツールが開発されており、導入は以前としてハードルは高いですが、法人向けのソリューションとして提供されています。

知的財産権侵害とサイバー攻撃への備え

AIによる知的財産権侵害やサイバー攻撃に対しても、基本的な対策を怠らないことが重要です。

- 個人情報の公開範囲を最小限に抑える

- 強力なパスワードを使用し、定期的に変更する

- 二段階認証を積極的に利用する

- ソフトウェアを最新の状態に保つ

性犯罪関連の注意点

AI生成による違法コンテンツに対しては、これまで以上に注意が必要です。

- 違法コンテンツに絶対に触れない、近づかない

- 不審なサイトやアプリを利用しない

これらの対策は新しいものではありませんが、AI時代においてはより一層の注意と徹底が求められます。

しかし、個人の努力だけでは限界があることも事実。

技術の進化に伴い、犯罪手法も日々変化しているため、個人での対応には常に限界がつきまといます。

社会全体での包括的な取り組みの必要性

個人レベルの対策だけでは不十分であることを踏まえ、各国ではAI犯罪に対する法整備が進められています。

ここでは、主要国の取り組みを見ていきましょう。

EUのAI規制法:3つのリスクレベルと罰則

EUでは2024年5月21日、世界初となる厳罰付きAI規制法が成立しました。この法律はAIシステムを3つのリスクレベルに分類し、それぞれに応じた規制を設けています。

- 禁止AI(許容できないリスク):完全に禁止

- 認知をゆがめるサブリミナル技術

- 年齢や障害など脆弱性の利用

- 公的機関が様々なデータを集めて個人を評価する「ソーシャルスコアリング」

罰則:最大3500万ユーロまたは年間総売上高の7%の罰金

- 高リスクAI(ハイリスク):規制対象

- 試験や面接の評価

- 公的支援などの受給資格の審査

- プロファイリングによる犯罪予測

- 低リスクAI:透明性義務

- チャットボットやディープフェイクでのAI使用の明示

その他の義務違反には、最大1500万ユーロまたは年間総売上高の3%の罰金が科されます。

特筆すべきは、ソーシャルスコアリングがAI利用の有無にかかわらず禁止されたことです。

これはEU条約第2条の「人間の尊厳の尊重」という理念に基づいています。

EU条約第2条では「連合は、人間の尊厳の尊重、自由、民主主義、平等、法の支配、ならびに少数派に属する人びとの権利を含む人権の尊重という価値に基盤を置いて成り立つ」と定められています。

中国のAI規制への取り組み

中国もAI規制に積極的に取り組んでいます。主な規制は以下の通りです:

- アルゴリズム推薦規制(2022年3月施行)

- レコメンド機能での国家安全保障や社会秩序を乱す行為の禁止

- ディープシンセシス規制(2023年1月施行)

- ディープフェイク技術の使用規制

- 生成AI規制(2023年8月施行)

- 生成AIサービスの運用前セキュリティ審査義務付け

カナダと日本の法整備状況

カナダでは「人工知能及びデータ法(AIDA)」の導入が進められており、2025年以降の施行が予定されています。

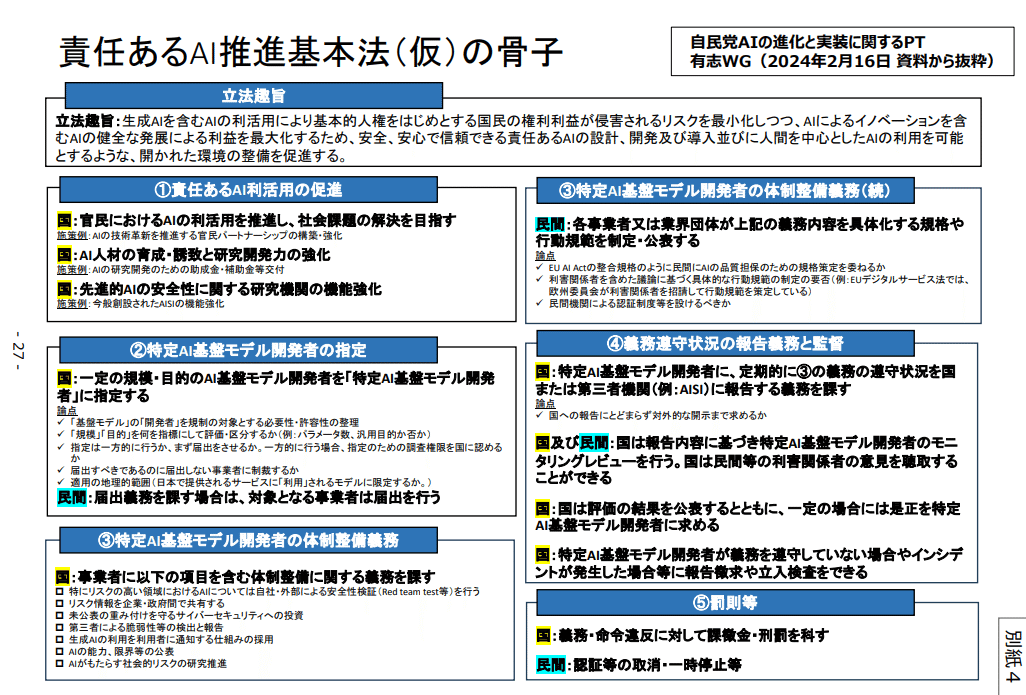

日本でも「AI推進基本法(仮)」の制定に向けた動きがあり、2024年度中に具体的な方針を明示することを目指しています。

また、2024年4月には経済産業省と総務省が協力して「AI事業者ガイドライン(第1.0版)」を公開しました。

個人の声を上げることの重要性

AI技術の急速な発展に対し、法整備が追いついていない現状があります。

このような状況下で、個人が声を上げることの重要性が増しています。過去の事例から、その意義を考えてみましょう。

産業革命時代の労働運動から学ぶ

産業革命期には、急激な経済成長の中で労働環境の悪化や格差の拡大が問題となりました。

その際、労働者や知識人たちは以下のような行動を取りました。

- 労働組合の結成

- 社会運動の展開

- 労働環境の改善や社会保障制度の確立を求める運動

これらの活動が、最終的に労働法の整備や社会保障制度の確立につながりました。

また、1990年代後半以降には「反グローバリズム運動」が起こりました。

これは、グローバル化の進展に伴う格差拡大や環境破壊に反対する市民運動で、1999年のシアトルWTO閣僚会議での大規模デモが象徴的な出来事となりました。

ハリウッドのAIストライキ事例

2023年、ハリウッドでは脚本家と俳優がAIの利用を巡ってストライキを行いました。

- 脚本家のストライキ(148日間)

- 5月2日:全米脚本家組合(WGA)がストライキ開始

- 9月27日:AIが脚本を書いたり書き直したりすることを禁止する合意で終結

- 俳優のストライキ(118日間)

- 7月14日:全米映画俳優組合(SAG-AFTRA)がストライキ開始

- 11月9日:AIによるデジタル複製の利用制限で合意し終結

このストライキの背景には、ChatGPTに代表される生成AIの急速な発展により、脚本家や俳優の仕事がAIに取って代わられることへの危機感から生じたものです。

注目すべき点として、トム・クルーズのような大物俳優もこの問題に関与しました。

トム・クルーズは俳優としての立場だけでなく、映画製作者としての側面も持っているため、彼は両者の立場を理解する特異な位置に存在し、

ストライキが行われた際には、俳優側と制作者側の交渉で妥協点を見つけられるように仲介をしようとしていました。

彼のような影響力のある人物が議論に参加することで、問題の重要性がより広く認識されることとなりました。

最終的に、AIの利用については脚本家や俳優の同意と補償を必要とすることで合意に至りました。

このストライキは、団結して声を上げることで、新しい技術がもたらす課題に対して労働者の権利を守ることができる好例となりました。

SNSを活用した個人の影響力

このようなストライキでなくとも、個人レベルであればSNSは重要なツールとなるでしょう。

AI犯罪や倫理的問題に関しても、SNSを通じて個人が声を上げ、社会に影響を与えることが可能になっています。

個人レベルでもSNSを活用して問題提起や議論の喚起を行い、社会的な関心を集めることができます。

こうした個人の声が集まり、大きなうねりとなることで、企業の方針変更や法整備の促進につながる可能性があります。

実際に、SNSを通じた個人の声が企業の行動変容や政策決定に影響を与えた事例も少なくありません。

AIによる犯罪抑止の可能性

AIは犯罪を引き起こす可能性がある一方で、犯罪を抑止する強力なツールにもなり得ます。

ここでは、AIを活用した犯罪抑止の事例を見ていきましょう。

AIによる犯罪検知と予防:最新の取り組みと課題

顔認識技術の高度な応用

AIベースの顔認識技術は、犯罪予防に新たな可能性を開いています。

この技術は混雑したエリアでの潜在的脅威の特定や、顔の表情分析による異常検出に活用されています。

特にVIPや外交官のセキュリティ維持において、法執行機関にとって大きな資源となっています。

受刑者リスク評価:HARTの事例

英国ダラム市で導入されたHART(Harm Assessment Risk Tool)は、AIを活用した革新的なアプローチを示しています。

このシステムは、釈放後の受刑者がもたらす可能性のあるリスクを評価し、保釈や仮釈放の判断材料として使用されています。

HARTは機械学習アルゴリズムを用いることで、現在の基本的なリスク評価アルゴリズムよりも進んだ分析を可能にしています。

プライバシーに関する懸念

これらの技術的進歩は社会の安全性向上に有望である一方、重要な課題も提起しています。

特に、政府による個人データ収集がプライバシー侵害の懸念を生んでいます。

関係当局はこれらのシステムを使用する前に、このような懸念を十分に考慮する必要があると指摘されています。

民間企業の取り組み

世界中のソフトウェア会社が犯罪検知・防止のためのAIプロジェクトに取り組んでいます。

現時点では、多くの民間企業が脅威を評価するための予備的なレベルでこれらの技術を活用しています。

将来的に法執行機関によって広範に導入されれば、社会はより安全で安心なものになると期待されています。

これらのAI技術は、犯罪対策に大きな可能性を秘めていますが、同時にプライバシーや倫理面での慎重な考慮が必要です。

技術の進歩と社会の安全性向上のバランスを取りながら、これらのシステムの適切な運用を模索していくことが重要です。

AI搭載防犯カメラの効果

日本でもAI搭載の防犯カメラが普及し始めています。

警察庁の「令和3年の犯罪情勢」によると、侵入犯罪の認知件数が前年比14.8%減少しました。

- 令和2年:55,515件

- 令和3年:47,325件

この減少の要因の一つとして、AI搭載防犯カメラをはじめとする高性能防犯機器の普及が挙げられています。

AIの導入により、不審な行動パターンの検知や異常の早期発見が可能となり、犯罪抑止効果が高まっていると考えられます。

革新的な防犯アプリの登場

2024年1月には、AI防犯アプリを開発する会社が設立されました。

このアプリは従来の防犯ブザーとは異なり、AIが危険を判断して自動的に以下のアクションを取ります:

- 警報を鳴らす

- 保護者に連絡

- 関係機関への通報

従来の防犯グッズでは、子供自身が危険を判断してブザーを鳴らす必要がありましたが、このアプリではAIが状況を判断するため、より確実な防犯が期待できます。

このアプリは、開発者の幼少期の性被害経験から生まれたものだそうです。個人の経験が新たな技術開発につながり、社会の安全に貢献する好例と言えるでしょう。

AI社会がもたらす新たな課題

AIによる犯罪抑止の可能性が高まる一方で、前のセクションでも言及しているように、その普及に伴う課題もあります。

プライバシーと監視社会のジレンマ

AIを活用した監視システムの普及により、私たちの日常生活が常に観察され、データ化される可能性が高まっています。

これは犯罪抑止に効果がある反面、以下のような問題を引き起こす可能性があります:

- 個人のプライバシーの侵害

- 監視されているという精神的な負担

- 収集されたデータの悪用リスク

例えば、中国で導入されている社会信用システムは、個人の行動を常時監視し評価するものですが、EUのAI規制法では明確に禁止されています。

このような対照的なアプローチは、各国の価値観や政治体制の違いを反映しています。

差別と偏見の助長リスク

AI システムの導入が進む中で、新たな形の差別や偏見が生まれる可能性が懸念されます。

特に、犯罪予測や信用評価の分野でこの問題が顕著になる可能性があります。

AI が学習するデータに人間社会の偏見が含まれていると、その偏見を増幅して結果に反映してしまう恐れがあるのです。

例えば、AI による評価結果に基づいて、特定の人種や地域に対して不当に厳しい監視が行われる可能性があります。

また、こうした評価結果によって社会的差別が拡大する危険性も指摘されています。

AI システムが個人を評価し、その結果が社会的地位や機会に大きな影響を与える可能性があるのです。

このような状況は、アニメ「PSYCHO-PASS サイコパス」で描かれた世界観を想起させます。

PSYCHO-PASSでは、「シビュラシステム」と呼ばれる AI が個人の「犯罪係数」を測定し、潜在的な犯罪者を特定します。

現実世界でも、AI による評価が個人の潜在的な危険性を判断し、それによって不当な扱いや偏見が生まれる可能性があります。

ただし、アニメのような極端な社会制御ではなく、現実では AI の判断が法執行機関の意思決定を支援する道具として使用される可能性が高いです。

それでも、AI の評価に過度に依存することで、個人の権利や自由が不当に制限されるリスクは存在します。

現実世界でも、AI による評価が「犯罪係数」のような形で個人を判断し、それによって偏見が生まれ、社会に浸透していく可能性も否定できません。

中央集権化と権力の集中問題

AI システムによる社会管理が進むと、そのシステムを管理する組織や個人に権力が集中する可能性があります。

例えば、大規模なデータを所有する企業や組織が、AIを用いてそのデータを分析し、社会や経済に関する深い洞察を得ることで、不当な優位性を獲得する可能性があります。

犯罪予測の分野では、AI が「この人物は犯罪を起こす可能性が高い」と判断した場合、それだけで個人の自由が不当に制限される可能性があります。

これは、無実の人々が不当に扱われるリスクを高めます。

ブラックスワンと反脆弱性:AI社会への新たなアプローチ

AI技術と社会の関係は、今後も予測不可能な形で変化し続けると予想されます。

この不確実性に対処するために、「ブラックスワン」の概念と「反脆弱性」の考え方が重要になってきています。

ブラックスワンとは、事前に予測不可能でありながら、発生すると大きな影響を与える出来事を指します。

新型コロナウイルスのパンデミックやリーマンショック、9.11同時多発テロなどがその例です。

このような予測不可能な事態に対処するために注目されているのが、反脆弱性の概念です。

反脆弱性を理解するために、私たちの体の免疫システムを例に考えてみましょう。

私たちの体は、日々様々な細菌やウイルスにさらされています。

これらの微生物との接触は、一見すると体に悪影響を与えそうに思えます。しかし実際には、適度な接触によって私たちの免疫システムは活性化され、より強くなります。

例えば、子どもの頃に土遊びをしたり、ペットと触れ合ったりすることで、体は様々な微生物に触れ、それに対する抗体を作ります。

この過程で免疫システムは鍛えられ、将来的により強い抵抗力を持つようになります。

一方で、過度に清潔な環境で育った子どもは、免疫システムが十分に発達せず、かえってアレルギーなどの問題を抱えやすくなることがあります。

これが反脆弱性の一例です。適度なストレスや課題に直面することで、システムはより強く、より適応力のあるものへと進化していくのです。

詳しくは、本をお読みください。

AI社会においても、この反脆弱性の考え方を取り入れることが重要です。

例えば、人間とAIの関係において、AIに全面的に依存するのではなく、人間の判断力とAIの能力を適切に組み合わせ、互いに補完し合う関係を築くことが大切です。

そうすることで、予期せぬ事態に対しても柔軟に対応できる「反脆弱な」社会システムを構築できるでしょう。

このような反脆弱なアプローチを採用することで、私たちはAI技術がもたらす予測不可能な変化にも適応し、むしろそこから新たな可能性を見出すことができるかもしれません。

結論

AI技術の急速な発展は、私たちの社会に大きな変革をもたらしています。

犯罪の形態も変化し、新たな脅威が生まれる一方で、AIを活用した犯罪抑止の可能性も広がっています。

個人レベルでの対策は依然として重要ですが、それだけでは不十分です。

社会全体での包括的な取り組み、特に適切な法整備が不可欠です。EUのAI規制法や中国の取り組みは、その先駆的な例と言えるでしょう。

同時に、私たち一人一人が声を上げ、AI社会の形成に積極的に関与していくことが重要です。

また、AIがもたらす恩恵と同時に、プライバシーの侵害や差別の助長、権力の集中といった新たな課題にも直面しています。

これらの問題に対処するためには、「反脆弱性」の考え方を取り入れ、予測不可能な変化にも適応できる柔軟なシステムを構築していく必要があります。

AI時代の社会は、技術の恩恵を最大限に活かしつつ、人間の尊厳と自由を守るバランスを取ることが求められます。