脳インプラントとAIシステムが、発話できないバイリンガルの被験者の発話を補助することに初めて成功しました。5月20日付の「Nature Biomedical Engineering」誌に発表されたこの研究は、脳がどのように言語を処理するかを明らかにし、多言語での会話が難しい人々を助けるデバイスの開発につながる可能性があります。

研究の被験者「パンチョ」は20歳で脳卒中を患い、発話が困難になりました。カリフォルニア大学サンフランシスコ校の神経外科医エドワード・チャンのチームは、パンチョの大脳皮質に電極を埋め込み、神経活動を言葉に変換してスクリーンに表示するシステムを開発しました。

パンチョの最初の言葉「家族は外にいる」は英語で解釈されてしまいましたが、パンチョの母語はスペイン語で、英語は脳卒中後に学んだものでした。そのため、研究チームはパンチョの英語とスペイン語の両方を解読するAIシステムを開発しました。

博士課程の学生アレクサンダー・シルバが主導し、パンチョが話そうとする約200語の神経パターンを学習させました。このAIシステムは、スペイン語と英語の両モジュールを使用して、パンチョの言葉を解読します。システムは最初の発語から英語とスペイン語を88%の精度で区別し、文章自体は75%の精度で解読できました。

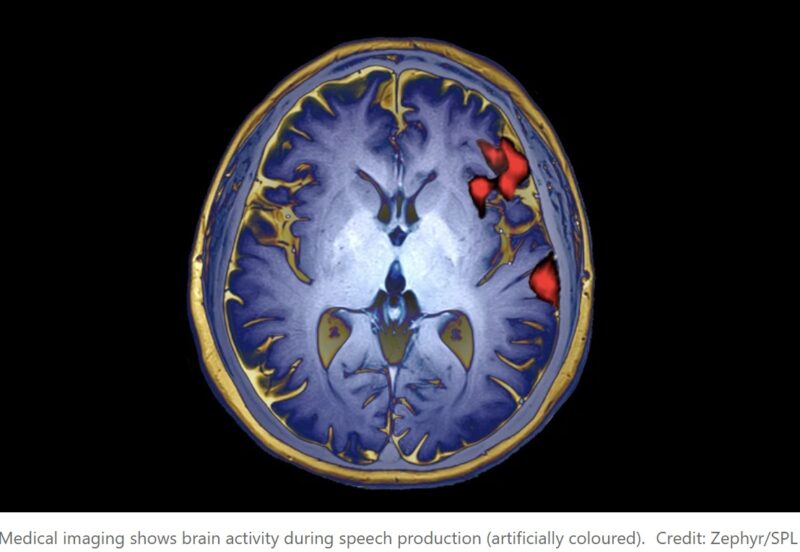

この研究は、脳の言語処理の新しい側面を明らかにしました。スペイン語と英語の両方で、脳が活性化される部分は共通しており、バイリンガルの子供たちの脳の特徴とも一致します。これにより、異なる言語でも共通の神経学的特徴があることが示唆されます。

この結果は他の人々にも適用できる可能性があります。シルバは、研究の最終目標は自然なコミュニケーション能力を提供することだと述べています。

一方で、獨協医科大学の神作憲司教授は、次のステップは英語とは異なる特性を持つ中国語や日本語などの言語についての研究だとコメントしています。